作者信息

【原文作者】 量子位

【作者简介】 追踪人工智能新趋势,关注科技行业新突破

【微 信 号】 QbitAI

文章摘要

【关 键 词】 谷歌发布、大模型、LongRoPE、华人团队、性能评估

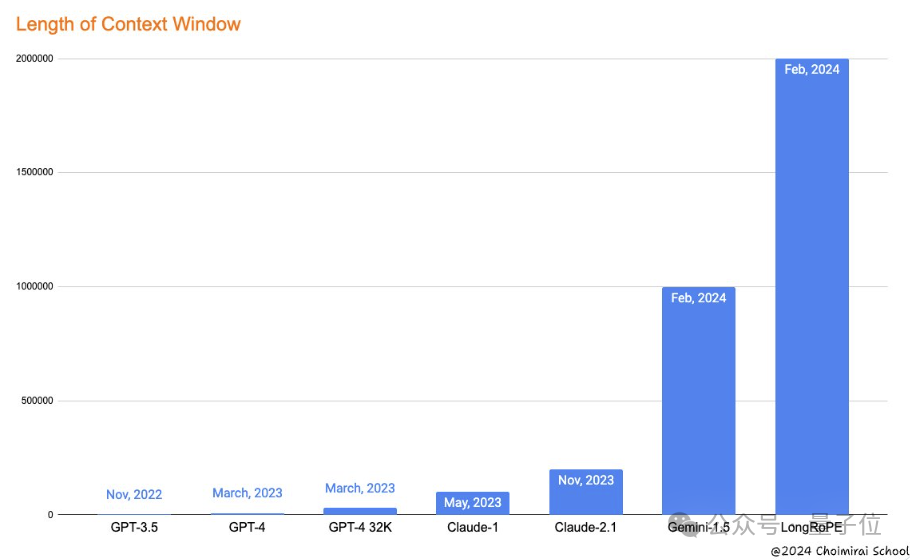

谷歌发布了支持100万token的Gemini 1.5,刷新了大模型上下文窗口长度记录。随后,微软推出了名为LongRoPE的新方法,将上下文窗口拉长至2048k token,即200多万。LongRoPE在1000步微调内完成了从短上下文到长上下文的扩展,同时保持了原来短上下文窗口的性能,降低了训练成本和时间。

LongRoPE的研究团队为纯华人团队,论文一作Yiran Ding就读于杭州电子科技大学,并在实习期间完成该项工作。该团队在LLaMA2-7B和Mistral-7B上应用LongRoPE,并从三个方面评估了其性能:在长文档上评估扩展上下文语言模型的困惑度、用Passkey检索任务评估在海量无关文本中检索简单密钥的能力以及在短4096上下文窗口长度内的标准大语言模型基准测试上评估。

LongRoPE的关键技术包括非均匀位置插值、渐进式扩展策略和短上下文窗口性能恢复。非均匀位置插值优化了位置嵌入,使模型在扩展上下文窗口的同时,能够更好地保留关键的维度和位置信息。渐进式扩展策略通过对预训练的大模型进行微调,使其适应256k长度的文本,然后在微调后模型基础上进行搜索,找到新的位置插值参数以重新缩放RoPE,最终实现2048k上下文窗口。短上下文窗口性能恢复则通过动态调整机制,使LongRoPE在处理极长文本和处理短文本时都表现良好。

LongRoPE发布后,部分网友认为RAG恐面临淘汰,但也有质疑的声音。

原文信息

【原文链接】 阅读原文

【原文字数】 1557

【阅读时长】 6分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...