文章摘要

【关 键 词】 视频生成、开源模型、低成本、高性能、技术优化

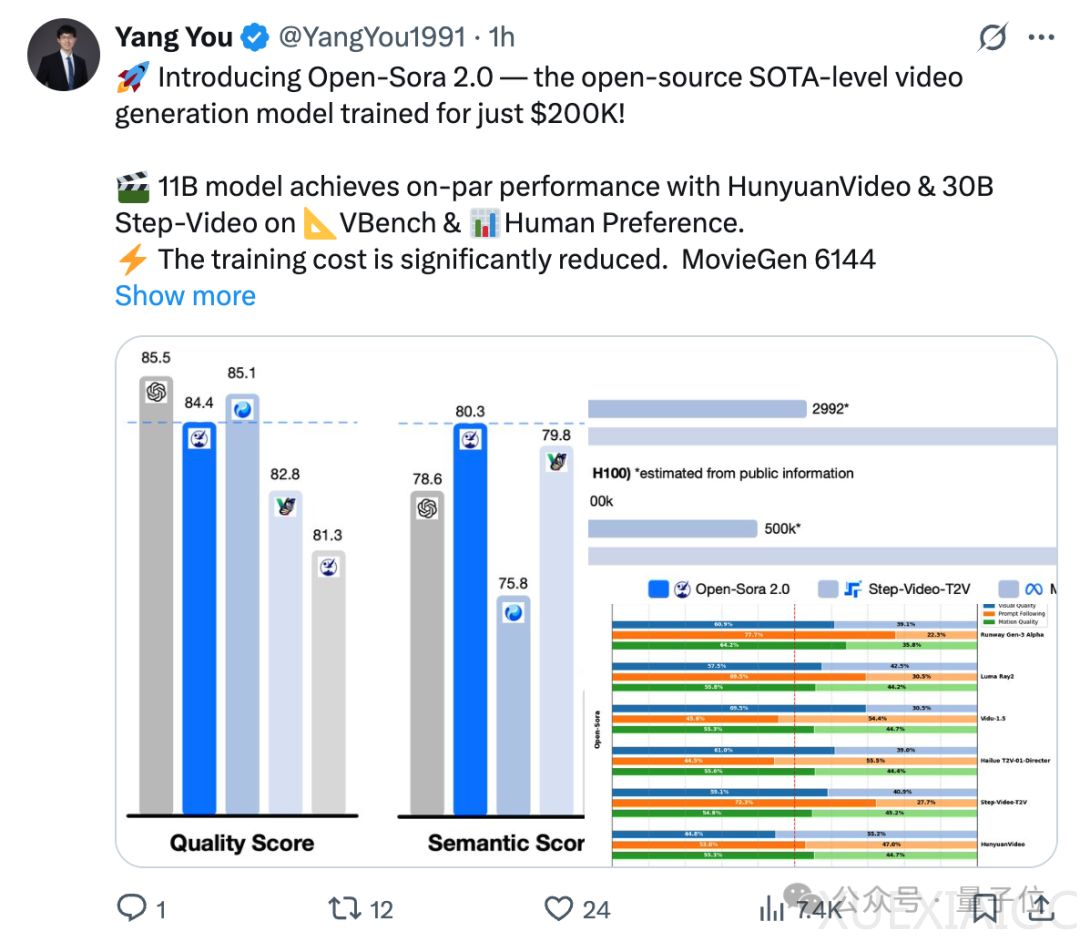

Open-Sora 2.0的发布标志着开源视频生成技术的一次重大突破。该模型采用11B参数规模,性能直追主流闭源大模型如HunyuanVideo和Step-Video,但训练成本仅为20万美元,远低于市场上动辄数百万美元的闭源模型。Open-Sora 2.0不仅开源了模型权重和推理代码,还提供了分布式训练全流程,极大降低了开发者的使用门槛。这一举措为开源社区提供了强大的技术支持,推动了视频生成技术的普及与发展。

在技术表现上,Open-Sora 2.0支持720P高分辨率和24FPS流畅度,生成的视频在动作幅度、画质和场景切换方面表现出色。无论是人物动作的流畅性,还是虚拟场景的物理规律表现,都达到了与真实世界无异的水平。在VBench和人工偏好评测中,Open-Sora 2.0在视觉表现、文本一致性和动作表现三个维度上均取得了与主流闭源模型相当的成绩,甚至在部分指标上超越了开源SOTA HunyuanVideo和商业模型Runway Gen-3 Alpha。从Open-Sora 1.2到2.0版本,其与OpenAI Sora的性能差距从4.52%缩小至0.69%,几乎实现了全面追平。

Open-Sora 2.0的成功得益于其高效的低成本训练与优化策略。通过严格的数据筛选、多阶段训练机制以及高效的并行训练方案,模型训练成本降低了5-10倍。Open-Sora团队还引入了高压缩比视频自编码器,将推理时间从单卡30分钟缩短至3分钟以内,推理速度提升了10倍。这一技术突破为未来降低视频生成成本提供了新的方向。

在模型架构上,Open-Sora 2.0延续了3D自编码器和Flow Matching训练框架,并引入了3D全注意力机制和MMDiT架构,进一步提升了视频生成质量。通过多桶训练机制,模型能够同时处理不同长度和分辨率的视频,增强了其适用性和灵活性。此外,Open-Sora还结合开源图生视频模型FLUX进行初始化,大幅降低了训练成本,实现了更高效的视频生成优化。

Open-Sora 2.0的开源生态圈也为其全球影响力奠定了基础。据第三方技术平台统计,Open-Sora的学术论文引用量在半年内获得近百次引用,稳居全球开源影响力排名首位。作为开源视频生成领域的领导者,Open-Sora不仅推动了技术进步,还通过开源全流程训练代码,成功打造了强大的社区生态。这一举措为全球开发者提供了参与AI视频革命的机会,共同推动高效、低成本的视频生成技术发展。

原文和模型

【原文链接】 阅读原文 [ 2388字 | 10分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★