端侧最强,Meta田渊栋等人卷10亿以下参数小模型,LeCun:小技巧启动

模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

作者信息

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

【微 信 号】 almosthuman2014

文章摘要

【关 键 词】 Meta、MobileLLM、模型、参数、性能

Meta 推出 MobileLLM 系列,一款适用于移动设备上的「小」模型。

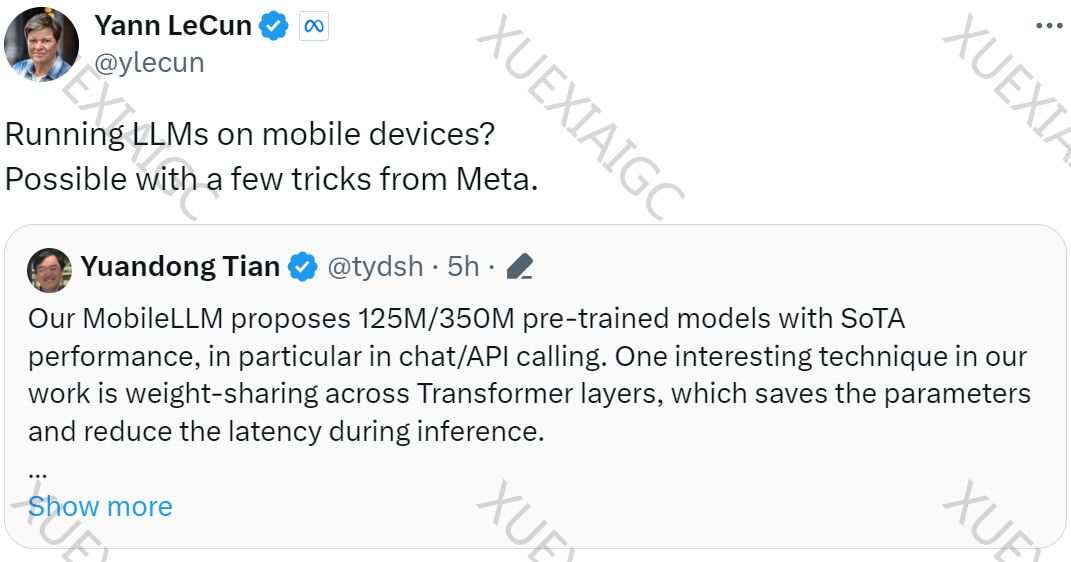

Meta 最新论文介绍了 MobileLLM,一款专为移动设备设计的小型语言模型(LLM)。图灵奖得主 Yann LeCun 对此表示关注。田渊栋指出,MobileLLM 预训练模型(125M/350M)在聊天和 API 调用方面表现出色,性能达到最先进水平。研究中还探讨了跨 Transformer 层的权重共享,以节省参数并减少延迟。

改进十亿以下参数规模的 LLM 设计

研究者提出了 MobileLLM,一个强大的基线模型,通过采用 SwiGLU FFN、深而薄的架构、嵌入共享和分组查询注意力机制,显著提高了准确率。此外,通过及时逐块权重共享方法,MobileLLM-LS 的准确率进一步提高。

训练设置与层共享

研究者在 32 个 A100 GPU 上进行实验,探索了层深度与宽度对小型 transformer 模型的影响。实验结果表明,更深的层有利于模型性能,促使研究者采用层共享策略。

实验结果

MobileLLM 在零样本常识推理、问答、阅读理解、聊天和 API 调用任务上的性能均得到验证。特别是在 API 调用任务中,MobileLLM 与规模较大的 LLaMA-v2 7B 相比,实现了相媲美的分数。此外,模型在每个 token 进行最小 / 最大训练后量化 (PTQ) 实验,展示了在移动设备上的潜力。

更多技术细节请参阅原论文。

原文信息

【原文链接】 阅读原文

【原文字数】 2050

【阅读时长】 7分钟