模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★★

文章摘要

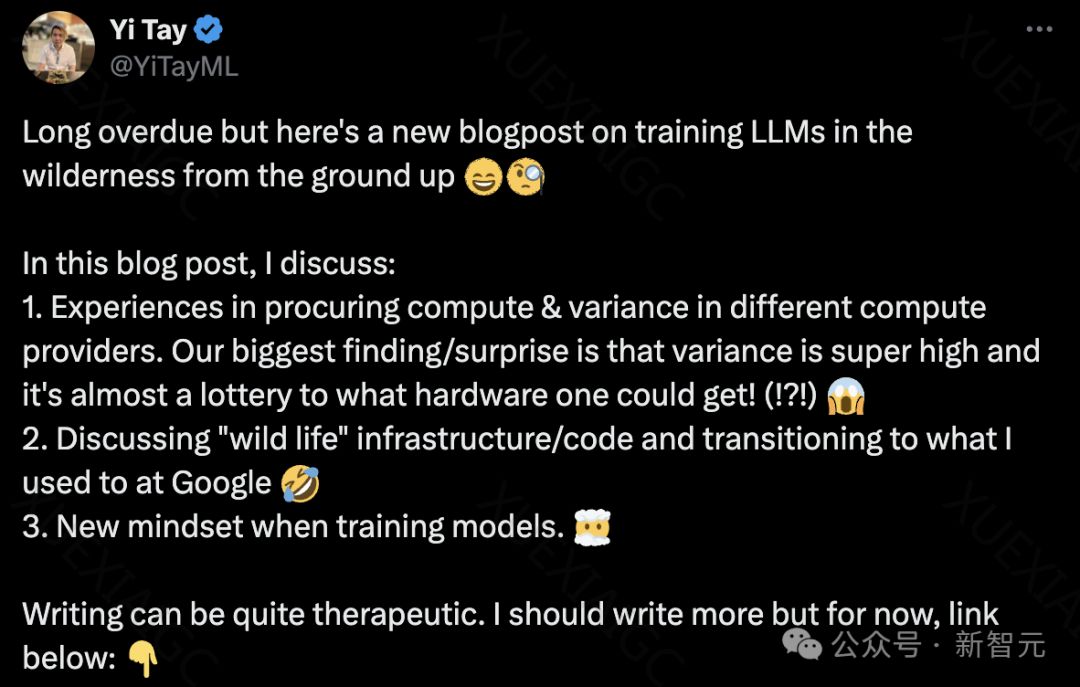

创业挑战与大模型训练

Yi Tay,前谷歌大脑科学家,分享了他在离职后创办初创公司并训练大模型的经历。他强调了算力稀缺和算力提供商之间的巨大差异是训练大模型的主要难题。Yi Tay详细描述了在不同计算提供商中采购计算资源的经验,以及如何适应野外基础设施/代码的挑战。他还讨论了训练模型时的新思维方式,以及如何在有限的资源下进行有效的模型训练。

硬件彩票与计算提供商

Yi Tay发现,即使使用相同的硬件(如GPU H100),不同计算提供商的集群质量差异巨大,这使得训练出优秀模型的过程充满了不确定性。他将这种情况比喻为“硬件彩票”,强调了在选择合适的硬件和计算提供商时的随机性。

GPU与TPU的比较

在Reka,Yi Tay主要使用GPU进行模型训练,而他在谷歌时则使用TPU。他指出,GPU的故障率远高于TPU,这可能与硬件团队的管理能力有关。他还提到,GPU领域的多节点训练似乎不如TPU的分布式训练成熟。

多集群设置的挑战

Yi Tay在Google Infra的工作经历让他对在不同集群中设置新环境感到陌生。他提到,拥有多个加速器池集群在当今世界是不可避免的,这导致了在不同地点完成工作的差异很大。他还强调了在初创公司中构建复杂ML训练基础设施的困难。

野外代码与工具开发

Yi Tay提到,他最喜欢的代码库在谷歌之外得不到太多支持,且对非谷歌员工不友好。因此,他选择了更稳定、受欢迎的代码库,如pytorch。他还提到了在外部使用谷歌代码库可能遇到的稳定性和用户友好性问题。

模型扩展与Yolo方法

在初创公司中,Yi Tay和他的团队采取了一种更直觉和本能的方法来扩展模型,而不是大科技公司的系统性方法。他们通过有限的试验和资源,成功训练出了强大的模型。

作者背景

Yi Tay是Reka的联合创始人兼首席科学家,这是一家致力于构建先进多模态AI模型的人工智能初创公司。在加入Reka之前,他在谷歌大脑工作了3.3年,为多个业界定义的LLM做出了贡献。

参考资料

Yi Tay的博客文章提供了更多关于训练大模型的详细信息和个人见解。

原文信息

【原文链接】 阅读原文

【阅读预估】 3426 / 14分钟

【原文作者】 新智元

【作者简介】 智能+中国主平台,致力于推动中国从互联网+迈向智能+新纪元。重点关注人工智能、机器人等前沿领域发展,关注人机融合、人工智能和机器人革命对人类社会与文明进化的影响,领航中国新智能时代。