文章摘要

【关 键 词】 机器狗、MAX、控制框架、智能决策、仿真训练

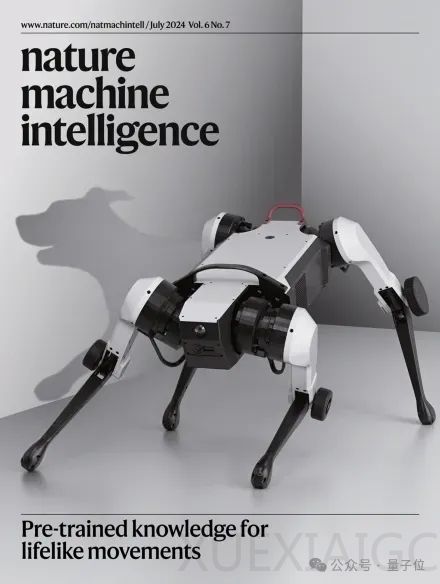

腾讯的机器狗MAX登上了《Nature》子刊封面,展示了其在定向越野游戏中的卓越表现。MAX通过模仿真实动物的运动、感知和策略,实现了对真实世界中狗的模仿,能在室内外环境中自由跑动,甚至在复杂地形中敏捷地上下楼梯和穿过障碍物。这一成果的背后,是一套全新的控制框架,采用了分层式策略和生成式模型,训练数据来自一只拉布拉多犬。

MAX的控制系统通过模仿真狗的动作,规划出更高级的策略,完成了追逐大战等复杂任务。在与人类控制的机器狗的竞技中,纯机器方案展现出更高的灵活性和效率。这一控制框架的最大优势在于其通用性,可以针对不同的任务场景和机器人形态进行预训练和知识复用,未来有望应用于人形机器人和多智能体协作场景。

研究人员设计的控制框架包括原始运动控制器(PMC)、环境适应控制器(EPMC)和策略控制器(SEPMC),分别对应原始级、环境级和策略级知识。训练过程从PMC开始,逐步向上训练,最终实现机器人的认知和规划能力。通过多智能体强化学习算法PFSP,机器人在仿真环境中不断提升策略水平,然后以零样本迁移到真实环境。

MAX的训练数据来源于对一只训练有素的中型拉布拉多犬的运动捕捉,通过逆运动学方法将狗狗的关节运动数据重定向到机器人关节。PMC的训练目标是最小化生成的运动轨迹与参考轨迹之间的偏差,通过向量量化技术构建离散潜在空间。EPMC引入环境感知模块,根据当前环境状态动态调整运动模式。SEPMC进一步提升机器人的高层策略决策能力。

整个训练过程在仿真环境中完成,通过随机化大量物理参数,强化学习得到的策略必须能够应对变化,实现稳定和通用的控制能力。未来,研究人员将进一步整合多模态感知输入,如LiDAR、Audio等,以更好地应对复杂环境。这项研究为机器人的自主运动和智能决策提供了新的思路和方法,有望推动机器人技术在更多领域的应用和发展。

原文和模型

【原文链接】 阅读原文 [ 2406字 | 10分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★