陈丹琦等人组织的COLM奖项公布:被ICLR拒稿的Mamba入选杰出论文

文章摘要

【关 键 词】 语言建模、学术会议、Mamba模型、知识截止、端侧AI

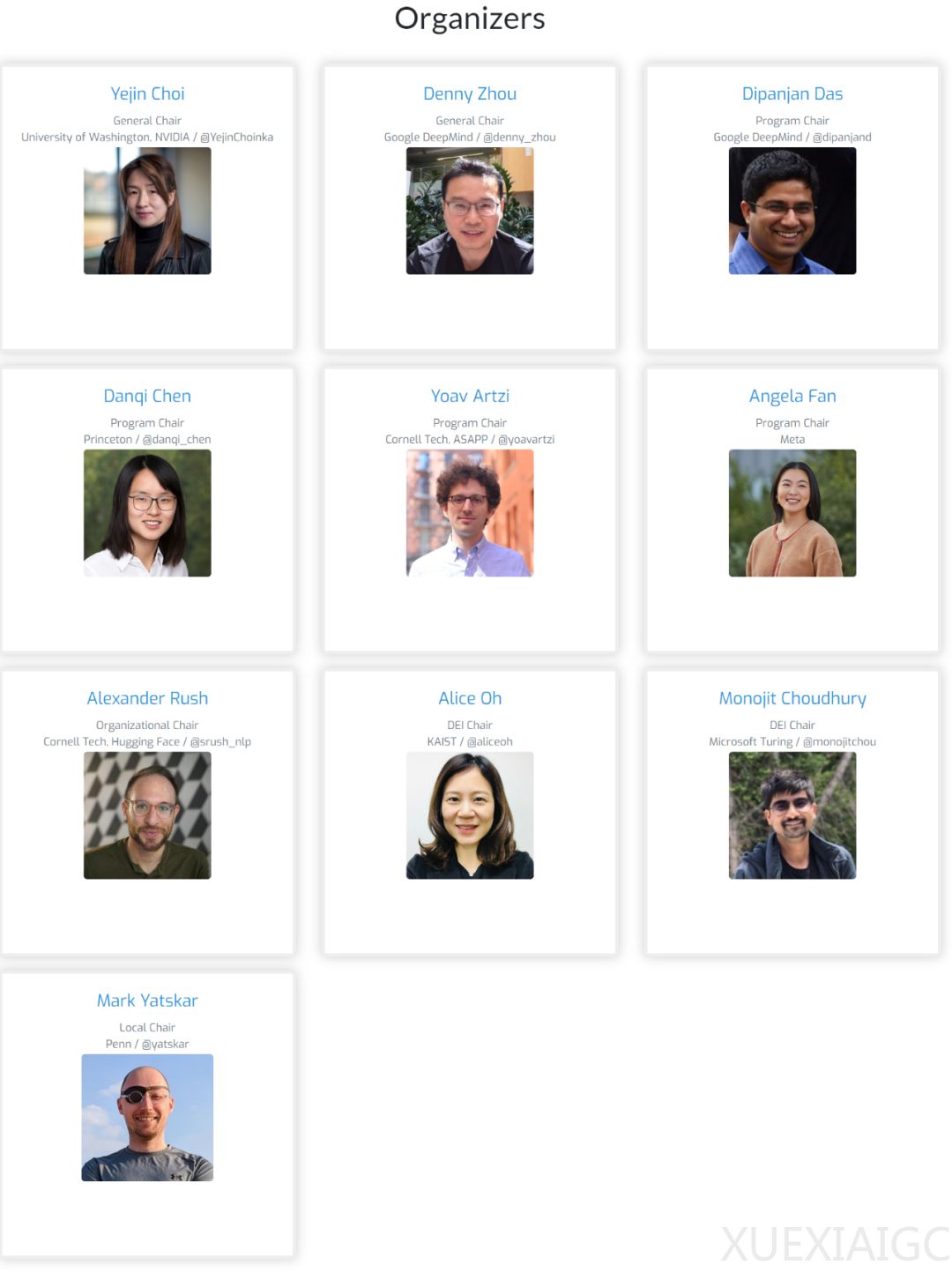

2023年,一群在自然语言处理(NLP)领域取得显著成就的青年学者,包括业界和学术界的研究人员,组织了一个新的专注于语言建模研究的学术会议,名为COLM(Conference on Language Modeling)。该会议旨在建立一个多学科背景的研究人员社区,以促进语言模型技术的发展和合作。

2024年,COLM公布了四篇杰出论文奖,其中Mamba模型的研究引起了广泛关注。Mamba模型旨在解决Transformer架构在处理大型模型和长序列时的计算效率问题。该模型通过改进选择性状态空间(SSM)的概念,实现了线性时间序列建模,显著提高了推理吞吐量,并在多种模态上达到了最先进的性能。

第一篇获奖论文来自霍普金斯大学,研究了大型语言模型(LLM)的“知识截止日期”问题。研究者们提出了一种新的方法来估计LLM在资源级别的有效截止点,而无需访问模型的预训练数据。研究发现,有效的截止值通常与报告的截止值存在显著差异。

第二篇获奖论文,即Mamba模型的研究,由卡内基梅隆大学和普林斯顿大学的研究人员共同完成。他们提出了一种新的序列模型架构,通过硬件感知算法和简化的深度序列模型设计,实现了高效的卷积运算。

第三篇论文由俄罗斯AI基金会与算法实验室、英国伦敦玛丽女王大学、日本Noeon研究所和斯科尔科沃科学技术学院的研究人员合作完成。他们探讨了如何检测人类写作与机器生成文本的界限,这是一个尚未得到足够关注的挑战。

第四篇论文由哈佛大学和斯坦福大学的研究人员撰写,研究了任务要求对小型语言模型能力的影响。研究表明,任务要求较高的评估方法可能导致性能下降,尤其是在参数较少和训练数据较少的模型中。

此外,COLM会议还宣布了即将在上海举行的“端侧AI大模型开发与应用实践”技术论坛,旨在帮助企业探索端侧大模型的机遇,并为研发人员提供提升技能的平台。

原文和模型

【原文链接】 阅读原文 [ 2120字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★