文章摘要

【关 键 词】 多模态理解、文档识别、阿里开源、mPLUG-DocOwl、SOTA成果

阿里巴巴的mPLUG团队发布了最新的开源工作mPLUG-DocOwl 1.5,这是一个针对多模态文档理解的大模型,它在处理高分辨率图片文字识别、通用文档结构理解、指令遵循和外部知识引入四大挑战方面取得了显著进展,并在多个基准测试中取得了新的最佳成绩(SOTA)。

mPLUG-DocOwl 1.5的核心在于它的多模态文档理解能力,这使得它能够处理结构复杂的文档图片,如图表、信息图和网页等。这一能力对于大语言模型的实际应用至关重要,因为市面上的许多文档阅读辅助产品仍然依赖于OCR系统进行文字识别,而mPLUG-DocOwl 1.5则能够在不依赖OCR的情况下实现更高级的文档理解。

在挑战一中,mPLUG-DocOwl 1.5通过采用切图策略,有效地处理了文档图片的多样化形状和大小,这种策略允许模型利用现有的通用视觉编码器进行文档理解,从而减少了重新训练高分辨率视觉编码器的成本。

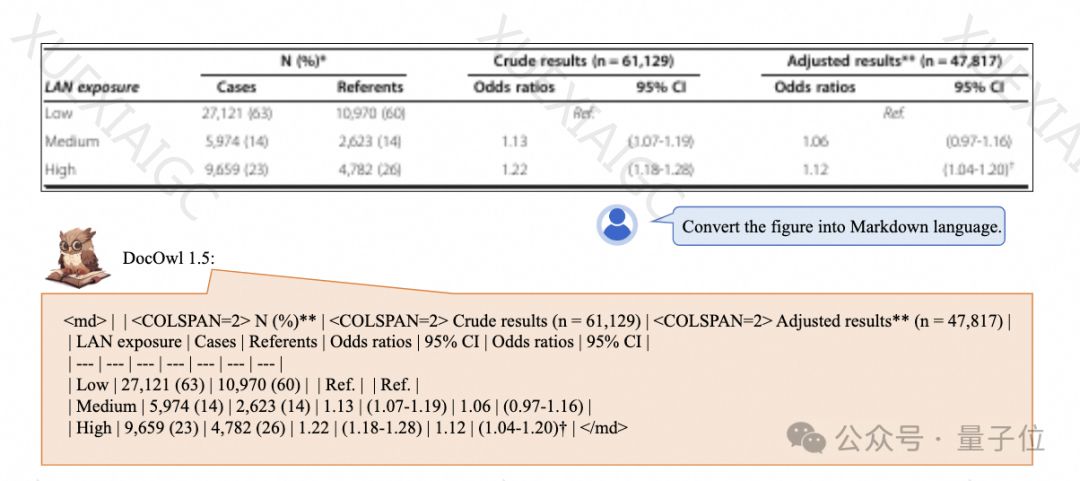

挑战二聚焦于通用文档结构理解,mPLUG-DocOwl 1.5通过模型结构优化和训练任务增强,提高了对文档内容语义和结构的理解能力。特别是,它采用了H-Reducer进行特征聚合和对齐,这种基于卷积和全连接层的方法比以往的方法更有效地保留了视觉特征之间的相对位置关系。

在挑战三中,mPLUG-DocOwl 1.5通过多任务联合训练,将多个下游任务统一为指令问答的形式,从而实现了一个文档领域的通用模型。此外,它还引入了详细解释数据(DocReason25K),以增强模型的详细解释能力。

挑战四探讨了如何引入外部知识以更好地理解文档图片。mPLUG团队提出了mPLUG-PaperOwl,并构建了一个高质量的论文图表分析数据集M-Paper,这是引入外部知识进行文档理解的初步尝试。

尽管mPLUG-DocOwl 1.5在文档理解方面取得了显著进步,但与闭源大模型和现实需求相比,仍有较大的差距。mPLUG团队计划进一步优化DocOwl的性能并进行开源,以便社区能够持续关注和参与讨论。相关的GitHub和论文链接也已提供,供感兴趣的人进一步探索和研究。

原文和模型

【原文链接】 阅读原文 [ 2337字 | 10分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-4

【摘要评分】 ★★★★★