模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★★

文章摘要

【关 键 词】 AI图生视频、EMO模型、阿里巴巴、音频驱动、面部表情

摘要:

阿里巴巴集团智能计算研究院推出了一款名为EMO(Emote Portrait Alive)的AI图生视频模型。EMO能够根据用户提供的一张照片和音频文件生成具有丰富面部表情和多种头部姿态的语音头像视频。该模型的训练涉及超过250小时的视频和1.5亿张图像,覆盖多种语言和内容。尽管EMO的相关论文已在arXiv发表,但其GitHub仓库为空,引发了开发者对其开源性的质疑。

详细摘要:

1. EMO模型介绍:

– EMO是一种音频驱动型肖像视频生成框架,用户只需提供一张照片和音频文件,即可生成具有丰富表情和头部姿态的视频。

– 阿里通过收集大量视频和图像数据,建立了多样化的数据集,为模型训练提供基础。

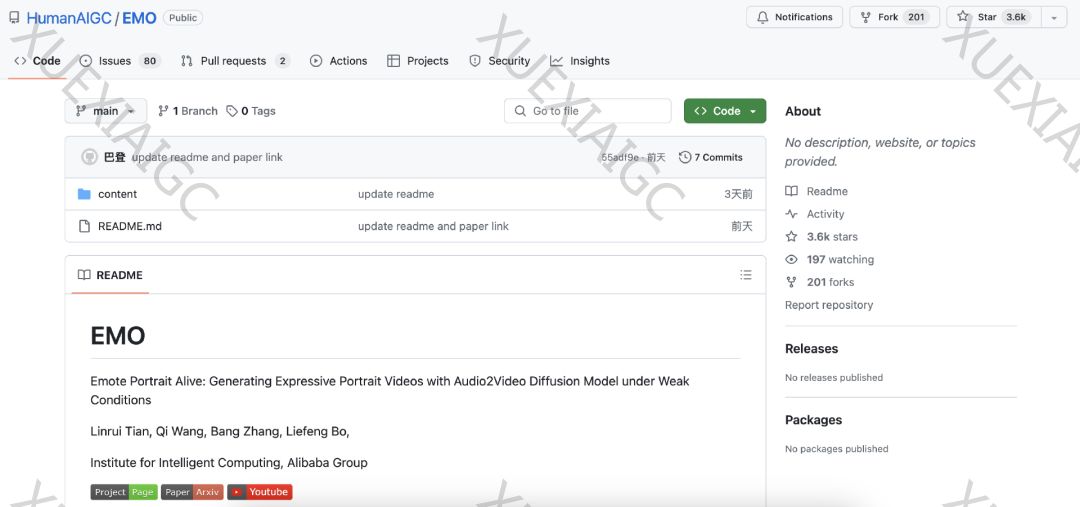

2. 开源与GitHub争议:

– EMO的论文已在arXiv发表,但GitHub上的同名仓库为空,引起了开发者的不满和质疑。

– 尽管有开发者愿意为EMO的API接口付费,但目前阿里官方尚未对此作出回应。

3. EMO的训练过程:

– 阿里提出了一种新的扩散模型生成方法,简化了语音头像视频的创建过程,提高了视觉和情感保真度。

– 模型中添加了速度控制器与面部区域控制器,以增强生成过程中的稳定性。

4. 扩散模型与音频驱动头像生成:

– 扩散模型在图像合成、编辑、视频生成等领域展现出卓越功能。

– 音频驱动的头像生成技术分为基于视频和基于单图像的方法,EMO采用了后者。

5. EMO框架设计:

– EMO框架包括帧编码和扩散过程两个阶段,采用Stable Diffusion作为基础框架。

– 训练策略分为图像预训练、视频训练和速度层训练三个阶段。

6. 局限性与未来展望:

– EMO方法在视频质量上具有优势,但仍存在耗时和可能生成伪影的问题。

– 阿里正在探索使用专门针对身体部位的控制信号来解决这些问题。

7. 活动推荐:

– QCon全球软件开发大会暨智能软件开发生态展将于2024年4月在北京举行,目前已进入早鸟购票阶段。

8. 相关阅读:

– 文章还提到了其他AI领域的新闻,如谷歌决策、OpenAI与微软的合作、字节跳动的文生图开放模型等。

原文信息

【原文链接】 阅读原文

【阅读预估】 3321 / 14分钟

【原文作者】 AI前线

【作者简介】 面向AI爱好者、开发者和科学家,提供大模型最新资讯、AI技术分享干货、一线业界实践案例,助你全面拥抱AIGC。