文章摘要

阿里巴巴最新发布的推理模型QwQ-32B,以其320亿参数的规模,展现了与6710亿参数的DeepSeek-R1相媲美的性能。这一突破意味着,在更小的设备上运行更强大的推理模型成为可能。QwQ-32B已经采用Apache 2.0协议开源,进一步推动了技术的普及和应用。

Qwen团队在博客中提到,他们发现强化学习(RL)有可能超越传统的预训练和后训练方法,从而提升模型的推理能力。QwQ-32B的成功证明了这一路径的可行性,为阿里巴巴在大模型行业中探索通往人工通用智能(AGI)的道路提供了新的思路。通过强大的基础模型叠加大规模强化学习,阿里巴巴或许已经找到了一个有效的技术方向。

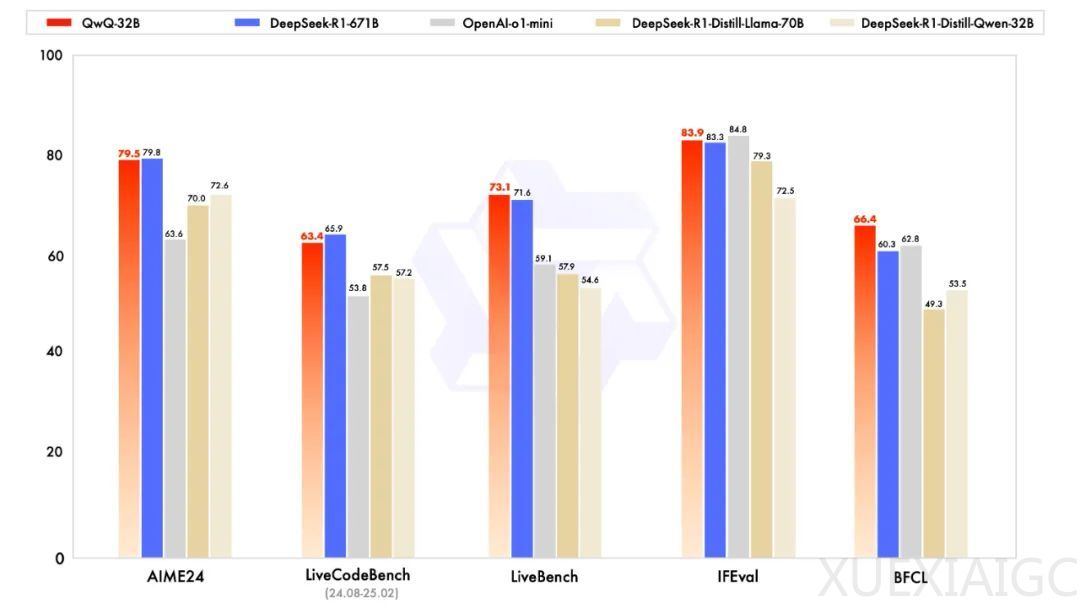

在基准测试中,QwQ-32B的表现直接超越了DeepSeek-R1和OpenAI-o1-mini,同时显著降低了部署成本。这一成果标志着开源世界技术竞赛的新高度。去年11月底,阿里巴巴曾发布QwQ-32B-Preview版本,虽然当时未引起广泛关注,但此次正式版本的发布无疑是一次重大突破。

QwQ-32B的部署门槛大幅降低,仅需一台24G显存、16核CPU、64G内存的机器即可运行,使得本地部署强大的推理模型成为现实。这一技术进步不仅减少了硬件需求,还为未来在手机、手表、电脑等设备上运行推理模型铺平了道路。

此外,ollama已经集成了QwQ-32B,用户可以通过简单的命令直接部署,进一步降低了使用门槛。DeepSeek R1此前通过整合冷启动数据和多阶段训练,展示了在有限硬件条件下保持高性能的可能性。而QwQ-32B则通过强化学习,证明了其在提升模型性能方面的潜力。

QwQ-32B的发布,标志着推理模型领域的一次重大变革。它不仅改变了游戏规则,还为本地部署强大推理模型提供了新的可能性。用户可以通过访问Qwen,选择Qwen2.5-plus,并点击深度思考,第一时间体验这一模型。QwQ-32B的成功,预示着未来推理模型将更加高效、普及,并广泛应用于各类设备中。

原文和模型

【原文链接】 阅读原文 [ 719字 | 3分钟 ]

【原文作者】 AI产品阿颖

【摘要模型】 deepseek-v3

【摘要评分】 ★☆☆☆☆