文章摘要

【关 键 词】 阿里开源、Qwen 1.5-32B、性能评测、弱智吧Benchmark、GQA技术

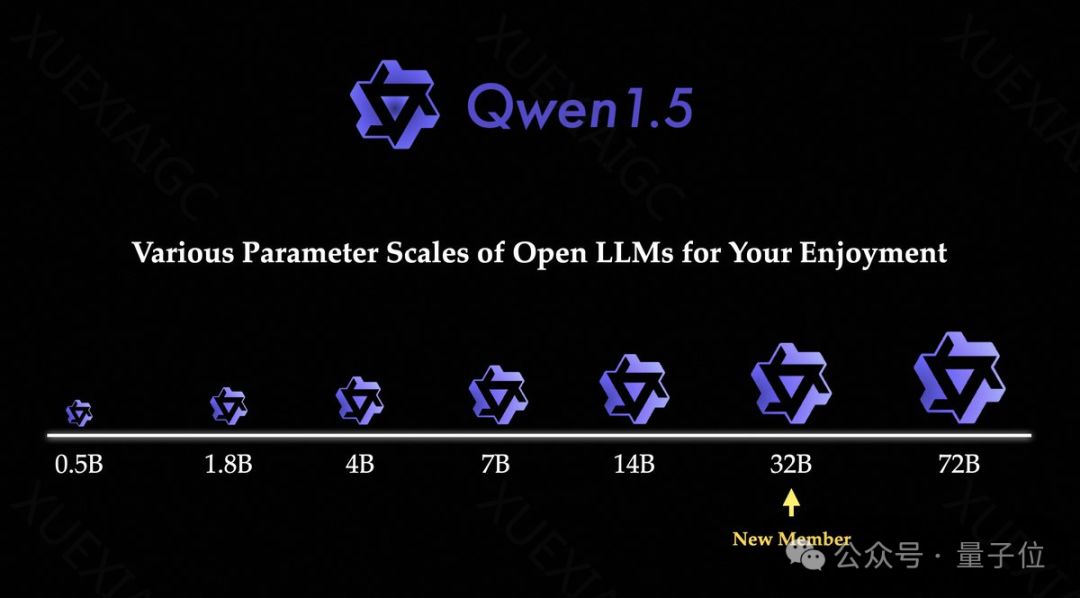

阿里巴巴开源新模型

阿里巴巴近期开源了其最新的人工智能模型“通义千问”(Qwen)1.5-32B版本,这是1.5系列的最后一块拼图。该模型在多项评测标准中超越或追平了Mixtral 8x7B模型,并展现出与72B模型相当的性能,尤其在语言理解、多语言支持、编码和数学能力等方面表现出色。此外,Qwen 1.5-32B在推理和部署过程中的成本更加友好。

评测成绩亮眼

Qwen 1.5-32B在多项评测中的成绩十分亮眼,即使与其他体量相当的大模型相比,其表现依旧出色。团队还进行了一项有趣的长文本评估任务“大海捞针”,通过这项任务测试模型能否在大量文本中准确提取出一个与文本无关的隐藏句子。结果显示,Qwen 1.5-32B在处理32k tokens的上下文时表现良好。

“弱智吧Benchmark”测试

“弱智吧Benchmark”是检测大模型逻辑能力的一种非正式标准,源自一个中文社区,其中充满了荒谬和不合常理的发言。Qwen 1.5-32B在这一测试中表现出色,能够准确回答一系列充满逻辑陷阱的问题,显示出其强大的逻辑推理能力。

GQA技术的应用

Qwen 1.5-32B之所以能在较小的体量下保持优异的性能,并快速部署,关键在于引入了GQA(Grouped Query Attention)技术。GQA是一种Transformer架构中的机制,通过将查询序列分组为多个子序列来提高模型的计算效率,减少计算复杂度,同时保留模型的表示能力。GQA通过混合Multi-Query Attention的速度与Multi-Head Attention的质量,实现了在质量和速度之间的平衡。

在线体验和进一步探索

Qwen 1.5-32B的在线体验demo已经发布,允许用户直接体验模型的性能。此外,模型在HuggingFace平台上也提供了体验入口,感兴趣的用户可以进一步探索和体验Qwen 1.5-32B的能力。这一开源行为可能会推动AI领域的进一步发展,特别是在自然语言处理和机器理解方面。

原文和模型

【原文链接】 阅读原文 [ 1156字 | 5分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-4

【摘要评分】 ★★☆☆☆