重磅!淘天联合爱橙开源强化学习训练框架ROLL,高效支持十亿到千亿参数大模型训练

文章摘要

【关 键 词】 强化学习、大模型、开源框架、智能体、训练效率

过去几年,基于人类偏好的强化学习(RLHF)成为大语言模型(LLM)后训练阶段的关键技术,显著提升了模型的对齐能力,并拓展了其在推理增强、智能体交互等场景下的应用边界。围绕这一核心范式,研究社区不断演化出多种优化策略和算法变体,如 Agentic RL、RLAIF、GRPO、REINFORCE++ 等。这些新兴范式虽然形式各异,但底层需求高度一致:几乎都涉及多模块协同与多阶段流程的高效调度,这对训练框架提出了更高的要求。

近日,淘天集团携手爱橙科技开源了全新一代强化学习训练框架 ROLL(Reinforcement Learning Optimization for Large-scale Learning)。ROLL 以用户体验为核心设计理念,专为「高效・可扩展・易用」而打造,彻底打通从小模型到 600B+ 超大模型的 RL 训练落地路径。 ROLL 在人类偏好对齐、复杂推理和多轮自主交互场景等关键领域显著提升了大语言模型的性能,同时具备超高的训练效率,已成功应用在多个淘天集团内部业务场景,为业务创新提供了强大的技术支持。

ROLL 具有多项关键特性:多任务强化学习,支持数学、代码、通用推理、开放式问答、指令遵循等任务;智能体强化学习,原生支持多环境、多角色智能体 – 环境交互;算法友好,提供灵活的 RL 策略配置;丰富的训推引擎,支持 vLLM、SGLang、Megatron-Core、DeepSpeed 等主流推理 / 训练引擎;弹性资源调度与分布式并行,基于 Ray 的多角色分布式架构,灵活资源分配;极致易用与模块化扩展,简化 pipeline 开发和调试;样本级调度与动态采样,显著提升训练效率与资源利用率;可观察性,集成 wandb / swanlab / tensorboard,支持实时跟踪性能。

ROLL 针对技术先驱者、产品开发者和算法研究者三类用户群体设计。对于技术先驱者,支持异构大规模 GPU 集群下的弹性扩展与容错,极大降低训练成本和中断风险。 对于产品开发者,可灵活配置奖励函数、环境、采样比例与数据配比,轻松实现各种任务场景的 RL 训练落地。对于算法研究者,单卡 / 少卡资源下也能高效实验,所有模块高度抽象,极易实现自定义 RL 算法、奖励与环境,极大缩短从想法到验证的周期。

ROLL 的技术细节包括:基于单控制器架构的并行工作器抽象,简化新想法的实验过程;优化后的并行策略和数据传输模块,实现快速、可扩展且容错的训练;Rollout 调度器,简化响应生成、环境交互和奖励计算之间的流程编排;环境工作器和奖励工作器,提供高效且可扩展的智能体环境交互和奖励计算;资源池和 AutoDeviceMapping,实现高效的工作器调度和资源的优化分配。

在 Qwen2.5-7B-base 与 Qwen3-30B-A3B-base 等模型上,ROLL 取得了显著的跨领域多任务性能提升。例如,在 RLVR pipeline 训练下,Qwen2.5-7B-Base 的整体准确率从 0.18 提升至 0.52(2.89 倍),Qwen3-30B-A3B-Base 准确率从 0.27 提升至 0.62(2.30 倍)。 此外,ROLL 在智能体交互场景中同样展现了强大的稳健性,在 Sokoban、FrozenLake 和 WebShop 等典型环境下均取得了显著的成功率提升。

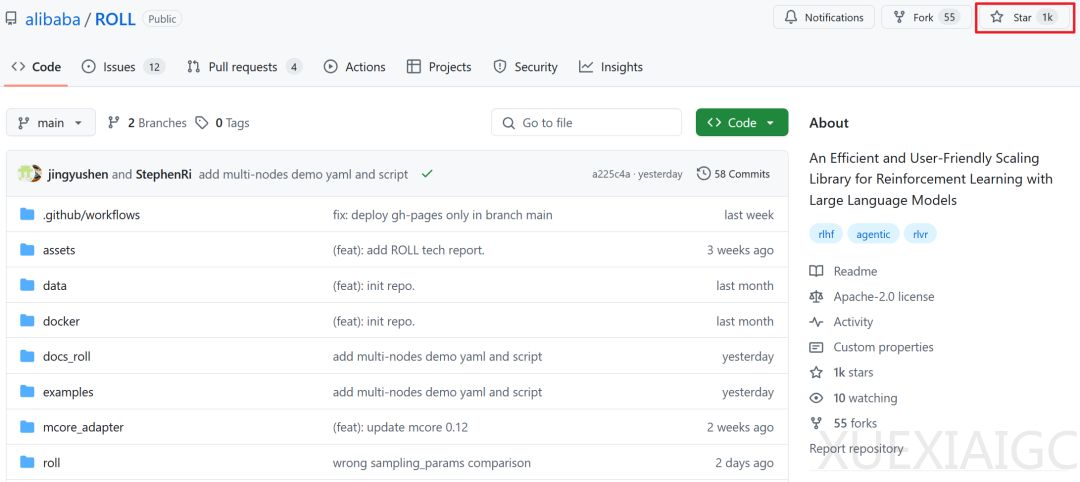

ROLL 已在 GitHub 上线,并在短时间内收获大量 star。项目仍在持续迭代,未来将支持 Qwen2.5 VL Agentic RL、一步式异步 pipeline、FSDP2、DeepSeekV3 等新特性。开源精神是推动技术发展的核心引擎,ROLL 研发团队期待更多优质人才加入,共同推动技术的进步。

原文和模型

【原文链接】 阅读原文 [ 2989字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★