选择/杂交/突变,DeepMind将自然选择引入LLM思维,实现心智进化

文章摘要

【关 键 词】 推理优化、进化搜索、自然语言、性能提升、计算效率

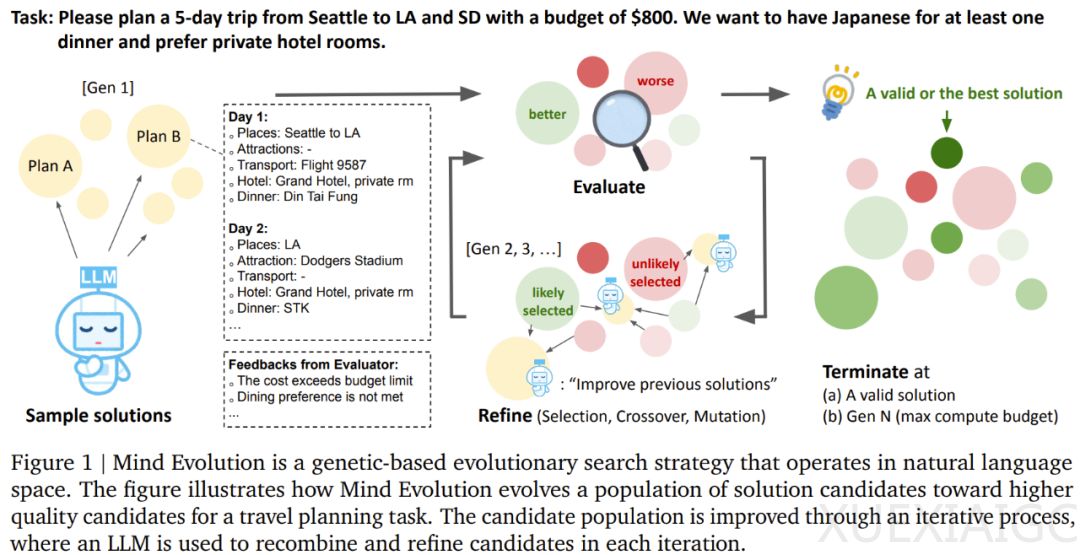

最近,DeepSeek 和 Kimi 的推理模型更新引起了广泛关注。同时,谷歌 DeepMind、加州大学圣地亚哥分校和阿尔伯塔大学的研究者发表了一篇题为《Evolving Deeper LLM Thinking》的论文,提出了一种名为 Mind Evolution 的进化搜索策略,用于优化大型语言模型(LLM)在推理时的计算效率。实验结果显示,在相同的推理成本下,Mind Evolution 在自然语言规划任务中的表现超过了 Best-of-N 和 Sequential Revision 等其他推理策略。

Mind Evolution 结合了遗传搜索策略和定制的提示集,通过 LLM 强大的语言理解和生成能力,实现有效的搜索和重组操作。该策略的核心组件包括选择和迁移操作、提示集、适应度函数,以及通过批评性对话进行优化的过程。适应度评估函数用于评估解的质量,并提供反馈。种群初始化通过 LLM 生成初始解,并通过 RCC 过程进行改进。选择操作采用玻尔兹曼锦标赛选择方法,杂交和突变则通过 RCC 过程实现。岛屿间迁移和岛屿重置操作有助于维持种群多样性。

在三个基准自然语言规划领域(Natural Plan 的 Trip Planning 和 Meeting Planning,以及 TravelPlanner 基准)上,Mind Evolution 显示出了优越的性能。在 TravelPlanner 任务中,Mind Evolution 的成功率超过 95%,显著高于其他基线策略。在 Trip Planning 任务中,Mind Evolution 的成功率分别为验证集 96.2% 和测试集 94.1%。在 Meeting Planning 任务中,Mind Evolution 的成功率分别为验证集 85.0% 和测试集 83.8%。此外,该团队还提出了一个新任务 StegPoet,要求将隐藏消息通过隐写术编码到创意写作文章中,Mind Evolution 在这个任务上也显示出了较高的成功率。

总体而言,Mind Evolution 通过其进化搜索策略,在多个自然语言规划任务中表现出了卓越的性能和计算效率,为 LLM 的推理优化提供了一种新的解决方案。

原文和模型

【原文链接】 阅读原文 [ 4394字 | 18分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆