选择性遗忘可以帮助AI更好地学习

模型信息

【模型公司】 OpenAI

【模型名称】 gpt-3.5-turbo-0125

【摘要评分】 ★★★☆☆

文章摘要

【关 键 词】 机器学习、遗忘、语言理解、神经网络、模型训练

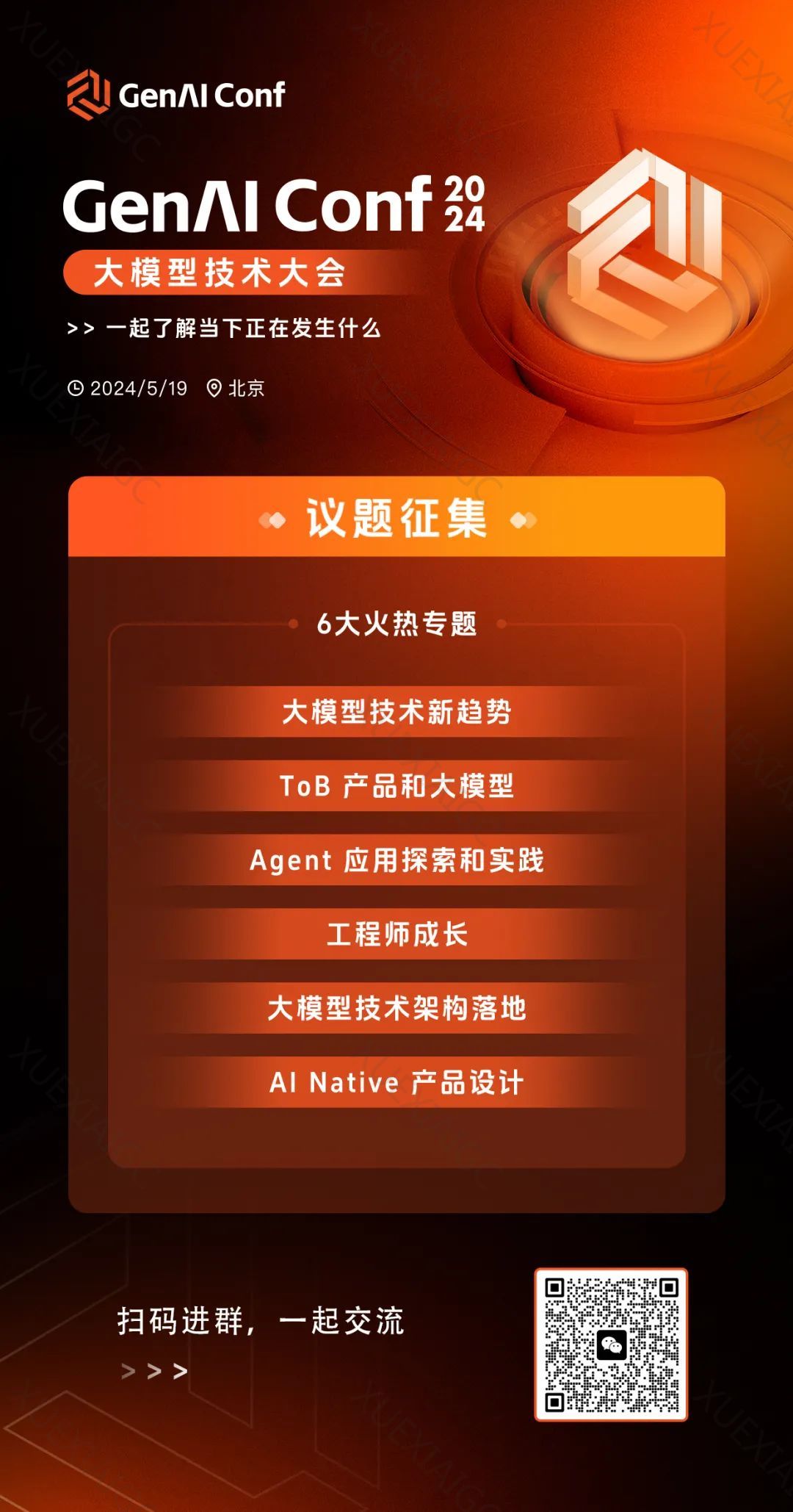

最近一组计算机科学家开发了一种需要定期“遗忘”已学到信息的灵活和敏捷的机器学习模型。这种新方法虽不太可能取代目前大型应用所依赖的庞大模型,但有助于更深入了解语言理解。AI语言引擎通常依赖于人工神经网络,其中神经元通过信息传递进行计算。研究人员采取了一种新策略,通过删除网络对于词汇构成要素的记忆,然后重新训练模型,成功地使其学习并处理新语言。这种“遗忘”方法虽然复杂,但能有效地向已训练的模型中添加新语言。研究团队使用了定期遗忘技术对常见语言模型Roberta进行训练,结果表明遗忘模型在重新训练过程中表现更好。这种方法使模型在学习语言能力上更为优越,类似于人类大脑的工作方式,倾向于记住经验的要点并进行抽象和推理。研究人员希望这种更加灵活的遗忘语言模型能够将最新的AI突破带给更多语言,实现一个更多元化的AI世界。GenAI Conf大模型技术大会将于5月19日在北京举行,聚焦大模型技术新趋势、ToB产品、Agent、工程师成长、大模型技术架构落地和AI Native等话题,欢迎对大模型技术感兴趣的同学参加。

原文信息

【原文链接】 阅读原文

【阅读预估】 1785 / 8分钟

【原文作者】 AI大模型实验室

【作者简介】 关注大模型技术的创新与发展,探索大模型的实际应用,探讨 AI 未来对企业与社会发展的影响。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...