这篇论文非常火!差分Transformer竟能消除注意力噪声,犹如降噪耳机

文章摘要

【关 键 词】 Diff Transformer、语言模型、差分注意力、模型性能、技术论坛

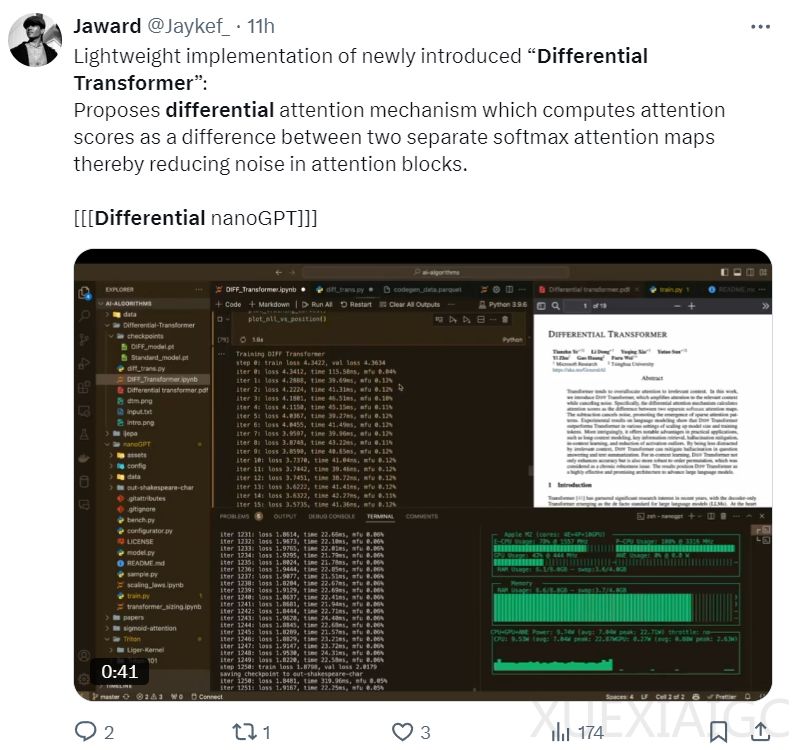

微软研究院和清华大学的研究团队提出了一种新型的Transformer架构——Differential Transformer(简称Diff Transformer),旨在解决传统Transformer在处理大型语言模型(LLM)时的一些问题。Diff Transformer通过引入差分注意力机制来减少注意力噪声,从而增强模型对上下文的建模能力。

在设计上,Diff Transformer采用了仅解码器模型,并通过差分注意力模块和前向网络模块的堆叠构建。与传统Transformer相比,Diff Transformer的主要区别在于其差分注意力机制,该机制通过使用两个softmax函数来消除噪声,类似于电气工程中的降噪耳机和差分放大器。

实验结果显示,Diff Transformer在语言建模、可扩展性、长上下文处理、关键信息检索、上下文学习能力、上下文幻觉以及激活异常值分析等多个方面均优于传统Transformer。具体来说,Diff Transformer在3B规模的语言模型上的表现优于传统模型,并且在模型规模和训练token数量方面的可扩展性也更优。此外,Diff Transformer在处理长上下文时能够更有效地利用上下文信息,且在关键信息检索任务中,其多针检索准确度也更高。

在上下文学习能力方面,Diff Transformer在多样本分类和上下文学习的稳健性上均优于传统Transformer。在上下文幻觉评估中,Diff Transformer也展现出更低的幻觉现象。此外,Diff Transformer还能降低激活异常值的幅度,有助于实现更低的量化位宽。

研究团队还进行了消融实验,证明了新设计的有效性。总体而言,Diff Transformer通过其差分注意力机制,有效地提升了模型在处理大型语言模型任务时的性能和稳定性。

此外,文章还提到了一个即将在上海举行的「端侧 AI 大模型开发与应用实践」技术论坛,该论坛将汇聚端侧大模型领域的领先技术和应用企业代表,通过技术报告、应用实践、实操演练等环节,帮助参与者全方位掌握端侧大模型的部署应用。

原文和模型

【原文链接】 阅读原文 [ 2948字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★