质疑DeepSeek-R1、Claude Thinking根本不会推理!苹果争议论文翻车了?

文章摘要

【关 键 词】 AI研究、推理能力、模型评估、算法谜题、性能崩溃

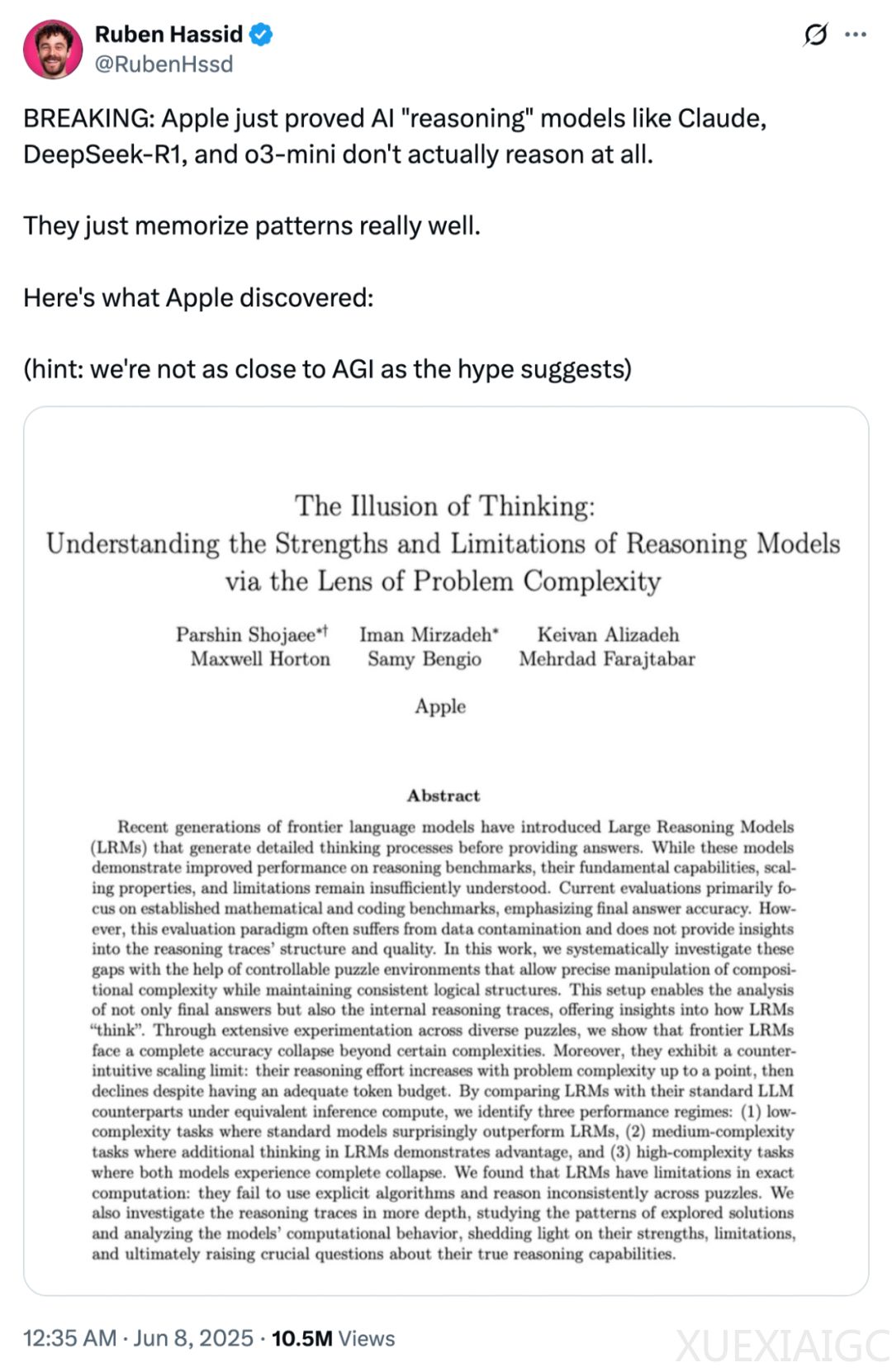

当前人工智能领域普遍认为以DeepSeek-R1、Claude 3.7 Sonnet为代表的推理大模型已具备类人思考能力,但苹果团队的最新研究对此提出根本性质疑。通过设计可控的算法谜题实验,研究发现这些模型仅擅长记忆模式而非真正推理,其性能在问题复杂度超过阈值时会完全崩溃。

研究采用汉诺塔、跳棋等四类可量化复杂度的谜题,系统测试了主流推理模型的极限。结果显示模型表现呈现三阶段特征:低复杂度时标准LLM效率更高;中等复杂度下思维链模型暂显优势;而当复杂度突破临界值,所有模型准确率均归零。更关键的是,当接近崩溃点时,模型会反直觉地减少推理计算量,即便仍有充足的计算资源未被利用。

对思维轨迹的分析揭示了更深刻的机制缺陷。简单问题中模型早期就能找到正确答案,却持续无效探索错误路径;中等难度下需遍历大量错误方案后才能偶然触及正解;而高复杂度任务则完全超出其能力范围。这种模式在提供明确算法指导时依然存在,说明模型无法有效执行既定计算步骤。不同谜题类型间表现的不一致性,进一步暴露其推理过程缺乏系统性。

研究同时发现评估方法的重大局限。传统数学基准可能因数据污染导致性能虚高,而谜题环境揭示出模型在组合深度、规划复杂度方面的真实短板。值得注意的是,部分争议指出实验设计存在缺陷——模型失败可能源于输出长度限制而非推理能力。例如汉诺塔13层以上时,模型因物理性无法输出全部步骤而放弃尝试,这提示需区分计算限制与认知局限。

这项研究对AI发展路径具有多重启示:现有推理模型的「思考」本质可能是对训练数据模式的复现,其自我修正机制存在根本性效率缺陷;评估体系需要从最终准确率转向对中间推理过程的细粒度分析;模型在组合泛化、算法执行等方面表现出意料之外的脆弱性。这些发现为理解当前AI系统的真实能力边界提供了重要标尺,也为突破现有范式指明了方向。

原文和模型

【原文链接】 阅读原文 [ 4405字 | 18分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★