文章摘要

【关 键 词】 AIGC技术、多模态模型、对比学习、HALVA模型、视觉-语言任务

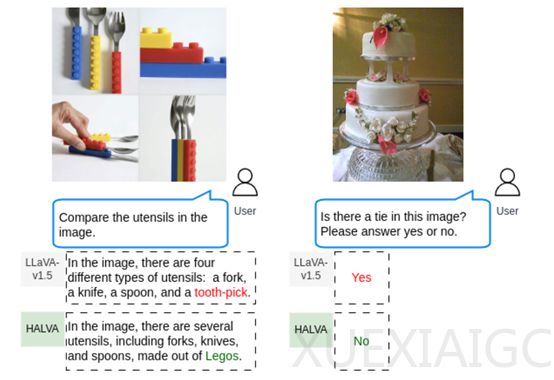

在人工智能生成内容(AIGC)领域,多模态大语言模型(LLM)的发展和应用落地受到广泛关注。然而,这些模型在生成和识别内容时容易出现错误描述,即“幻觉”现象。例如,模型可能会错误地将餐具图片描述为牙签。为了解决这一问题,谷歌DeepMind、谷歌云AI研究、向量研究所和皇后大学的研究人员开发了一种名为HALVA的模型。

HALVA的核心思想是通过对比学习提高模型对真实和幻觉对象的区分能力。该方法利用正确的对象描述和对应的幻觉描述来训练多模态模型,引导模型识别和生成与输入图像更加一致的描述。HALVA接收来自生成数据增强模块的输出,这些输出包括正确描述和幻觉化描述的对。这些成对的数据点是通过对原始图像进行智能的数据增强生成的,如替换图像中的对象集合。

HALVA将视觉-语言输入对送入预训练的多模态模型中,计算输出序列的概率分布,生成两组概率:一组对应于正确的描述,另一组对应幻觉错误的描述。HALVA定义了一个对比损失函数,基于正确描述和幻觉化描述的相对概率。损失函数的目标是最大化正确描述的概率,同时最小化幻觉化描述的概率。通过反向传播和梯度下降,模块优化损失函数,调整模型参数以减少幻觉描述的生成。

为了保证模型在调整过程中不会偏离其原始的预训练状态,对比调整模块引入了KL散度作为正则化项。这一步骤确保了模型在减轻幻觉化问题的同时,保持了其在一般视觉-语言任务上的性能。整个对比调整过程是端到端的,从输入的视觉-语言对到输出的损失函数,整个过程是连贯的,允许模型在训练过程中学习如何更好地区分真实和幻觉对象。

HALVA的训练数据基于VG提供了丰富的视觉信息和语言描述,包含108K张图像及其详细注释的对象中心图像数据集。正确数据描述是Gemini Vision Pro通过VG数据集生成。幻觉描述则通过VG的封闭和开放两个数据集生成,封闭集基于VG数据集中对象的已知共现关系,而开放集则通过直接提示大语言模型来生成与原始对象共现的新对象。

研究人员在CHAIR、MME-Hall、AMBER和MMHal-Bench等平台中对HALVA进行了综合评估。结果显示,HALVA在减少模型幻觉方面非常出色,同时在一般视觉-语言任务上也表现出了良好的性能。例如,在AMBER数据集上,HALVA在幻觉率指标上明显优于基础模型LLaVA-v1.5;在MMHal-Bench测试中,HALVA比基于RLHF、SFT或DPO的方法更有效地缓解了模型的幻觉问题。

总之,HALVA模型通过对比学习和数据增强的方法,有效地提高了多模态大语言模型对真实和幻觉对象的区分能力,减少了幻觉现象的发生,同时保持了模型在一般视觉-语言任务上的性能。这一研究成果为AIGC领域的进一步发展提供了有价值的参考和启示。

原文和模型

【原文链接】 阅读原文 [ 1013字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆