文章摘要

【关 键 词】 视频加速、RLT技术、Transformer、NeurIPS论文、DeepMind评价

卡内基梅隆大学提出了一种名为Run-Length Tokenization(RLT)的视频大模型加速方法,该方法通过合并视频中连续相同的图像块为一个token,显著提升了Transformer模型在视频处理上的速度。RLT在保持精度几乎不损失的同时,能够使模型训练和推理速度双双提升,具体来说,训练时间可缩短30%,推理阶段提速率提升可达67%。对于高帧率和长视频,RLT的效果更加明显,30fps视频的训练速度可提升1倍,长视频训练token减少80%。

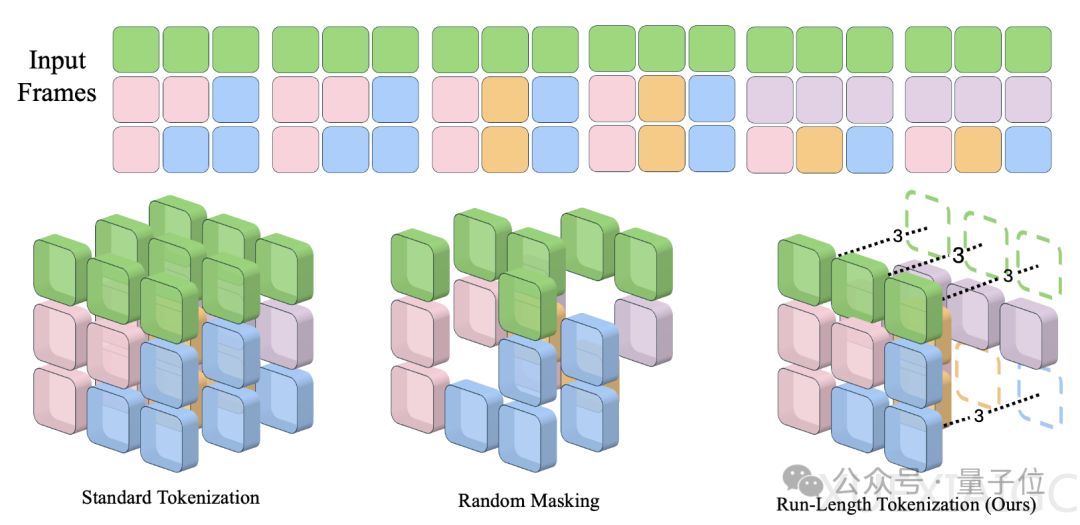

RLT的核心原理是利用视频中存在大量时间上重复的图像块这一特点,将重复的图像块合并为一个token表示,同时用一个位置编码来表示这个token的长度。视频在空间和时间维度上会被划分成固定大小的图像块,然后比较时间上相邻的图像块,判断它们是否相似,从而决定是否合并。重复的图像块会被移除,只保留第一个块对应的token,并给每个token加上长度编码,以反映完整的视频信息。

RLT在训练阶段对不同规模的模型都有很好的加速效果,且精度损失不超过0.1个百分点。在推理阶段,RLT也能在几乎不牺牲精度的情况下,将计算量和延迟降低30-60%。对于更大的模型,RLT也能实现45%的加速效果。特别地,RLT在高帧率和长时长视频数据集上带来的token下降幅度更高,且帧率越高效果越明显。

这项研究被NeurIPS 2024选为Spotlight论文,DeepMind科学家Sander Dieleman评价称,这项研究是一种“非主流”的创新方法,但比起其他复杂的非主流研究,又显得非常简洁。论文和代码已公开。

原文和模型

【原文链接】 阅读原文 [ 1375字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆