视频、图像、文本,只需基于下一个Token预测:智源Emu3发布,验证多模态模型新范式

文章摘要

【关 键 词】 多模态、AI模型、视觉tokenizer、自回归、开源技术

智源研究院于2024年10月21日发布了原生多模态世界模型Emu3,这是一个基于下一个token预测的模型,能够在无需扩散模型或组合方法的情况下,完成文本、图像、视频三种模态数据的理解和生成。Emu3在图像生成、视频生成、视觉语言理解等任务中超过了SDXL、LLaVA、OpenSora等知名开源模型,且无需依赖扩散模型、CLIP视觉编码器或预训练的LLM等技术。

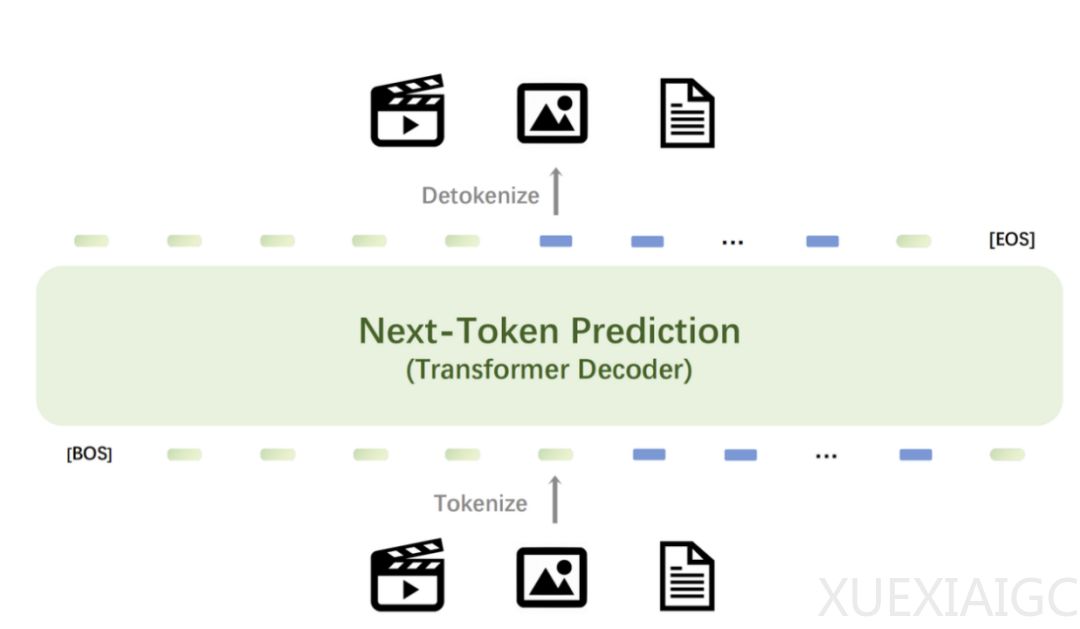

Emu3提供了一个强大的视觉tokenizer,能够将视频和图像转换为离散token,这些token可以与文本tokenizer输出的离散token一起送入模型中。模型输出的离散token可以被转换为文本、图像和视频,为Any-to-Any的任务提供了统一的研究范式。Emu3的下一个token预测框架的灵活性使得直接偏好优化(DPO)可以无缝应用于自回归视觉生成,使模型与人类偏好保持一致。

Emu3的研究结果证明了下一个token预测可以作为多模态模型的一个强大范式,实现超越语言本身的大规模多模态学习,并在多模态任务中实现先进的性能。通过将复杂的多模态设计收敛到token本身,Emu3能在大规模训练和推理中释放巨大的潜力,为构建多模态AGI提供了一条前景广阔的道路。目前,Emu3已开源了关键技术和模型。

Emu3的发布在社交媒体和技术社区引起了热议,被认为是几个月以来最重要的研究,非常接近拥有一个处理所有数据模态的单一架构。Emu3的方法有机会将多模态合并为一,只需将它们都视为token即可。Emu3的统一方法将带来更高效、更多功能的AI系统,简化多模态AI的开发和应用以及内容生成、分析和理解的新可能性。Emu3改写了多模态人工智能的规则,重新定义了多模态AI,展示了简单可以战胜复杂,使多模态AI的未来变得更加精炼与强大。

原文和模型

【原文链接】 阅读原文 [ 4375字 | 18分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆