文章摘要

【关 键 词】 人工智能、MoE模型、开源策略、大模型、技术优化

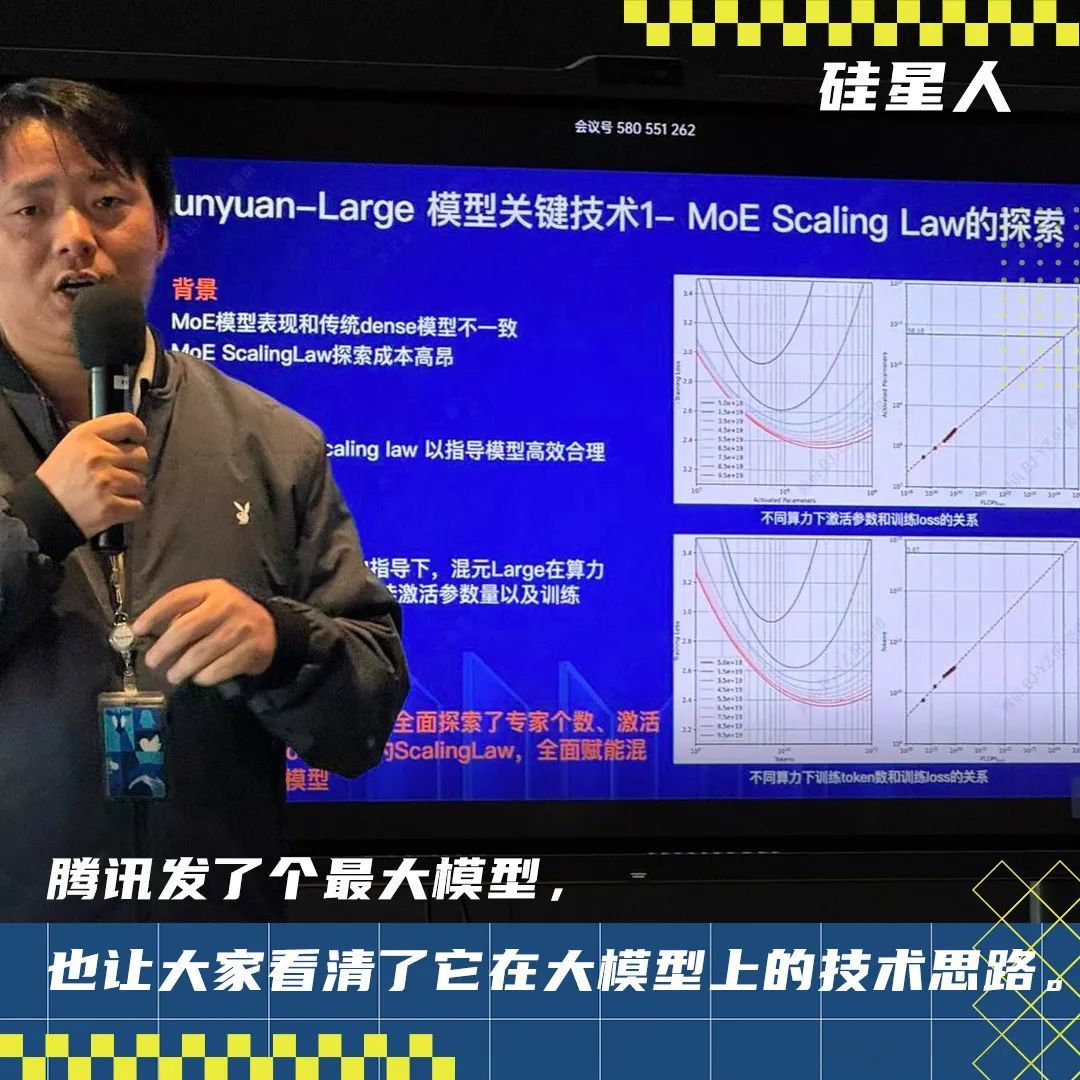

腾讯在人工智能领域的核心信念集中在开源和混合专家模型(MoE)上。公司通过开源一系列模型,包括混元文生图模型等,以追赶大模型领域的发展,并吸引社区参与者共同建设。腾讯对MoE的信仰体现在其广告业务和推荐功能中大规模使用AI算法,特别是在2024年11月5日开源的Hunyuan-Large模型,这是迄今为止全行业公开发布的参数量最大的MoE模型,拥有389B的总参数量和52B的激活参数量,上下文长度达到256K。该模型在多个领域取得领先成绩,并已在腾讯业务场景中得到应用。

MoE架构与稠密模型不同,它放弃了构建一个全能模型,而是采用多个专家组分工合作解决问题。腾讯在MoE架构的实验中寻找Scaling Law,通过大量实验找到最佳的专家平衡配方,并在合成数据、长上下文处理能力、推理加速等方面进行了技术优化。腾讯还提供了配套的vLLM-backend推理框架和支持huggingface格式,以支持模型精调,并基于腾讯Angel机器学习平台进行训练和推理,计划开源更多大模型工程框架。

腾讯的技术路线选择显示了其对MoE架构的坚持,即使在Llama路线占据主流的情况下。公司通过开源和生态建设吸引开发者,展示了其在大模型技术发展上的内部理念和方向。腾讯的开源策略不仅是模型本身,还包括了全套服务,以壮大MoE的朋友圈。康战辉表示,腾讯不急于开源,而是在内部业务打磨好后再开源,且必须是与公司自己使用的模型同宗同源的。腾讯还开源了混元3D生成大模型,这是业界首个同时支持文字、图像生成3D的开源大模型,并计划继续基于MoE架构发布更多模型。

原文和模型

【原文链接】 阅读原文 [ 2804字 | 12分钟 ]

【原文作者】 硅星人Pro

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆