腾讯大模型落地实操:模型推理引擎 TACO-LLM 的实践、腾讯乐享的 AI 功能探索

文章摘要

【关 键 词】 AI技术、大模型、知识管理、智能应用、优化效率

腾讯在AI领域的大模型应用已经取得了显著的进展,尤其是在推理成本优化和知识管理平台的改造上。本文总结了腾讯在大模型落地方面的探索与实践,主要涉及两个方面:一是大模型推理加速引擎TACO-LLM的设计与实践,二是腾讯乐享基于AI大模型的应用与实践。

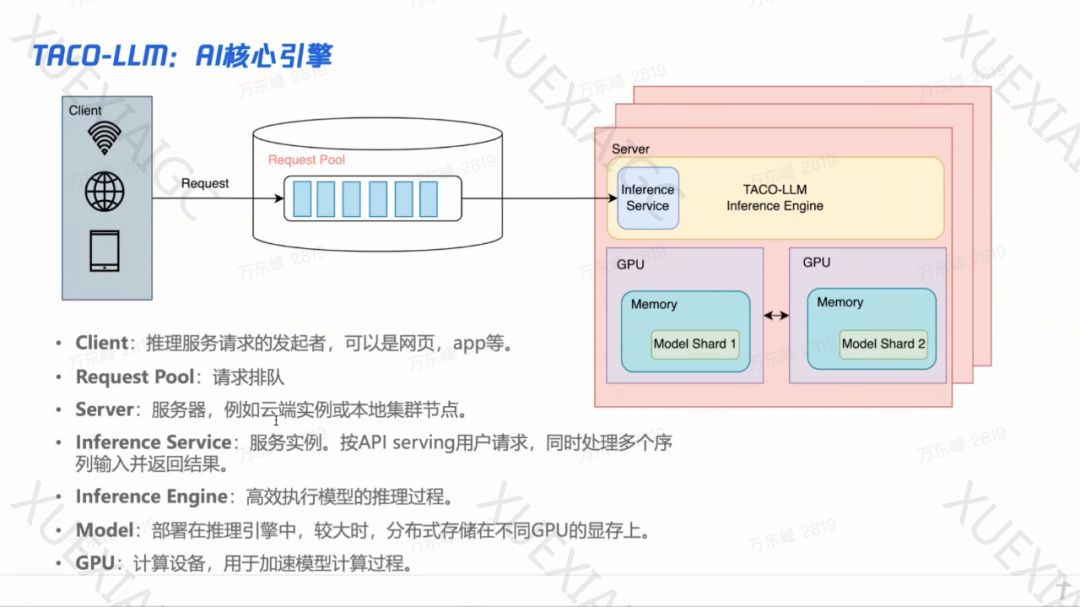

首先,TACO-LLM是腾讯云推出的一款大语言模型推理加速引擎,旨在提高语言模型的推理效能。它支持OpenAI的API输出格式,无缝支持流式请求,具有一致性、实时性和减少资源占用等优点。此外,TACO-LLM还支持分布式推理方案,如流水线并行和张量并行,以及连续批处理和Paged Attention技术。这些技术有助于提高GPU的使用效率和减少内存浪费。TACO-LLM还采用了模型量化技术,将模型的权重从32位浮点数转换为8位整数,从而减少存储需求和提高计算速度。通过这些优化策略,TACO-LLM在各种大小的模型上都表现出色,全面优于vLLM框架和NVIDIA TensorRT-LLM。

其次,腾讯乐享是一个内部孵化并使用了十余年的知识管理、学习培训和文化构建平台。近年来,乐享开始利用AI对知识管理进行深度改造,提高了知识的曝光、使用和迭代效率。AI的加成使得企业知识管理变得更加高效和热门。乐享主要围绕智能写作、智能生成、智能问答和智能学习四个环节进行AI场景落地探索。例如,在智能写作方面,AI可以帮助员工降低创作门槛,高效完成内容的修缮和规范;在智能生成方面,AI可以根据文本内容出题、生成知识点和考题等;在智能问答方面,AI可以快速搭建企业问答专家,提高内容曝光;在智能学习方面,AI可以实现AI陪练和打分,提高员工的学习效果。

在Workshop交流环节中,腾讯的专家讨论了大模型落地的难点和挑战。他们认为,大模型在知识管理和商业化方面的应用前景十分广阔,但同时也面临着人力物力投入和技术难题。例如,在智能客服领域,大模型结合向量数据库的技术可以显著提升客户服务的质量和精确度;在数据服务提供商领域,基于开源模型的微调可以提供更加精准的数据检索服务。此外,还有一些细分应用场景,如内容生成、人力资源管理和会议总结等,可以直接利用大型语言模型的API来实现特定功能,节省成本并加快产品的实际应用转化速度。

总之,腾讯在大模型落地方面的探索与实践表明,AI技术在提高业务效率、优化资源利用和推动知识管理发展方面具有巨大潜力。通过不断优化算力和推理性能,以及深入挖掘AI在各个领域的应用价值,腾讯有望在未来的AI领域取得更多突破。

原文和模型

【原文链接】 阅读原文 [ 6294字 | 26分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★