算法不重要,AI的下一个范式突破,「解锁」新数据源才是关键

文章摘要

人工智能在过去十五年里取得了显著进展,尤其是在深度神经网络、Transformer语言模型、基于人类反馈的强化学习(RLHF)和推理模型等领域。这些突破并非源于全新的算法创新,而是得益于新数据源的利用和更高效的数据处理方式。康奈尔大学博士生Jack Morris指出,未来的范式转变可能依赖于视频数据(如YouTube)和实体世界数据(如机器人)。这些数据源不仅数量庞大,而且包含丰富的信息,可能为人工智能的进一步发展提供关键支持。

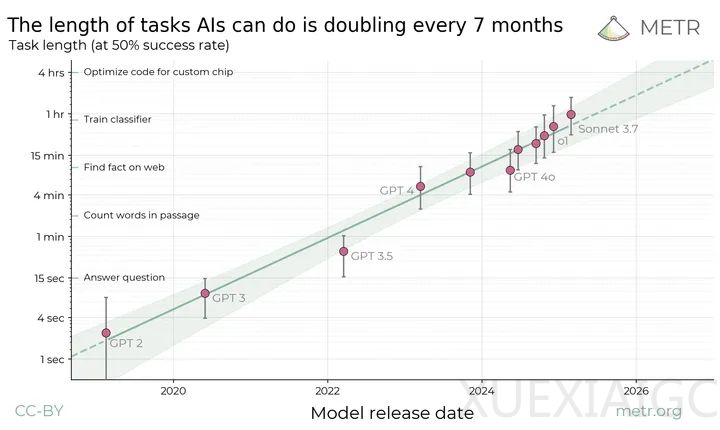

近年来,人工智能的进步呈现出指数级增长的趋势,被称为“人工智能的摩尔定律”。尽管这一说法存在争议,但人工智能在智能性、速度和成本效益方面的提升是显而易见的。学术界和工业界的持续研究推动了这一趋势,尤其是在降低模型成本和提高效率方面。例如,FlashAttention、推测解码、Muon优化器和DeepSeek-R1等技术的出现,展示了去中心化全球化科学研究的成果。

然而,尽管研究取得了显著进展,一些人认为人工智能的进步正在放缓。最新的模型如Grok 3和GPT-4.5仅在前代基础上实现了微小改进,某些任务(如数学奥林匹克考试)的表现仍然有限。这表明,尽管模型能力有所提升,但其实际应用效果可能被夸大。

回顾人工智能的“四大发明”——深度神经网络、Transformer语言模型、RLHF和推理模型,可以发现这些突破的基础机制早在1990年代甚至更早就已存在。这些突破的关键在于从新的数据源中学习,如ImageNet、互联网文本、人类反馈和验证器。每一次突破都标志着新数据源的大规模使用,并引发了后续的研究热潮。

未来,人工智能的下一个范式转变可能不会来自新的算法或神经网络架构,而是源于对新数据源的解锁和利用。视频数据和机器人数据被认为是潜在的突破点。YouTube每分钟上传的视频量远超互联网上的文本量,而机器人数据则可能提供关于物理世界的丰富信息。这些数据源的使用将需要更高效的模型和更强大的计算能力。

总之,人工智能的进步不仅依赖于技术创新,更在于对新数据源的探索和利用。未来的突破可能更多地来自于数据的扩展和优化,而非全新的算法发明。这一趋势提醒我们,在追求人工智能发展的过程中,应更加注重数据的多样性和质量。

原文和模型

【原文链接】 阅读原文 [ 2907字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★