文章摘要

【关 键 词】 多模态、视频理解、基准测试、人工智能、隐私伦理

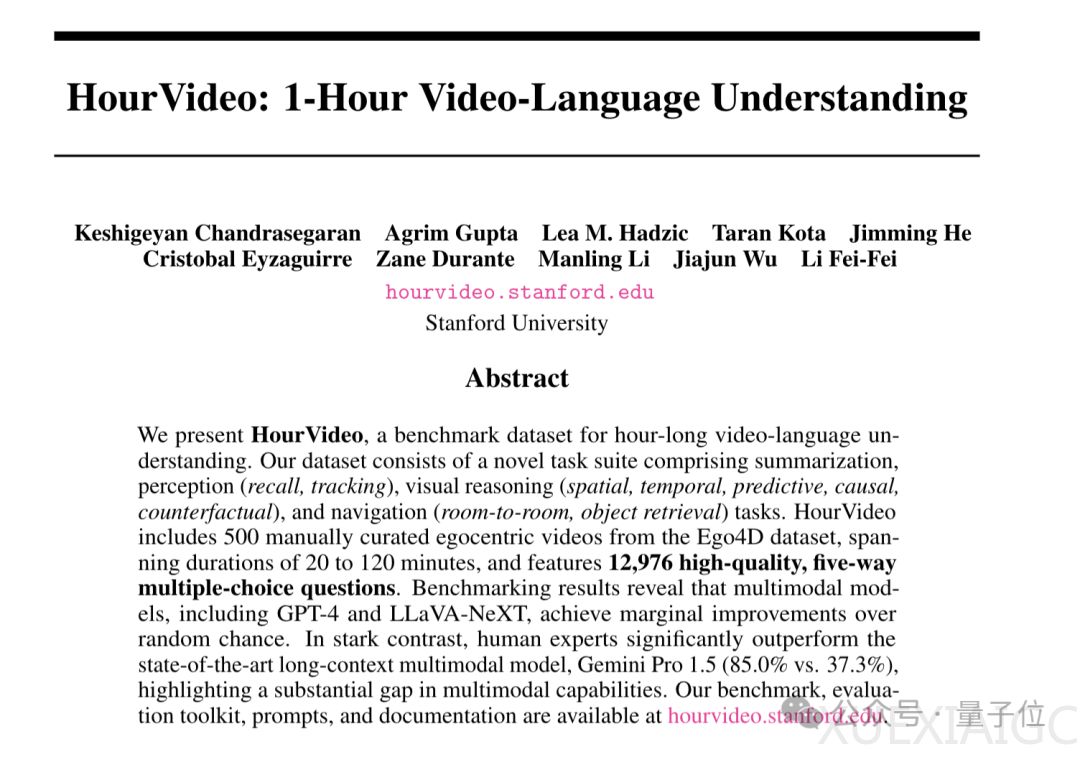

斯坦福大学李飞飞和吴佳俊团队推出了HourVideo,一个旨在评估多模态模型对长达一小时视频理解能力的基准数据集。HourVideo包含500个来自Ego4D数据集的第一人称视角视频,时长在20到120分钟之间,覆盖77种日常活动。该数据集通过对比现有模型与人类专家的表现,揭示了当前模型在长视频理解上与人类水平的差距。人类专家在评估中的准确率达到了85.0%,而最好的模型准确率为37.3%,远低于人类水平。

HourVideo的设计包括一个新的任务对应套件,涵盖总结、感知、视觉推理和导航任务,共18个子任务。这些任务要求模型对视频中的多个时间片段进行信息识别和综合,有效测试模型的长期理解能力。数据集的生成涉及视频筛选、候选MCQ生成、LLM优化与人工反馈、盲选和专家优化等步骤。HourVideo最终包含500个视频,视频时长共381个小时,每个视频有约26个高质量五选一题,共计12976个问题。

实验评估采用五选多任务问答(MCQ)任务,以准确率作为评估指标。研究团队比较了盲LLM、苏格拉底模型和原生多模态模型在零镜头设置下理解长视频的性能。结果显示,盲LLM的准确率为19.6%,苏格拉底模型准确率略高,原生多模态模型准确率最高,达到了37.3%。此外,团队还计划扩展基准测试,包括更多样化的视频来源,纳入音频模态支持,并探索其他感官模态。同时强调在开发模型时需考虑隐私、伦理等问题。HourVideo项目由斯坦福李飞飞和吴佳俊团队共同完成,论文共同一作是Keshigeyan Chandrasegaran和Agrim Gupta。

原文和模型

【原文链接】 阅读原文 [ 3029字 | 13分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆