文章摘要

【关 键 词】 空间智能、3D生成、视觉条件、数据集、多视角

斯坦福大学教授李飞飞团队WorldLabs推出了首个空间智能模型,能够通过单张图片生成逼真的3D世界,标志着空间智能领域的重要进展。与此同时,国内智源研究院发布了首个基于大规模无标注互联网视频学习的3D生成模型See3D,该模型支持从文本、单视图和稀疏视图到3D的生成,并可进行3D编辑与高斯渲染。

See3D采用视觉条件技术,依赖视频中的视觉线索生成多视角图像,不依赖昂贵的3D或相机标注,能从互联网视频中高效学习3D先验。模型支持零样本和开放世界的3D生成,无需微调即可执行3D编辑、表面重建等任务,具有广泛的3D创作应用潜力。相关模型、代码、Demo均已开源。

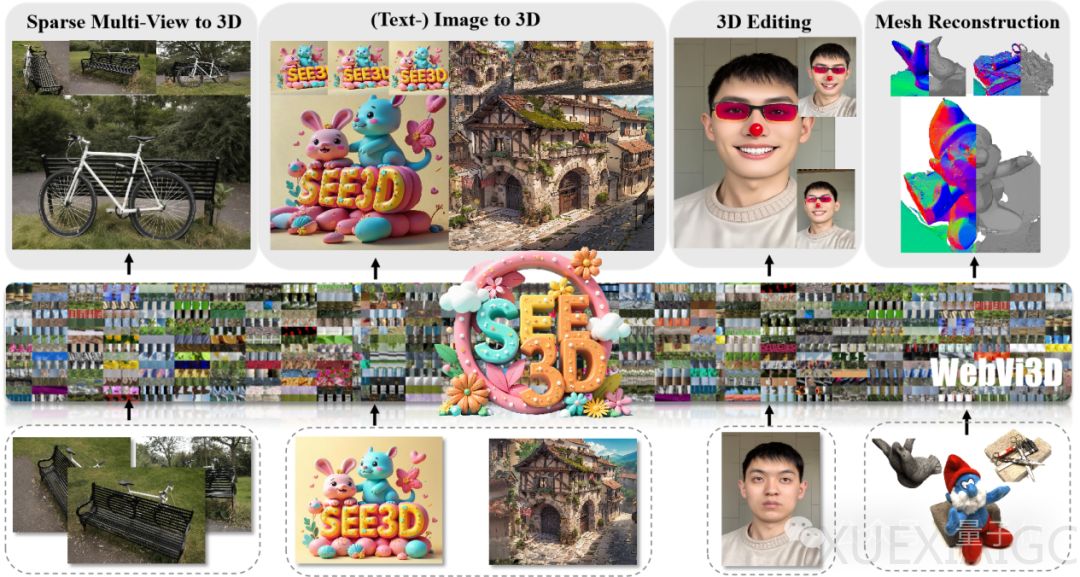

See3D的效果展示包括解锁3D互动世界、基于稀疏图片的3D重建、开放世界3D生成和基于单视图的3D生成。研究动机在于3D数据的积累规模有限,采集过程耗时且成本高昂,而视频来源广泛且易于获取,具备揭示3D结构的潜力。

See3D提供了一套系统化的解决方案,包括数据集、模型和3D生成框架。团队构建了高质量、多样化的大规模多视角图像数据集WebVi3D,涵盖1600万个视频片段的3.2亿帧图像。See3D引入新的视觉条件,通过向掩码视频数据添加时间依赖噪声,生成2D归纳视觉信号,支持可扩展的多视图扩散模型训练,实现”仅通过视觉获得3D”的目标。

See3D的优势在于数据扩展性、相机可控性和几何一致性。模型训练数据源自海量互联网视频,构建的多视图数据集在规模上实现数量级提升。模型支持任意复杂相机轨迹下的场景生成,提供灵活多样的视角操控能力。模型支持长序列新视角的生成,保持前后帧视图的几何一致性,并遵循真实三维几何的物理规则。

通过扩大数据集规模,See3D为突破3D生成的技术瓶颈提供了新思路,所学习到的3D先验为一系列3D创作应用提供支持。希望这项工作能引发3D研究社区对大规模无相机标注数据的关注,避免高昂的3D数据采集成本,缩小与现有强大闭源3D解决方案之间的差距。

原文和模型

【原文链接】 阅读原文 [ 1609字 | 7分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆