清华姚班本科生连发两作,十年来最大改进:矩阵乘法接近理论最优

模型信息

【模型公司】 OpenAI

【模型名称】 gpt-4-0125-preview

【摘要评分】 ★★★★★

文章摘要

【关 键 词】 矩阵乘法、算法改进、计算机科学、理论突破、效率提升

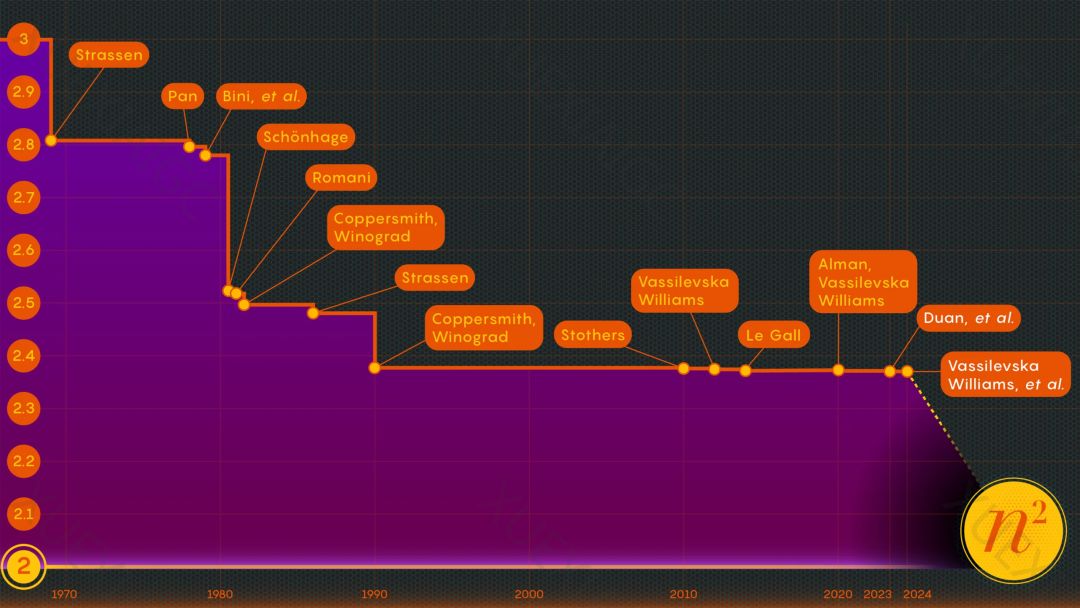

通过消除「隐藏的低效」问题,计算机科学家提出了一种比以往更快的大型矩阵相乘新方法。这一进展是在矩阵乘法领域中的重要突破,矩阵乘法不仅是高性能计算中的关键问题,也是AI等应用的基石。近日,《量子杂志》报道了两篇论文,展示了矩阵乘法速度的进一步提升,其中一位清华大学大四本科生全程参与了这两篇论文的撰写,为算法改进带来了新希望。

矩阵乘法的改进是计算机科学家长期以来的追求,尽管这个过程本身相对简单,但为了提高效率,科学家们进行了长时间的努力。最近,清华大学的段然、周任飞和加州大学伯克利分校的Hongxun Wu在这个领域取得了重要进展,他们的论文被计算机科学领域的顶会FOCS 2023接收,展示了如何进一步增强矩阵乘法的效率。

矩阵乘法的改进关键在于减少乘法步骤的数量,尽可能将指数从n³降低。1986年,Strassen提出的激光法是加速矩阵乘法过程的重要步骤之一。然而,段然、周任飞和Hongxun Wu的研究揭示了以前未知且未开发的潜在改进来源,他们发现了所谓的「隐藏损失」,并通过减少这种损失,大大提高了矩阵乘法的效率。

他们的研究将ω的新上限设定在了2.371866左右,这是自2010年以来科学家们看到的最大进步。这一成果不仅展示了矩阵乘法速度的进一步提升,也揭示了一种新的改进途径。随着这些研究的进展,我们可以期待在矩阵乘法以及相关领域中取得更多的突破。

原文信息

【原文链接】 阅读原文

【阅读预估】 3024 / 13分钟

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...