文章摘要

【关 键 词】 动作生成、音频驱动、虚拟角色、数据集、模型优化

研究人员联合开发了EMAGE模型,这是一种能够根据音频自动生成全身动作、面部表情和手势的创新工具。其主要功能是生成连贯且逼真的共语手势视频,适用于数字人等应用场景。通过该模型,用户只需上传音频文件(如歌曲或旁白),便可生成具有丰富动作细节的视频内容,极大地提升了虚拟角色的动作自然度与表现力。

为支持这一模型的训练与优化,研究人员发布了目前规模最大的“共语手势”数据集BEAT2。这一数据集整合了SMPLX人体模型和FLAME面部模型,将原始动作捕捉与面部数据转化为高质量的三维网格序列,总时长超过60小时。其丰富的数据资源为模型训练提供了坚实基础。

EMAGE通过遮罩手势重建特征增强人体提示编码能力,并结合音频特征生成一致的面部、手部和身体动作。相较于TalkShow、DisCo等类似模型,EMAGE在节奏一致性、动作多样性和面部顶点差异等方面表现出色。测试结果表明,在人工评估中,超过半数用户认为EMAGE生成的手势视频更加连贯且生动。

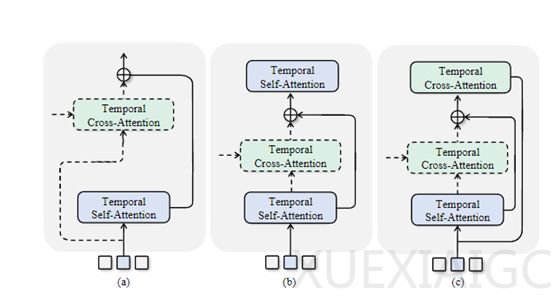

该模型采用内容节奏自注意力技术(CRA),将音频节拍与语音文本的语义信息分别编码为节奏和内容特征,再通过自适应融合方法生成与语义和节奏相匹配的身体姿势。这种设计使得模型能够根据具体帧需求关注不同的音频特性,从而实现更自然的动作生成效果。

此外,EMAGE利用四个独立的VQ-VAE编码器分别对面部、上半身、手部和下半身进行建模,较单一整体模型更能捕捉细致的动作特征。掩蔽音频姿势转换模块则进一步增强了模型的能力,它通过掩蔽姿势重建与音频条件姿势生成两部分,捕捉身体不规律运动特征并与音频结合,最终生成高质量的动作序列。对于面部表情生成,EMAGE直接拼接身体线索与音频特征,生成更为精准的面部表现。

总体而言,EMAGE及其相关技术推动了音频驱动动作生成领域的发展,为虚拟角色、动画制作等应用提供了重要支持。

原文和模型

【原文链接】 阅读原文 [ 1070字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 qwen-max-2025-01-25

【摘要评分】 ★★☆☆☆