清华、上海AI Lab等顶级团队发布推理模型RL超全综述,探索通往超级智能之路

文章摘要

【关 键 词】 强化学习、大推理模、推理应用、研究挑战、模型进展

强化学习(RL)在人工智能发展中一直是重要方法,自1998年概念提出后,在多个领域取得显著成果。进入大模型时代,RL最初用于让模型更符合人类偏好,近年来研究者希望通过它让模型真正学会“推理”。

RL在大推理模型中的应用潜力巨大。大推理模型(LRM)通过可验证的奖励提升推理能力,如OpenAI的o1和DeepSeek – R1展示了模型经RL训练后,在规划、反思和自我纠正方面的能力提升,意味着推理能力可通过“扩展”增强。但要实现RL在大推理模型中的大规模应用,面临奖励设计、算法效率、数据和算力支撑等挑战。

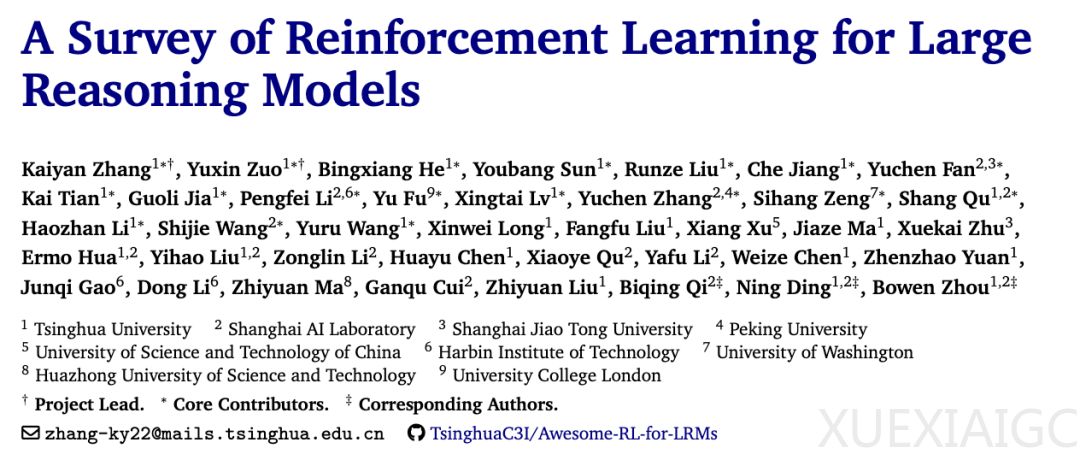

来自清华大学和上海人工智能实验室等的研究者组织并总结了推理模型的最新RL研究。RL在推动大语言模型(LLM)能力边界上成果显著,尤其在数学、编程等复杂逻辑任务中表现突出,已成为将LLM演化为LRM的核心方法。随着领域发展,扩展RL在LRM上的应用面临算力资源、算法设计、训练数据与基础设施建设等基础性挑战。

该综述重点梳理了相关进展。展示了大模型发展时间线,推理模型的重要里程碑o1和DeepSeek – R1揭示了新的扩展路径;呈现了语言模型中RL方法从RLHF到DPO再到RLVR以及未来开放式RL系统的演变,将推理重新定位为可显式训练和扩展的能力,提供了与预训练互补的能力增长路径,还能克服数据限制。

然而,面向LRMs的RL扩展也带来新挑战。不仅涉及计算资源,还包括算法设计、训练数据和基础设施等方面。综述工作涵盖引入RL建模基本定义、回顾核心组成部分、讨论基础性与争议性问题、总结训练资源、综述应用场景以及探讨未来研究方向。

强化学习在大推理模型上的应用是人工智能发展的重要转折,虽面临挑战,但近年进展已证明其潜力,未来基于RL的推理能力有望持续提升,带来深远影响。

原文和模型

【原文链接】 阅读原文 [ 2202字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 doubao-1-5-pro-32k-250115

【摘要评分】 ★★★★★