海底数据中心,AI时代的能耗最优解?丨ToB产业观察

文章摘要

【关 键 词】 生成式AI、数据中心、海底数据、算力平台、能源消耗

生成式AI的发展重构业务流程与数字化模式,也对底层算力基础设施提出更高要求。预计到2027年,AI数据中心容量和能源消耗的复合年增长率分别达40.5%和44.7%。“AI的尽头是能源”成为业内共识,2024年全球数据中心耗电415太瓦时,占全球总用电量1.5%,国际能源署预测到2030年将飙升至945太瓦时。AI服务器功率提升击穿风冷系统散热极限,颠覆了IDC产业。

在此背景下,数据中心供冷系统和整体架构迎来变革。一方面要提升能源利用率,另一方面要利用好闲时算力。数据中心技术演进朝着两个方向推进:一是降低内部设备功耗,采用液冷、间接蒸发冷却技术和高压直流供配电;二是在建设选址和设计上寻找碳中和与AI需求的“双赢”解。

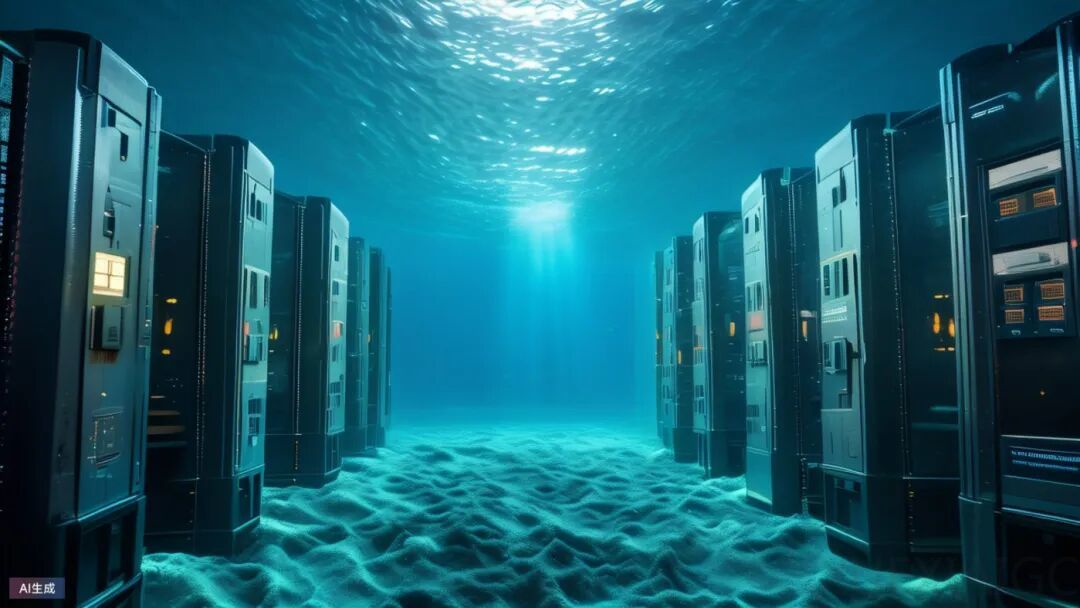

海底数据中心是一种有效的解决方案。微软早在2015年就开始相关探索,海兰信于2023年在海南陵水下水一期首舱。海底数据中心具有低能耗、高可靠性和模块化部署优势,能降低制冷能耗、提升电能利用率、降低故障率、延长服务器寿命,TCO较陆地低15 – 20%。

不过,海底数据中心也存在运维难度大的弊端。海兰云推出2.0项目,采用潜入式方案,预留运维人员出入管道,并结合海上风电供电,进一步降低PUE。

在算力应用与算网建设层面,算力调度运营平台成为提升算力利用率的关键。企业自建算力基础设施存在投入大、利用率低等弊端,催生了算力服务商和算力调度运营平台。海底数据中心与算力平台的结合将重构数据中心行业,未来算力产业有望形成“海底节点 + 陆地集群 + 边缘终端”的协同体,成为应对AI多元化需求的最优解。

原文和模型

【原文链接】 阅读原文 [ 2882字 | 12分钟 ]

【原文作者】 钛媒体AGI

【摘要模型】 doubao-1-5-pro-32k-250115

【摘要评分】 ★★★★★