模型参数作知识通用载体,MergeNet离真正的异构知识迁移更进一步

文章摘要

【关 键 词】 知识迁移、边缘计算、深度学习、性能提升、异构模型

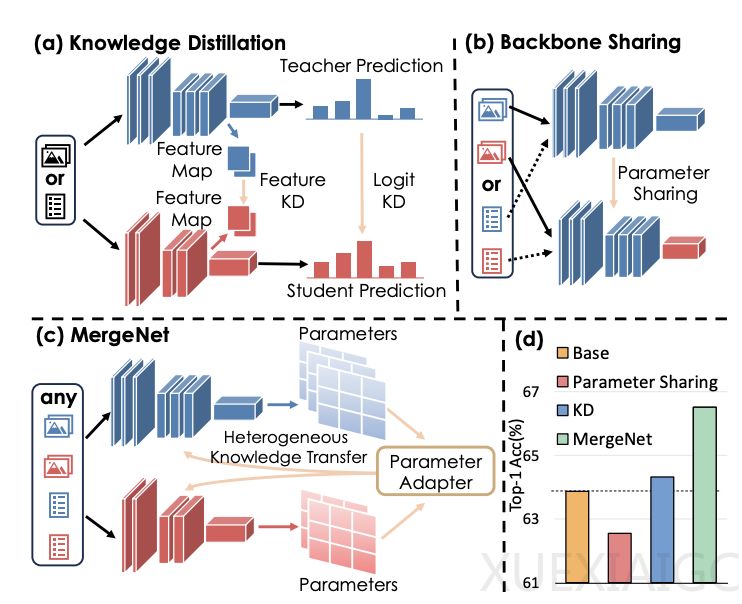

浙江大学和上海交通大学的研究团队提出了一种名为MergeNet的知识迁移框架,旨在解决边缘计算设备如智能物联网设备在部署深度神经网络时面临的计算资源和存储容量限制问题。该框架能够跨越模型架构、任务类型和数据模态的差异,实现异构知识迁移。

MergeNet框架的核心在于将模型参数作为知识的通用载体,通过低秩矩阵对异构知识进行统一表示,消除了模型架构上的差异。研究团队引入了参数适配器,学习弥合异构模型参数空间的差距,促进知识的直接交互和融合。此外,MergeNet采用了自学习和互学习的策略,即在知识迁移过程中穿插自学习,类似于在教师指导下的自我巩固阶段,使得模型在吸收外来知识的同时,也能够巩固和优化自身的知识结构。

实验结果表明,MergeNet在跨结构、跨模态和跨任务知识迁移这几个具有挑战性的场景中均取得了显著的性能提升。例如,在CIFAR-100数据集上,MergeNet在ResNet50和MobileNetV2之间进行知识迁移时,MobileNetV2的Top-1准确率提升了1.02%。在VQA v2.0视觉问答任务和MSCOCO图像-文本检索任务上,MergeNet显著提升了准确率。在IMDb情感分类和SQuAD v2.0问答任务上,MergeNet也实现了性能提升。

消融实验进一步验证了MergeNet中各组件的有效性。研究表明,在训练过程中加入自学习可以提升性能。例如,当Tcycle设置为4时,MobileNetV2的性能达到了66.51%,比没有自学习时的60.09%提高了6.42%。与MLP-based参数适配器相比,MergeNet的性能分别提高了1.82%和1.31%。

总的来说,MergeNet作为一种灵活、通用的知识迁移框架,能够应对多变的需求和挑战,为边缘计算设备部署深度神经网络提供了一种有效的解决方案。

原文和模型

【原文链接】 阅读原文 [ 2723字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★