李飞飞亲自撰文,数十名科学家签署联名信,反对加州AI限制法案

文章摘要

【关 键 词】 AI监管、SB-1047法案、开源社区、科技创新、风险评估

在硅谷,AI科学家李飞飞、吴恩达等人与监管部门就SB-1047法案展开激烈辩论。该法案旨在为高风险AI模型建立安全标准,防止滥用和灾难性后果。法案于2月提出,但许多科学家认为其条款过于严格,可能对科技创新造成毁灭性影响。

SB-1047法案主要针对特定计算和成本阈值以上的AI模型进行监管。具体包括:1) 使用超过10^26次整数或浮点运算、成本超过1亿美元的模型;2) 利用等于或大于10^25次整数或浮点运算三倍的计算能力微调的模型。这些标准基本覆盖了市面上所有主流大型模型。

法案要求模型开发者承担下游使用或修改的法律责任,在训练前证明模型不会提供危险功能,并实施保护措施。这将阻碍开源社区发展。新成立的”前沿模型部门”将负责监督执行,制定安全标准并提供法律建议。法案还加入了吹哨人保护条款。

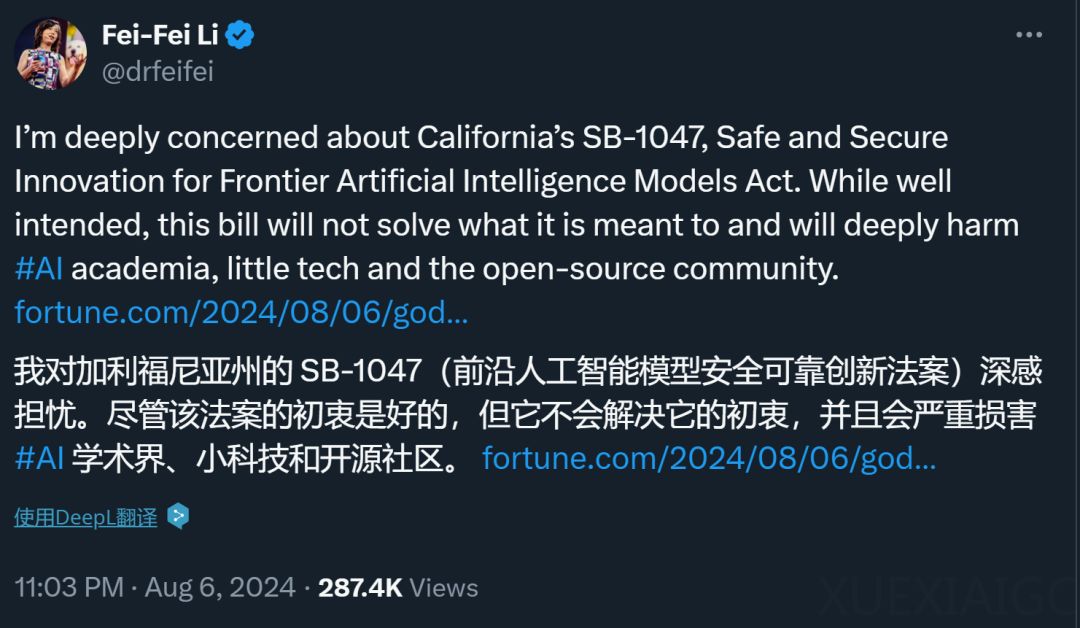

李飞飞在《财富》撰文批评SB-1047,认为其将产生重大后果,损害AI生态系统,不必要地惩罚开发者,扼杀开源社区,阻碍学术研究,且无法解决真正问题。她指出:

1. SB-1047将过度惩罚开发者,扼杀创新。要求责任方和原始开发者承担滥用责任,迫使开发人员退步。

2. SB-1047将束缚开源开发,要求模型包含”终止开关”,摧毁开源社区。

3. SB-1047将削弱公共部门和学术研究。开源开发对学术界至关重要,缺乏模型数据将阻碍进步。

4. 法案未解决AI潜在危害,如偏见和深度伪造,而是设置武断阈值。

数十位科学家联名反对SB-1047,认为其不合理,包括:

1. 法案给开源模型发布带来”寒蝉效应”,损害研究。

2. 人工智能风险预测与”能力”评估存在不科学性。

3. 对开源模型保护不足,现有措施难以持续。

4. 担忧对学生就业和职业成果的影响。

吴恩达认为,监管应关注应用而非技术,如电动机。关注特定应用可更合理评估风险,确保安全。

AI是否已危险到需如此监管?各方观点不一,但无疑SB-1047法案将对AI领域产生深远影响,值得持续关注。

原文和模型

【原文链接】 阅读原文 [ 2958字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★