新扩散模型OmniGen一统图像生成,架构还高度简化、易用

文章摘要

【关 键 词】 图像生成、多模态、知识迁移、Transformer、开源数据集

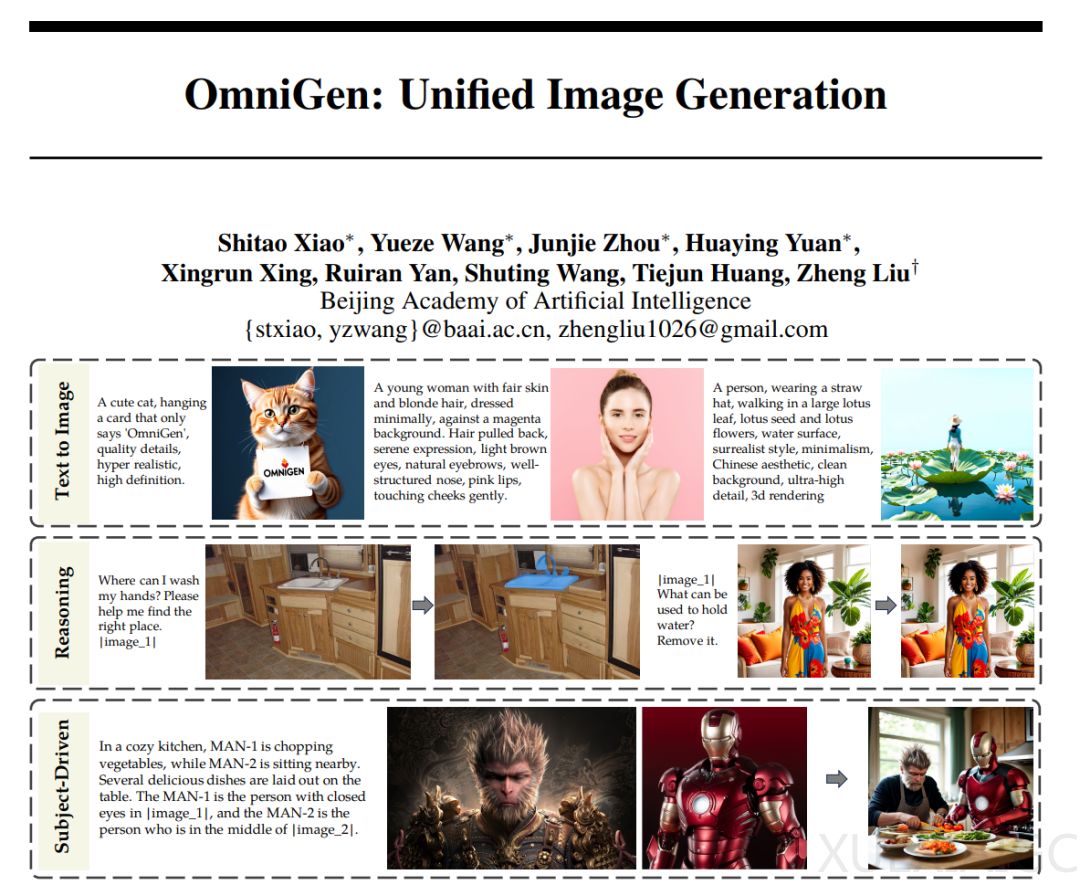

智源近日推出了OmniGen,这是一种新的扩散模型架构,旨在统一图像生成的多模态模型。OmniGen以其统一性、简单性和知识迁移能力为特点,支持多种图像生成任务,包括文生图、图像编辑、主题驱动生成和视觉条件生成等,同时能够处理经典计算机视觉任务。其架构简化,用户友好,无需额外模块即可完成复杂任务,简化了工作流程。

OmniGen集成了多项能力,如文本到图像生成、指代表达生成、通用图像条件生成、图像编辑以及经典计算机视觉任务等。它还展示了一定的上下文学习能力和潜在的推理能力。例如,OmniGen能够根据文本指令从多人图像中定位目标对象并生成新图像,无需额外模块和操作。此外,它还能够处理非显式查询指令,如删除图中能装水的物品。

OmniGen的核心设计原则是简洁和有效,基本架构包括一个Transformer模型和一个VAE模块,共3.8B参数。为了训练模型,智源构建了首个大规模且多样化的统一图像生成数据集X2I,包含约1亿图像,未来将开源。

OmniGen的统一图像生成范式有助于执行各种下游任务,并组合各种能力满足更通用的需求。智源将继续改进模型基本能力,拓展更多有趣的功能,并鼓励社区参与对OmniGen潜在能力的发掘、基本性能的提升和广泛应用的探索。模型的报告、权重和代码等已开源,用户可以自行探索更多OmniGen的能力。

原文和模型

【原文链接】 阅读原文 [ 2316字 | 10分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...