文章摘要

【关 键 词】 视觉多模态、AI Agent、图像识别、视频理解、动态分辨率

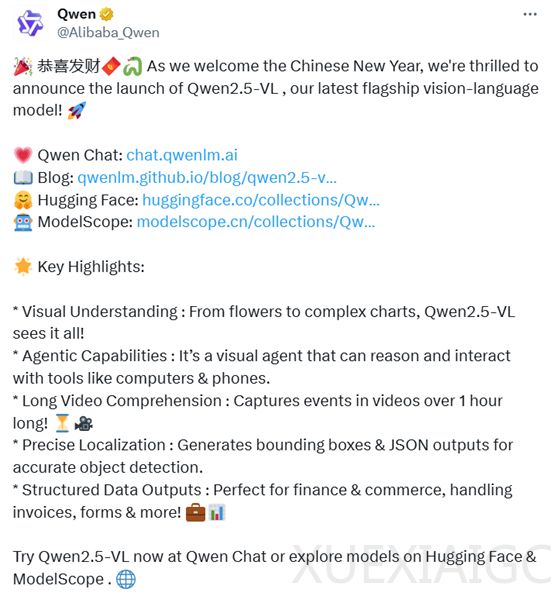

阿里巴巴最新发布了视觉多模态模型Qwen2.5-VL,该模型在图像、文本、视频的理解与识别能力上显著增强,并且具备直接作为视觉Agent自动化操作电脑和手机的独特功能。例如,它能够根据用户提供的行程日期自动预订飞机票。Qwen2.5-VL还能理解超过1小时的长视频,并精确定位特定时间点的事件,这在安防领域尤其有用,可以快速定位关键事件的视频片段,节省审阅时间。

Qwen2.5-VL的开源地址已在Hugging Face和GitHub上公布,同时提供了在线体验平台。网友对此表示赞赏,认为中国的大模型表现出色。在OpenAI发布Operator后,AI Agent成为全球关注的焦点,预计2025年将是智能体大年。阿里将AI Agent作为Qwen2.5-VL的主打功能之一,支持视觉识别,对手机和电脑端操作至关重要。在大模型的理解、推理能力支持下,Qwen2.5-VL在准确率和执行效率方面有显著提升。

Qwen2.5-VL增强了通用图像识别能力,扩大了可识别图像类别量级,包括植物、动物、地标、影视作品IP和商品。它采用矩形框和点的多样化方式对通用物体进行定位,实现层级化定位和JSON格式输出,为复杂场景中的视觉Agent理解和推理任务提供强大基础。此外,Qwen2.5-VL通过动态帧率训练和绝对时间编码技术,提升了视频理解能力,能定位秒级事件,并在长视频中搜索具体事件、总结不同时段要点,帮助用户快速提取关键信息。

与Qwen2-VL相比,Qwen2.5-VL增强了对时间和空间尺度的感知能力,并简化了网络结构以提高模型效率。在空间维度上,Qwen2.5-VL能够动态地将不同尺寸的图像转换为不同长度的token,并直接使用图像的实际尺寸表示检测框和点等坐标,不进行传统的坐标归一化。在时间维度上,引入了动态FPS训练和绝对时间编码,将mRoPE id与时间流速对齐。视觉编码器在多模态大模型中扮演着重要角色,Qwen2.5-VL从头开始训练了一个原生动态分辨率的ViT,包括CLIP、视觉-语言模型对齐和端到端训练等阶段。为了解决多模态大模型在训练和测试阶段ViT负载不均衡的问题,引入了窗口注意力机制,有效减少了ViT端的计算负担。在ViT设置中,只有四层是全注意力层,其余层使用窗口注意力,最大窗口大小为8×8,小于8×8的区域不需要填充,而是保持原始尺度,确保模型保持原生分辨率。此外,为了简化整体网络结构,使ViT架构与LLMs更加一致,采用了RMSNorm和SwiGLU结构。

原文和模型

【原文链接】 阅读原文 [ 1207字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆