数据不够致Scaling Law撞墙?CMU和DeepMind新方法可让VLM自己生成记忆

文章摘要

【关 键 词】 AI发展、数据利用、机器学习、视觉语言、智能优化

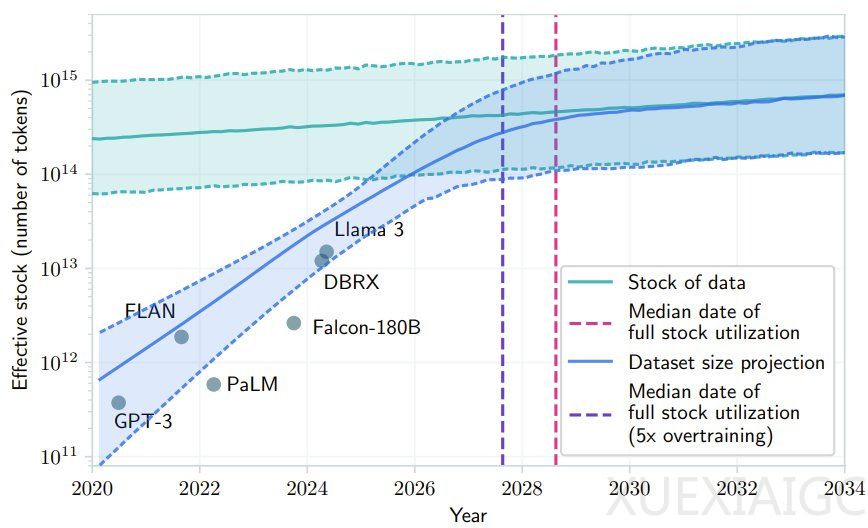

近期AI社区热议的Scaling Law是否撞墙问题中,一个论点是AI即将耗尽现有高质量数据。对此,卡内基梅隆大学和Google DeepMind的研究发现,利用低质量数据和反馈可能解决高质量数据不足的问题。他们提出的ICAL方法允许大型语言模型(LLM)和视觉-语言模型(VLM)根据次优演示和人工反馈创建有效提示词,改善决策,减少对专家演示的依赖。ICAL通过学习上下文经验抽象,使VLM能够解决新任务,这一方法在NeurIPS 2024上获得Spotlight论文荣誉,项目代码已公开。

ICAL的核心在于通过提示让VLM创建用于不熟悉领域的多模态抽象,涵盖任务和因果关系、对象状态变化、时间抽象和任务建构四种类型的认知抽象。ICAL处理次优演示时,通过提示将演示转换为优化后的轨迹,并在人类自然语言反馈引导下优化这些抽象。ICAL的迭代过程从有噪声的轨迹开始,分为抽象阶段和有人类参与的阶段,最终将成功执行的轨迹存档于范例库中,作为智能体的上下文参考。

实验表明,ICAL在TEACh、VisualWebArena和Ego4D基准测试中表现出色。在家庭环境的指令遵循任务中,ICAL优于固定演示。在TEACh验证集上,ICAL在新指令、房屋和物体上的性能优于未处理的演示。ICAL还修正了有噪声的轨迹,提高了训练任务的成功率。在视觉网络任务上,ICAL达到SOTA性能。在Ego4D设置中,ICAL的表现接近完全监督式方法,但使用的领域内训练数据大幅减少。

总体而言,ICAL显著减少了对专家示例的依赖,相比于缺乏此类抽象的动作规划和轨迹的上下文学习,始终表现更优。随着示例数量增长,ICAL也能获得明显提升,表明其良好的Scaling潜力。

原文和模型

【原文链接】 阅读原文 [ 2067字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆