揭示Transformer重要缺陷!北大提出傅里叶分析神经网络FAN,填补周期性特征建模缺陷

文章摘要

【关 键 词】 FAN网络、周期性建模、傅里叶级数、性能优越、技术进步

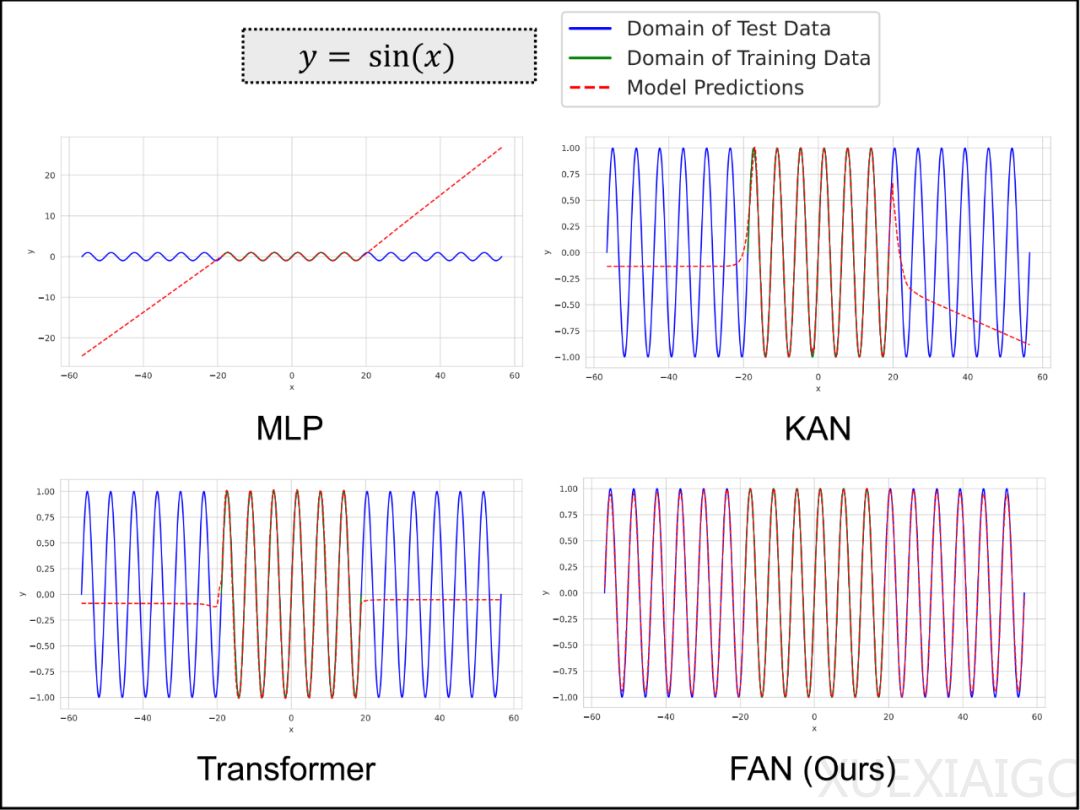

北京大学计算机学院长聘教授李戈领导的团队提出了一种新型网络架构FAN(Fourier Analysis Networks),旨在解决现有基础模型如MLP和Transformer在周期性建模方面的不足。FAN通过引入傅里叶级数的思想,将周期性信息直接嵌入网络结构中,使模型能够更自然地捕捉和理解数据中的周期性模式。实验表明,FAN在周期性建模、符号公式表示、时间序列预测和语言建模等任务中的表现均优于现有模型。

FAN的设计理念是将傅里叶级数展开嵌入神经网络,通过深度学习的优势构建深度神经网络。FAN层的设计遵循两个原则:1) FAN表示傅里叶系数的能力应与其深度正相关;2) 任何隐藏层的输出都可以通过后续层使用傅里叶级数来建模周期性。FAN的中间层输入需要同时使用傅里叶系数和角频率,而不是依次应用它们。

在周期性建模方面,FAN在训练数据域内外的测试数据上都表现出色,能够真正理解周期性的深刻原理并进行精准建模。在符号公式表示任务中,FAN拟合常见函数的性能始终优于其他基线模型。在时间序列预测任务中,结合FAN的Transformer在多个公共数据集上取得了最佳性能。在语言建模任务中,结合FAN的Transformer在情绪分析数据集上表现出优越的性能。

FAN在理论上具有与MLP相同的表达能力,但通过明确纳入周期性,引入了重要的功能增强。FAN可以作为MLP的有力替代品,在更广泛的应用中展现出强大的适用性。未来,北大研究团队将进一步扩大FAN的应用范围,增强其作为基础模型组件的表现,推动基础模型的技术进步与创新发展。

原文和模型

【原文链接】 阅读原文 [ 2723字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆