文章摘要

【关 键 词】 移动模型、数据隐私、算力挑战、技术突破、隐私保护

在移动设备上部署大型模型成为行业焦点,但受限于内存和算力的不足,这些模型相对较小,且消耗大量资源,限制了其应用场景。苹果公司在此领域的动作引发了关于数据隐私的广泛讨论,甚至引起了马斯克的关注。

为解决内存和算力的挑战,上海交通大学IPADS实验室推出了面向手机的大模型推理引擎PowerInfer-2.0,该引擎能在手机上实现Mixtral 47B模型的快速推理,速度达到11 tokens/s,相比热门开源推理框架llama.cpp,平均加速比达25倍,最高达29倍。

PowerInfer-2.0通过动态神经元缓存技术,利用模型推理时的稀疏激活特性,将神经元分为冷、热两种,并基于LRU策略在内存中维护神经元缓存池,显著降低内存使用量。此外,针对手机异构计算环境,PowerInfer-2.0提出以神经元簇为粒度的异构计算,根据处理器特性动态决定神经元簇大小,优化了计算效率。

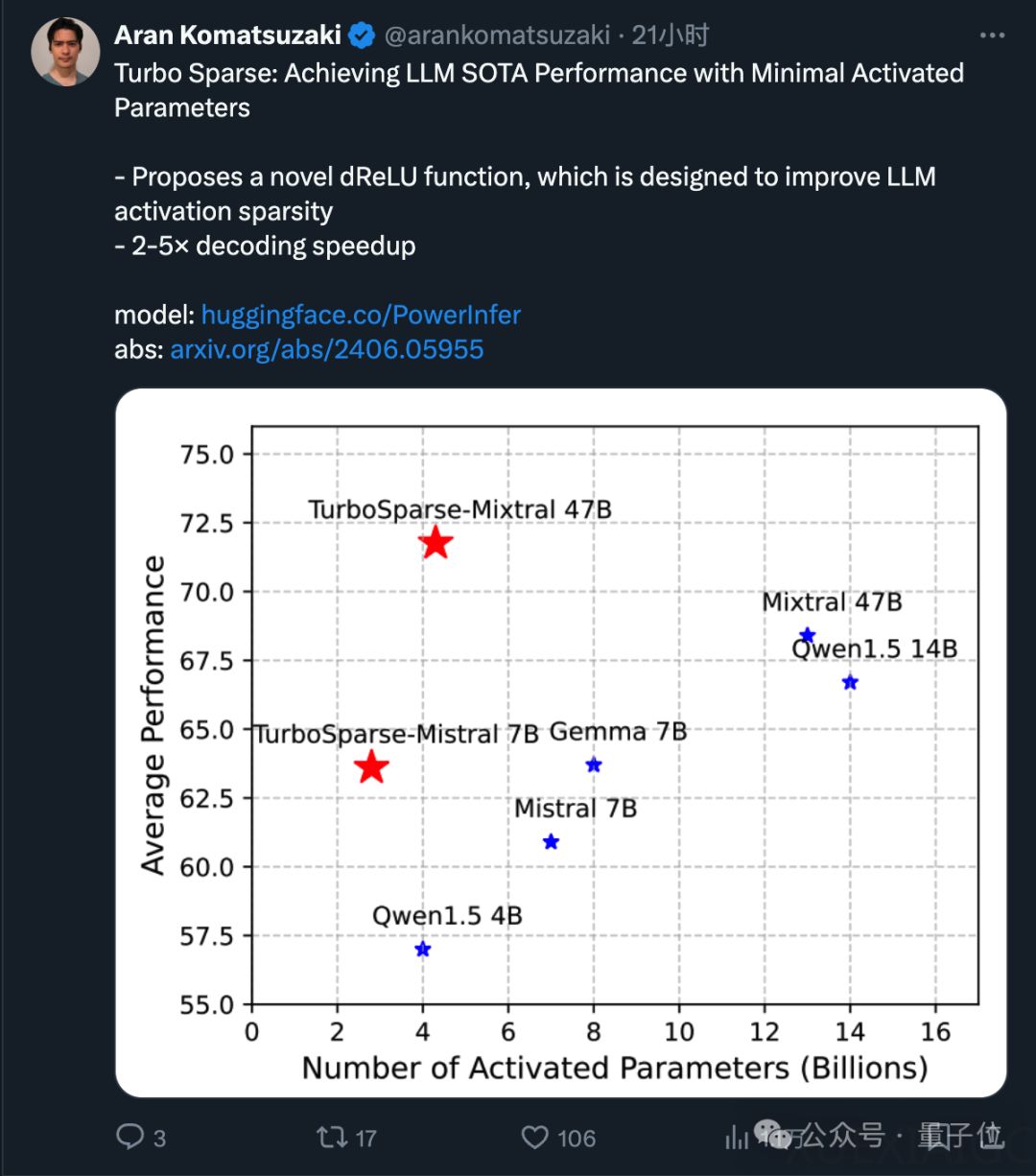

为提升模型稀疏性,上海交大团队还提出了低成本高质量的稀疏化方法,通过dReLU激活函数在保持模型能力的同时,大幅提升模型的稀疏度。这一系列技术突破,使得大型模型在手机上的应用成为可能,为移动设备带来更强大的AI智能同时,也为保护用户隐私提供了新的解决方案。

原文和模型

【原文链接】 阅读原文 [ 3701字 | 15分钟 ]

【原文作者】 量子位

【摘要模型】 glm-4

【摘要评分】 ★★★☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...