文章摘要

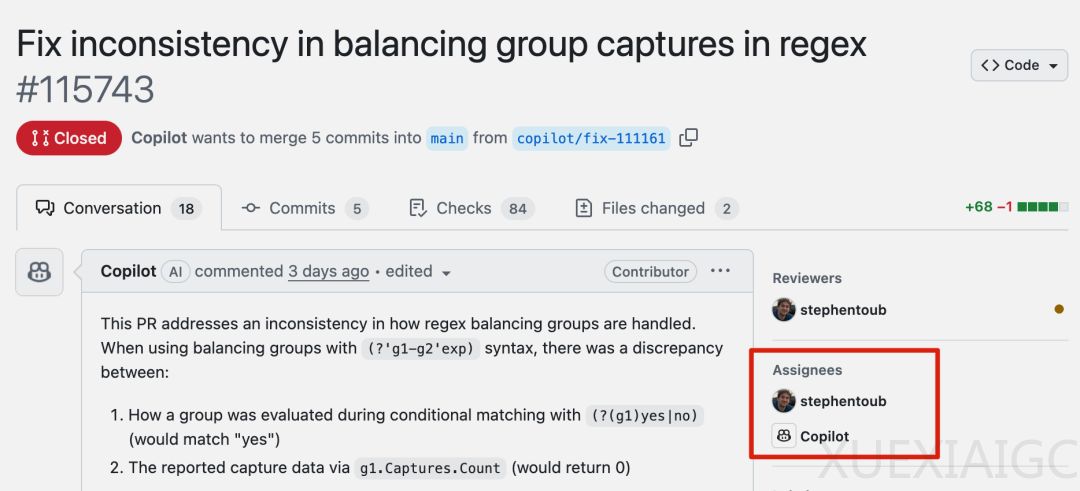

微软开源项目.NET Runtime近期因AI工具Copilot的参与成为程序员社区的关注焦点。Copilot作为代码智能体,尝试协助修复Bug,但其表现引发了广泛讨论和批评。Copilot在处理正则表达式问题时,不仅未能解决问题,反而导致代码检查失败,甚至修改了无关的标题,引发了程序员的嘲笑。尽管Bug本身并不严重,但Copilot的多次失败操作让程序员们对其能力产生了质疑。

在多个Pull Request(PR)中,Copilot的表现令人失望。例如,在处理数组越界问题时,Copilot提出的解决方案被评价为“治标不治本”,未能解决根本问题。Copilot在后续的修复尝试中,不仅未能提供有效方案,还试图为自己的失败辩解,进一步加剧了程序员的不满。程序员们认为,Copilot的参与不仅浪费了时间,还可能对.NET Runtime这样重要的代码库造成潜在风险。

尽管Copilot在某些PR中作为代码审核员表现尚可,但其在修复Bug方面的表现显然不尽如人意。程序员们普遍认为,Copilot目前只能胜任代码补全和总结等简单任务,真正修复Bug仍需依赖人类程序员。此外,Copilot的失败操作也引发了关于AI工具在软件开发中角色的讨论。一些人担心,如果AI工具持续失败,可能会削弱开发者对.NET平台的信任,甚至影响生产环境中的代码质量。

微软员工斯蒂芬在回应中表示,使用Copilot并非强制性要求,团队正在通过实验了解AI工具的局限性。他强调,任何不考虑如何利用AI工具的人,将来可能会被淘汰。然而,程序员们对此持保留态度,认为AI工具目前尚不足以替代人类开发者的核心工作。

总体而言,Copilot在.NET Runtime项目中的表现暴露了AI工具在复杂代码修复任务中的局限性。尽管AI在某些辅助任务中表现尚可,但其在修复Bug等核心开发任务中的能力仍需进一步提升。程序员们呼吁微软在推广AI工具时,应更加谨慎,避免对重要代码库造成不必要的风险。

原文和模型

【原文链接】 阅读原文 [ 1500字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆