文章摘要

【关 键 词】 Flow-DPO、数学推理、协同工作、在线学习、性能验证

加州大学和微软研究院的研究者们提出了一种名为Flow-DPO的新方法,旨在提升大型语言模型(LLM)在数学问题解答中的推理能力。该方法通过在线学习流(Flow)和直接偏好优化(DPO)技术,使得两个独立的LLM能够协同工作,互相纠正错误,生成更详细和精确的推理轨迹。这种方法不仅提高了LLM的数学推理能力,还有效避免了因人类标注数据不准确而导致的问题。

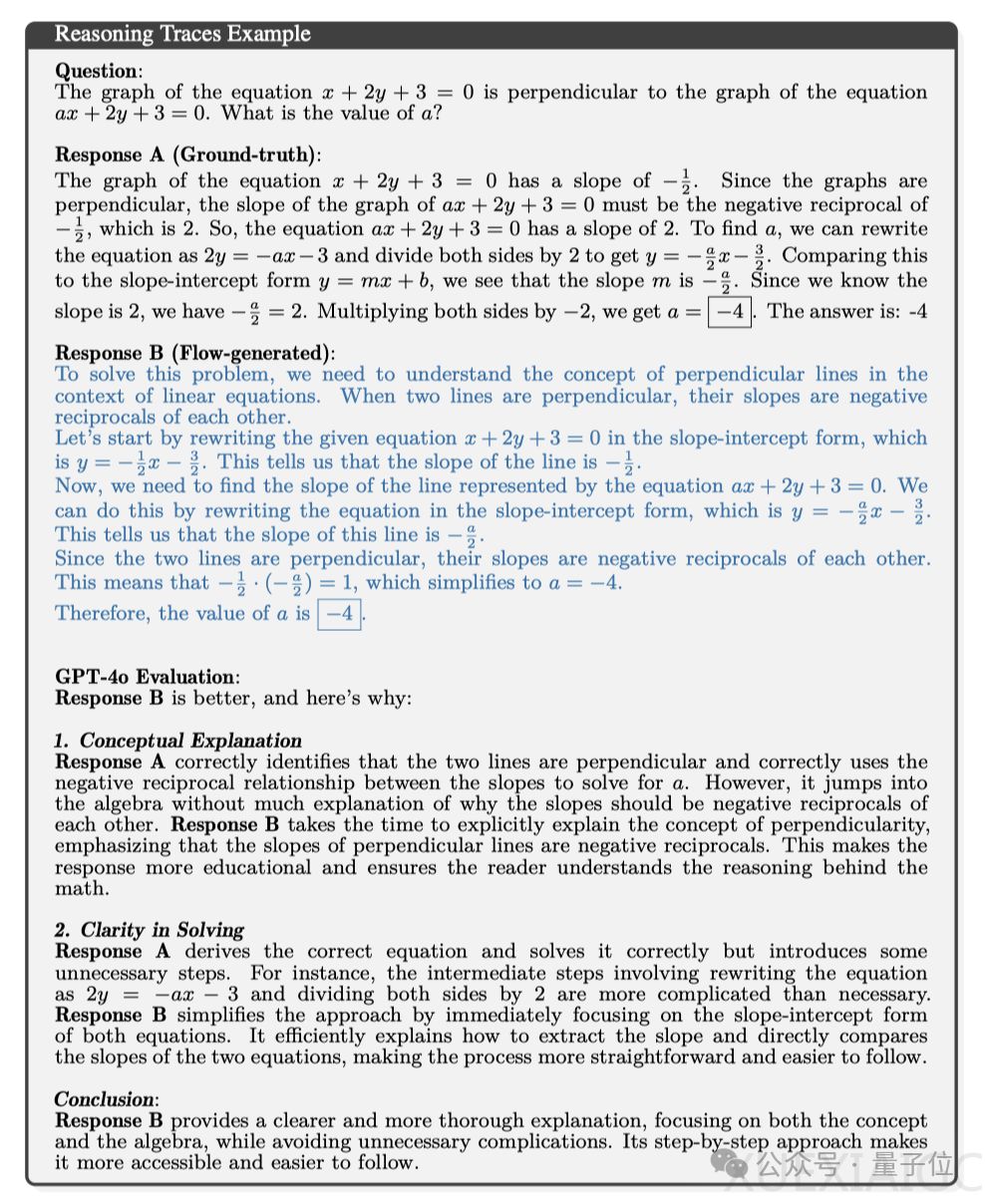

在实际例子中,Flow-DPO在解答数学问题时展现出了更清晰的解题思路和更透彻的概念解释,相较于传统方法,其回答更易于理解和掌握。该方法包括两个部分:增量输出生成Flow和在线Flow学习与回滚。增量输出生成Flow通过两个LLM的迭代通信构建解决方案,而在线Flow学习与回滚则通过随机展开和DPO对引导至正确答案。

为了验证Flow-DPO的性能,研究团队设计了精密的验证实验,使用了MetaMath数据集,并采用了不同规模的模型进行测试。结果显示,Flow-DPO显著提高了模型在数学推理上的能力。具体来说,Llama-3-8B-Instruct模型的准确率提高了20%,Phi-3-medium-128k-instruct模型的准确率达到了83%。此外,Flow生成的推理轨迹在质量上也优于基线和模型生成的正确推理轨迹,提高了微调准确率。

这项研究不仅展示了LLM在解决数学问题上的进步,也预示着未来LLM在解决更复杂问题上的潜力。

原文和模型

【原文链接】 阅读原文 [ 1814字 | 8分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...