强化学习成帮凶,对抗攻击LLM有了新方法

文章摘要

【关 键 词】 强化学习、对抗攻击、黑盒攻击、机器学习、模型安全

威斯康星大学麦迪逊分校的研究团队最近发现,强化学习可以被用于实施黑盒逃避攻击,即通过生成对抗样本来欺骗机器学习模型。这一发现揭示了强化学习在攻击AI模型方面的潜力,同时也引发了对模型安全性的担忧。研究团队提出了一种新的攻击方法,将对抗样本生成过程建模为马尔可夫决策过程(MDP),并通过强化学习智能体来学习如何生成有效的对抗样本。

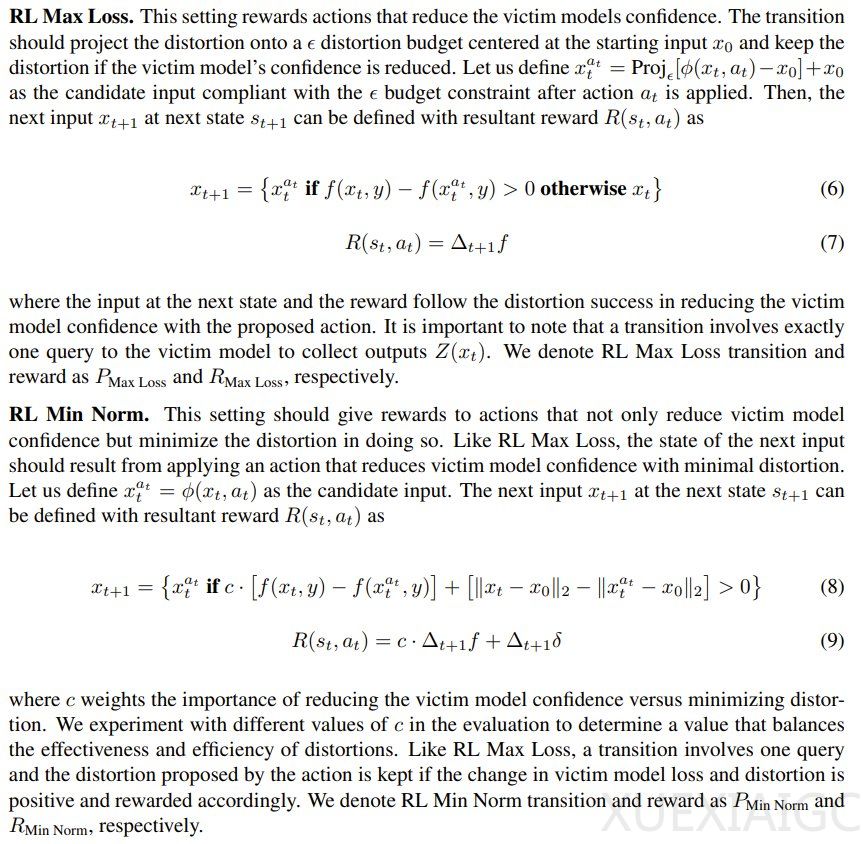

强化学习的引入为对抗攻击提供了一种新的途径。传统的对抗机器学习(AML)方法通常依赖于基于梯度的优化算法,这些方法无法利用先前攻击的经验来改进后续攻击。而强化学习智能体则可以通过学习哪些扰动最能欺骗模型,从而在不需要昂贵梯度优化的情况下生成对抗样本。研究团队提出了两种强化学习攻击方法:RL Max Loss和RL Min Norm,分别对应两类传统的AML算法。

在实验中,研究团队使用CIFAR-10图像分类任务和ResNet50模型来评估这些攻击方法的有效性。结果表明,强化学习智能体在训练过程中能够显著提高对抗样本的生成效率和有效性。具体来说,对抗样本的生成速度平均提升了19.4%,而与受害者模型的交互量平均减少了53.2%。此外,研究还发现,智能体的性能取决于ε和c参数的选择,这些参数分别控制着RL Max Loss和RL Min Norm的攻击策略。

研究团队还评估了训练后的智能体在未见过的数据上的表现,并将其与广泛使用的SquareAttack算法进行了比较。结果表明,强化学习攻击能够生成比现有方法多13.1%的对抗样本,显示出其在黑盒攻击中的优势。这一发现表明,如果对手通过强化学习方法学习对抗样本,他们可能会比现有方法更有效地攻击机器学习模型。

这项研究不仅揭示了强化学习在对抗攻击中的潜力,也为模型防御提供了新的挑战。未来的研究需要进一步探索如何防御这种新型攻击,以确保机器学习模型的安全性。

原文和模型

【原文链接】 阅读原文 [ 1658字 | 7分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆