文章摘要

【关 键 词】 人工智能、AI芯片、成本效益、技术创新、市场挑战

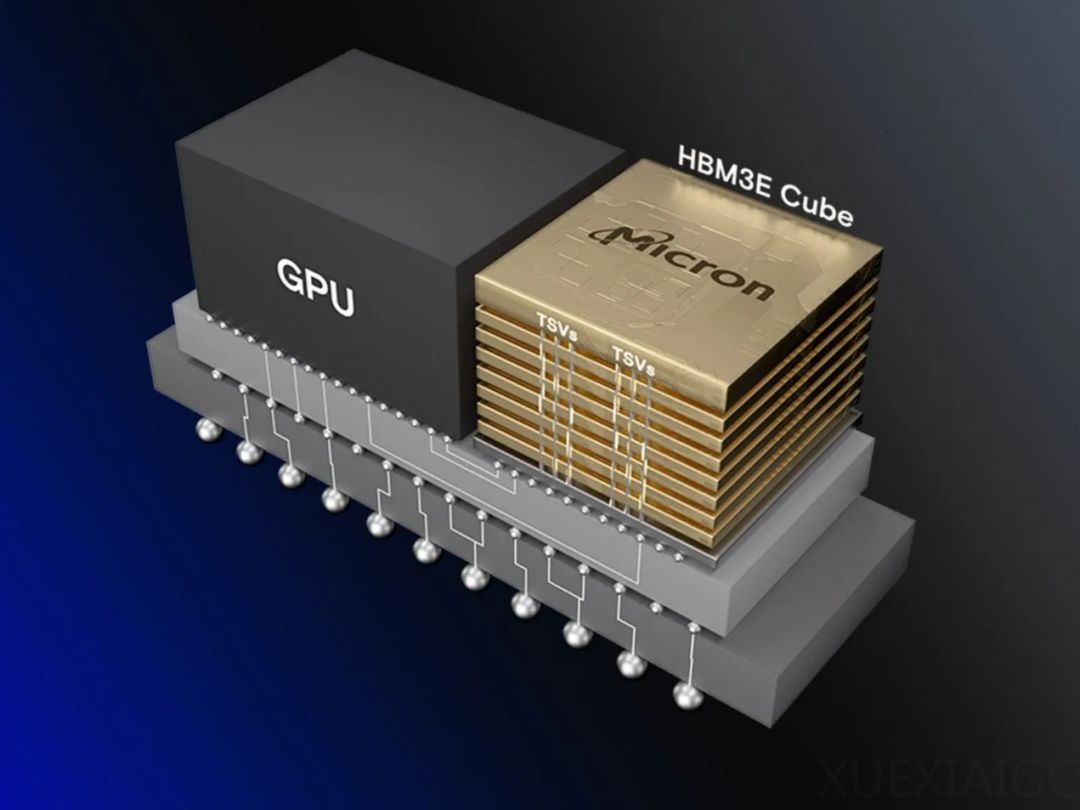

随着人工智能(AI)大模型训练需求的增长,对算力和高带宽存储器(HBM)的需求也在增加。GPU提供算力,而HBM提供带宽,成为AI发展的关键。然而,HBM价格昂贵,对AI服务器成本构成重大影响,占比约9%,且供不应求,价格持续上涨。尽管如此,市场对HBM的需求预计在2024年将增长近200%,2025年有望翻番。

面对HBM的高成本问题,一些企业和专家正在寻求解决方案。例如,被誉为“硅仙人”的吉姆·凯勒(Jim Keller)在加入AI芯片初创公司Tenstorrent后,致力于开发成本效益高的AI芯片。Tenstorrent的第二代多功能AI芯片在能效和处理效率上优于英伟达的AI GPU,且成本降低了33%。凯勒的技术决策是不使用HBM,而是通过特别设计的芯片减少数据传输,降低能耗和成本。

Tenstorrent的产品Grayskull和Wormhole芯片使用标准DRAM代替昂贵的HBM,大幅降低成本。Grayskull芯片在稀疏张量运算方面进行了优化,而Wormhole处理器则提供灵活的可扩展性,满足不同工作负载的需求。此外,Tenstorrent还提供高性能RISC-V CPU和Tensix核心的授权,并与合作伙伴共同开发Chiplets。

除了Tenstorrent,其他公司也在探索替代HBM的方案。Groq公司开发的新一代LPU采用SRAM代替HBM,提高了推理速度并降低了成本。NEO Semiconductor提出了带有附加神经元电路的三维DRAM,通过避免从高带宽内存到GPU的数据传输,加速AI处理。

尽管HBM在AI大模型中扮演着关键角色,但面对成本优势的替代方案不断涌现,HBM的地位可能面临挑战。如果HBM不能通过其他方式降低成本,其未来市场地位可能会受到影响。随着更多创新解决方案的出现,AI硬件市场有望变得更加多样化和竞争激烈。

原文和模型

【原文链接】 阅读原文 [ 4364字 | 18分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆