文章摘要

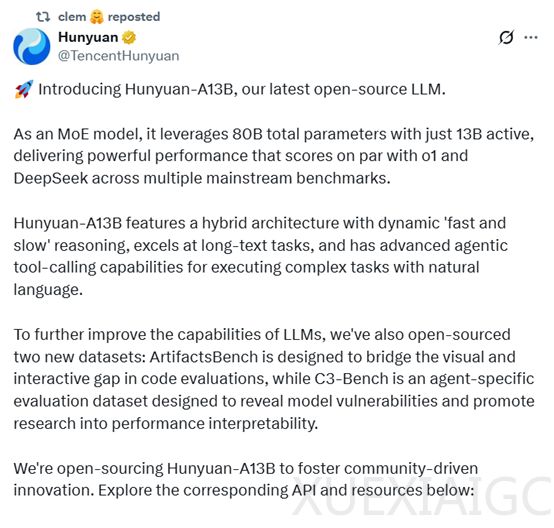

腾讯最新开源的混元大模型Hunyuan-A13B,是一个拥有800亿参数的专家混合模型,其中130亿参数处于激活状态。该模型支持快速和慢速两种思考模式,分别适用于简单任务和复杂任务。快速思维模式提供简洁高效的输出,适合日常任务;慢速思维模式则支持更深层次的推理,提升复杂任务的准确性。Hunyuan-A13B特别针对AI Agent进行了强化,设计了超过30种智能体指令,并创造出20000种格式组合,以应对不同场景变化。

在性能测试中,Hunyuan-A13B在数学AIME2024和AIME2025测试中分别取得了87.3和76.8的高分,超过了DeepSeek-R1和OpenAI的o1模型。在Agent智能体BFCL-V3、ComplexBench、C-TurcBench测试中,Hunyuan-A13B也大幅领先于DeepSeek-R1。在科研、代码、推理的测试中,两者的结果相近。

Hunyuan-A13B的架构由1个共享专家和64个细粒度非共享专家组成,所有专家的中间维度相同。在训练阶段,共享专家始终处于激活状态,而非共享专家中只有8个会同时被激活。模型在激活函数上采用了SWiGLU,并在注意力层中引入了Grouped-Query Attention,显著提高了KV缓存的内存效率。

在推理过程中,Hunyuan-A13B采用了双模式推理链框架,允许模型根据任务的复杂性和用户需求动态调整推理深度。快速思考模式为简单任务提供快速、高效的解决方案;慢速思考模式则适用于更复杂的任务,如多步推理问题。

在后训练阶段,Hunyuan-A13B采用了结构化的多阶段方法,包括推理导向的监督微调(SFT)和强化学习(RL)阶段,以及全场景监督微调和强化学习阶段。在推理导向的SFT阶段,模型专注于加强复杂推理导向任务的专业能力;在强化学习阶段,模型进一步增强了推理能力。

在全场景监督微调阶段,模型的适应性得到了进一步的拓宽,涉及在多样化指令-响应数据集上的监督微调。这一阶段的强化学习采用了双重信号优化方法,不仅评估最终输出的正确性,还通过一个大型语言模型作为智能体评估器来评估风格质量、连贯性和适应性。

为了进一步提升模型在特定领域的表现,Hunyuan-A13B在全场景强化学习阶段引入了多个专门的奖励服务和数据构建流程。这些服务和流程针对不同的能力领域进行了优化,确保模型在各个领域都能达到高标准的表现。在智能体任务中,模型需要能够有效地调用工具,并根据工具的反馈进行合理的决策。在复杂指令任务中,模型需要能够精确地理解和执行多方面的指令。在安全领域,模型需要能够识别和避免潜在的风险和不当内容。

原文和模型

【原文链接】 阅读原文 [ 1824字 | 8分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆