如何优化测试时计算?解决「元强化学习」问题

文章摘要

【关 键 词】 大模型优化、测试时计算、元强化学习、数据效率、自适应策略

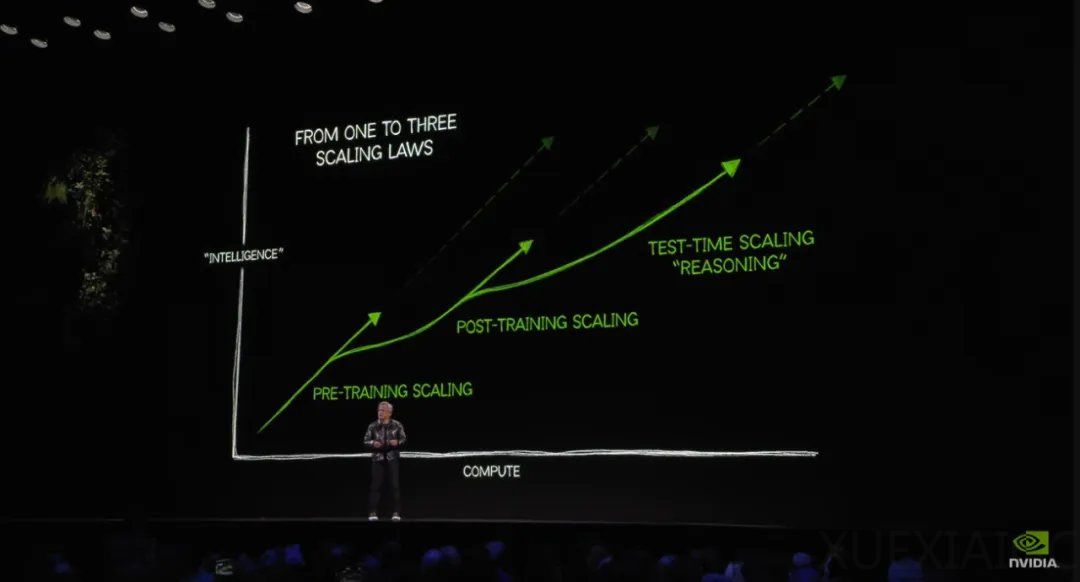

当前改进大型语言模型的主流方法依赖于增加高质量数据的监督微调或强化学习,但数据扩展面临瓶颈。研究预测,用于训练的高质量文本可能在2028年耗尽,而复杂推理任务需要的数据量需增加百倍才能显著提升性能。这一现实催生出对数据高效方法的需求,其核心在于改变训练目标,通过测试时计算资源的高效利用突破现有局限。

传统训练范式通过监督学习直接匹配输入输出映射,虽能处理分布内任务,却难以应对分布外查询的复杂性。新方法提出将模型训练重点从“输出答案”转向“探索答案生成策略”,使模型在测试时能通过多步骤推理动态调整解决方案。这种范式要求模型具备系统性程序执行能力,例如在数学证明中根据问题难度调用不同定理组合,通过消耗更多token实现泛化能力跃升。

为实现这一目标,研究团队构建了元强化学习框架。每个问题被形式化为独立马尔可夫决策过程,模型响应被视为策略执行轨迹,其质量由奖励函数评估。测试时计算预算C定义了算法类A_C,模型需在有限token内完成问题解析、验证迭代和答案优化。该框架将语言模型参数化为自适应策略,通过多轮自我修正提升响应质量,例如首轮生成尝试方案,后续轮次进行验证与改进。

元强化学习的核心挑战在于信息增益的有效捕获。模型在测试时生成的每个token都被视为对问题后验分布的动态修正,通过历史条件策略实现认知更新。不同于传统强化学习的静态策略,自适应策略允许模型在响应流中划分训练与测试回合,前序token生成的信息直接影响后续决策。这种机制使固定规模的模型能够通过计算资源分配,模拟复杂后验推理过程。

技术实现层面,研究提出两种优化路径:黑盒方法直接最大化响应轨迹的累积奖励,抽象方法则通过估计信息增益构建奖励函数。前者适用于可分段的响应结构(如生成-验证循环),后者处理连续token流的全局优化。实验表明,赋予模型测试时计算自主权后,相同参数量模型在数学推理等复杂任务上的准确率提升显著,验证了“计算换数据”策略的有效性。

该研究为突破大模型数据依赖提供了新方向,通过重构训练目标使模型从答案复现者转变为策略探索者,为应对未来数据短缺挑战开辟了可行路径。其提出的元强化学习框架不仅适用于纯文本生成场景,也为集成外部工具的多模态推理系统奠定了理论基础。

原文和模型

【原文链接】 阅读原文 [ 3370字 | 14分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-r1

【摘要评分】 ★★★★★