文章摘要

【关 键 词】 数据合成、AI训练、数据偏差、模型退化、数据审查

AI领域正面临真实数据获取难度增加的问题,导致合成数据训练AI模型的方法受到关注。合成数据通过模拟和推断新数据条目,解决了标注成本高、人类标注速度有限、偏见和错误等问题。华盛顿大学博士生Os Keyes将合成数据比作生物燃料,认为其可以创造且无真实数据的负外部性。AI行业已开始实践这一概念,如Writer公司的Palmyra X 004模型几乎完全使用合成数据训练,成本远低于OpenAI模型。微软、谷歌、英伟达和Hugging Face也在合成数据领域有所布局。

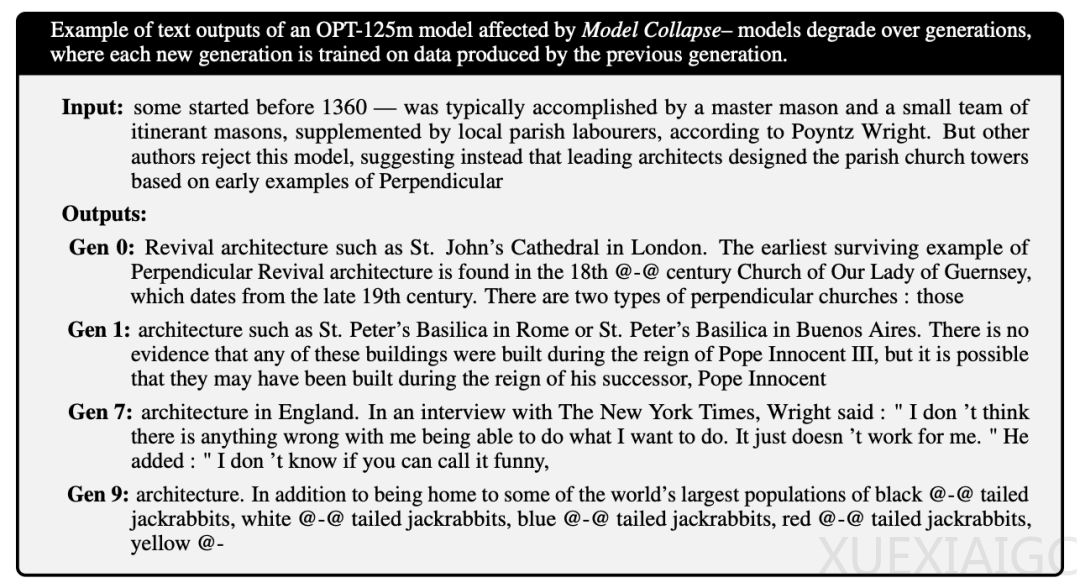

然而,合成数据并非万能。它存在“垃圾进垃圾出”的问题,即如果训练数据存在偏差,合成数据的输出也会受影响。莱斯大学和斯坦福大学的研究发现,过度依赖合成数据会导致模型质量或多样性下降。复杂模型如OpenAI o1使用合成数据可能产生更难发现的幻觉,降低模型准确性。《自然》杂志上的研究也表明,错误数据训练出的模型会产生更多错误数据,导致模型退化。

艾伦人工智能研究所的Luca Soldaini指出,合成数据可用于生成不易获得的训练数据,但要安全使用,必须彻底审查、整理和过滤,最好与真实数据搭配使用。否则可能导致模型崩溃,影响功能。研究人员需要检查生成数据,迭代生成过程,并采取保障措施去除低质量数据点。目前,还没有大型AI实验室发布过仅使用合成数据训练的模型,人类在模型训练中仍扮演重要角色。

原文和模型

【原文链接】 阅读原文 [ 2842字 | 12分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...