可解释性终极追问,什么才是第一性解释?20篇CCF-A+ICLR论文给你答案

文章摘要

【关 键 词】 神经网络、可解释性、泛化性、交互理论、动力学规律

本文由张俊鹏、任启涵、张拳石撰写,基于等效交互可解释性理论体系,深入探讨了神经网络在训练过程中概念表征及其泛化性的动力学变化。文章首先回顾了等效交互可解释性理论体系,该理论体系通过20篇CCF-A及ICLR论文,为解释神经网络的内在机理提供了理论基础。作者指出,可解释性领域的第一性原理应能全方位精确严谨地解释神经网络内在机理。

文章从三个角度解释神经网络的内在机理:首先是语义解释的理论基础,通过数学证明神经网络的决策逻辑可以被少量符号化逻辑所覆盖;其次是寻找性能指标背后的可证明、可验证的根因,将神经网络泛化性和鲁棒性等性能指标的根因拆分具体少数细节逻辑;最后是统一工程性深度学习算法,将前人的工程性经验总结为科学规律。

研究概述部分,作者希望在等效交互框架内提出新的理论,精确预测神经网络在每个时间点上所学到的交互概念的数量、复杂度,以及泛化性变化的动力学规律。文章提出了两方面的结论:一是推导出神经网络所建模的交互效用的变化动力学过程;二是证明交互复杂度的变化规律客观反映神经网络在全训练周期中泛化性变化的规律。

文章还讨论了与前人研究的关系,特别是与神经正切核(NTK)的比较,指出NTK虽然解出了参数变化曲线,但未能深入到决策逻辑层面进行解释,没有建立符号化概念逻辑与泛化性之间的严格关系。

在研究背景部分,作者指出两个常见的误会:一是神经网络的第一性表征是等效交互而非参数和结构;二是泛化性问题是一个混合模型问题,而非高维空间的向量问题。文章通过图2和图3展示了不同结构的神经网络在等效交互表征上的相似性,以及神经网络对单个样本的表征是mixture model的形式。

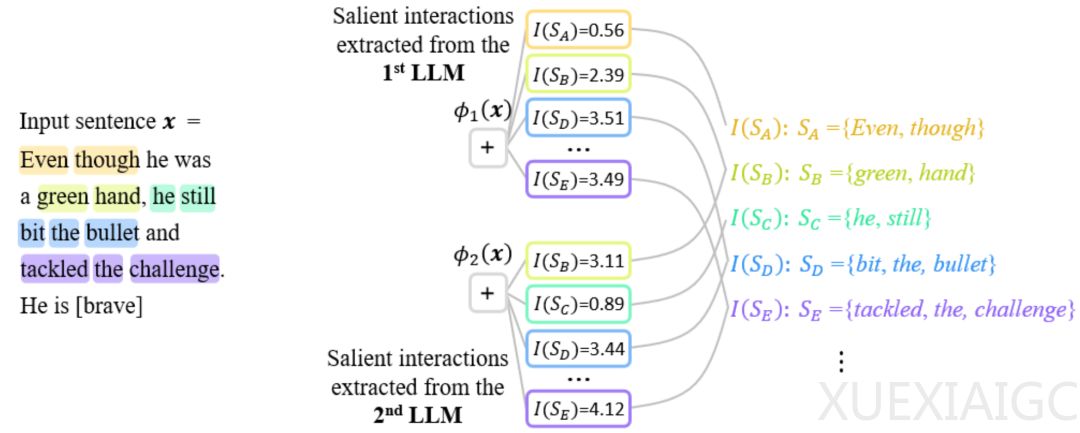

文章定义了神经网络中的等效交互,并提出了无限拟合性、稀疏性和样本间迁移性三条公理性准则。作者通过图4和图5展示了神经网络的复杂推理逻辑可以被基于少量交互的逻辑模型准确拟合。

在新的发现与证明部分,作者发现了神经网络在训练过程中交互变化的两阶段现象,并提出了两个指标来衡量不同阶交互的强度分布。图6展示了不同训练阶段的交互强度分布,以及与loss gap变化的对齐现象。文章进一步探讨了神经网络所建模交互的阶数和其泛化能力的关系,通过实验验证了高阶交互具有较差的泛化能力,低阶交互具有较强的泛化能力。

最后,文章理论证明了神经网络训练过程的两阶段现象,包括初始化神经网络建模的“纺锤形”交互分布,以及训练过程中交互变化的动态过程。通过将神经网络的inference改写为不同交互触发函数的加权和,作者将神经网络的学习看作是对一系列潜在ground truth交互的拟合。

整体而言,本文通过等效交互可解释性理论体系,深入分析了神经网络训练过程中的泛化性变化规律,提出了新的理论框架和实证分析,为理解神经网络的内在机理提供了新的视角和方法。

原文和模型

【原文链接】 阅读原文 [ 8931字 | 36分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★