只花9美元,推理能力暴涨20%!小模型Tina震撼登场,成本缩减260倍

文章摘要

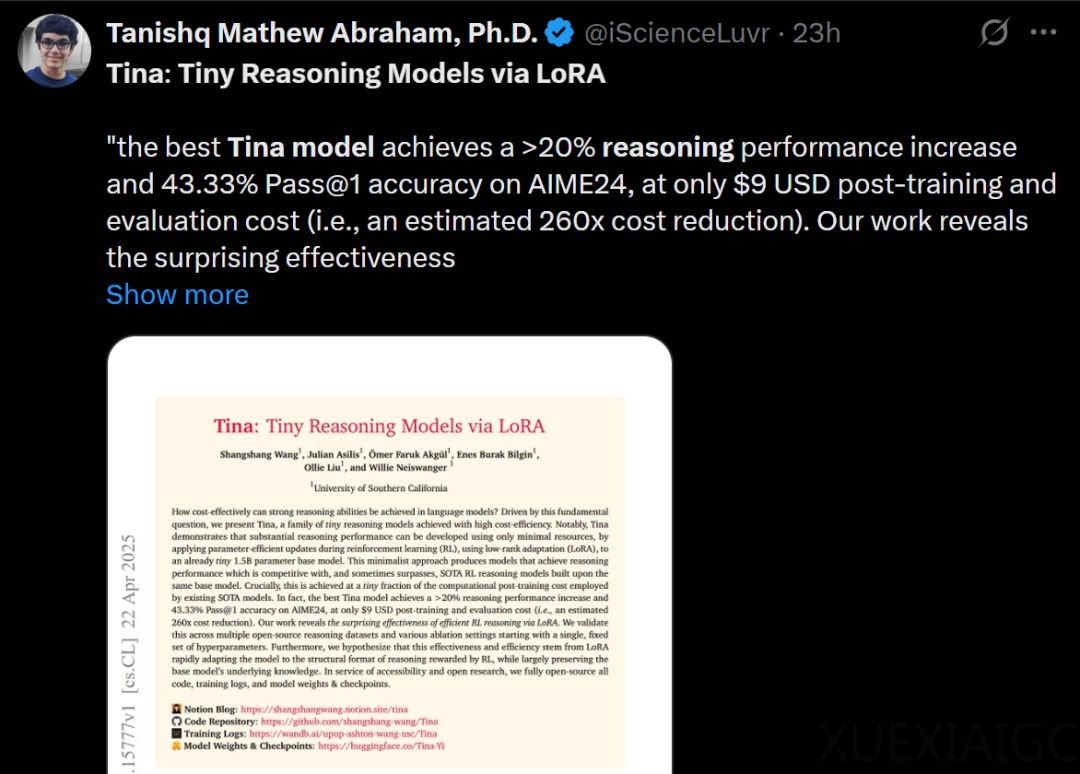

南加州大学的研究团队近期发表了一篇名为《Tina: Tiny Reasoning Models via LoRA》的论文,提出了一种通过低秩自适应(LoRA)技术实现的高效推理模型。该模型在资源有限的情况下,展示了强大的推理能力,为人工智能领域带来了新的突破。Tina 模型的核心创新在于将微型模型架构与基于 LoRA 的强化学习相结合,显著降低了计算成本和硬件需求。通过这种方法,团队成功实现了在极低预算下(仅 9 美元)复现最佳模型检查点,而完整实验的总成本也仅为 526 美元。

Tina 模型的基础是 DeepSeek-R1-Distill-Qwen-1.5B,团队通过 LoRA 技术对其进行后训练,创建了一系列微型推理模型。这些模型不仅在数学和科学推理任务中表现出色,还展示了快速适应不同推理格式的能力。实验表明,Tina 模型在多个基准测试中的表现优于或接近现有的最优推理模型,且训练时间大幅缩短。例如,Tina-Open-RS2 模型在六个推理任务中的平均得分达到 50.60%,而训练时间仅为完整周期的 19% 到 57%。

团队还通过一系列消融实验,深入研究了影响 Tina 模型性能的关键因素。结果表明,数据集的质量和多样性比规模更为重要,低秩配置(如秩 16 或 32)在保持高效性的同时,能够实现最佳性能。此外,强化学习算法 Dr.GRPO 在样本效率方面表现出色,能够更快地达到最佳检查点,进一步降低了训练成本。

Tina 模型的高效性还体现在其训练动态中。通过分析训练日志,团队发现基于 LoRA 的强化学习能够快速优化模型的结构和风格元素,而无需进行大规模的全参数更新。这种“少即是多”的现象表明,LoRA 通过极少的参数变化,能够有效提升模型的推理能力,同时保留基础模型的大量预训练知识。

尽管 Tina 模型在多个方面取得了显著成果,但仍存在一些局限性。首先,15 亿参数的基础模型在处理复杂多步推理问题时,可能无法达到更大模型的绝对上限。其次,当前的评估主要集中在数学和科学推理任务上,模型在其他领域(如编码)的有效性仍需进一步验证。最后,虽然团队有意减少了超参数调整,但进一步的优化可能会带来性能的进一步提升。

总体而言,Tina 模型为人工智能领域提供了一种高效、低成本的推理解决方案,展示了在有限资源下实现高性能的可能性。这一成果不仅为未来的 AI 应用开发提供了新的思路,也为更多研究者参与强化学习技术的探索开辟了道路。

原文和模型

【原文链接】 阅读原文 [ 5297字 | 22分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★