文章摘要

【关 键 词】 AI数据中心、GPU集群、华为技术、算力优化、云原生架构

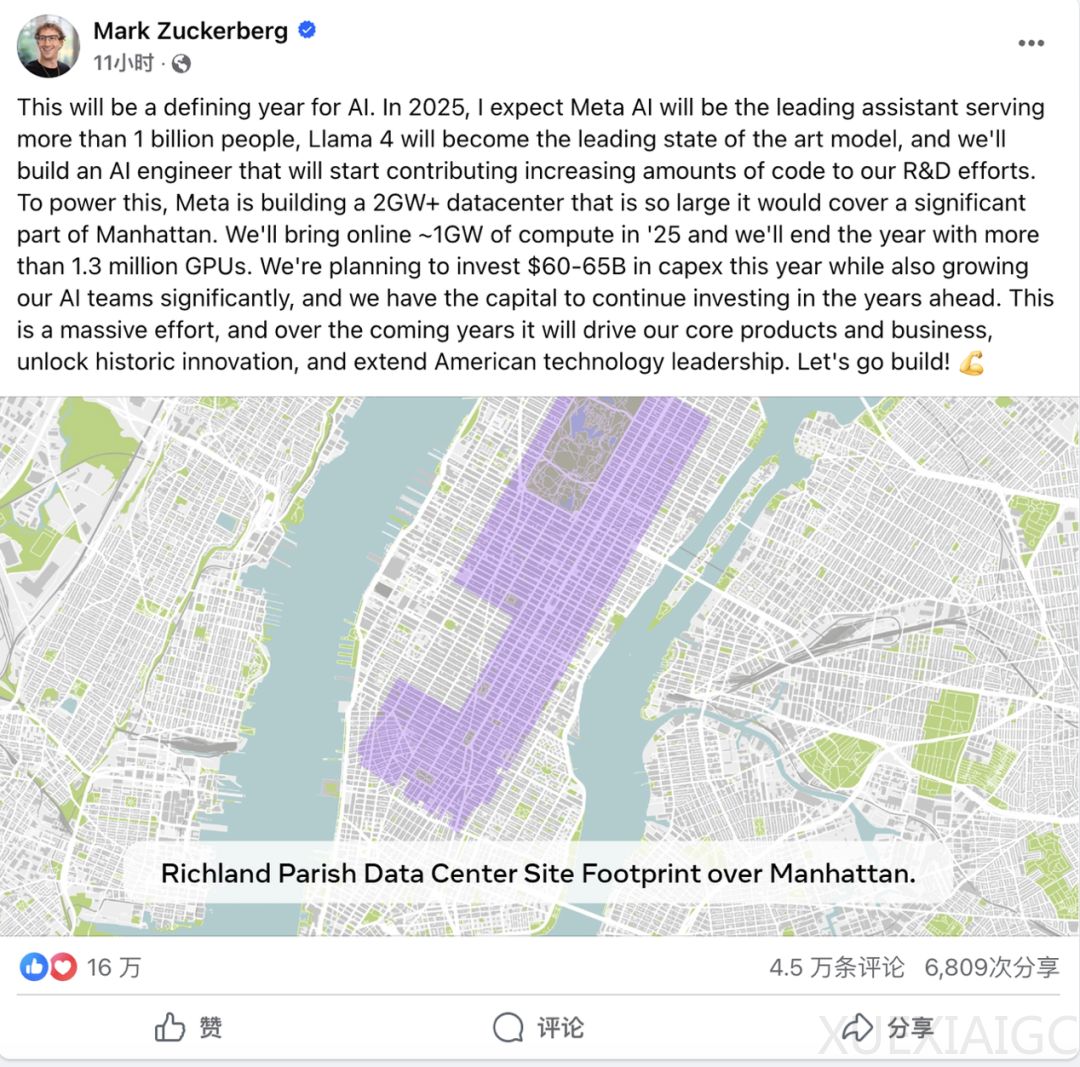

AI大厂在GPU采购上的投入持续加码,但单纯堆砌硬件已无法满足高效算力需求。马斯克的xAI计划将10万卡超算规模扩大10倍,Meta则投资100亿美元建设130万卡数据中心,然而GPU数量并非衡量AI实力的唯一标准。集群化模式下,通信瓶颈、内存碎片化和资源利用率波动等问题制约了GPU性能的充分发挥。华为近期发布的60页论文提出下一代AI数据中心架构设计Huawei CloudMatrix,其首代产品CloudMatrix384通过高带宽全对等互连和细粒度资源解耦,突破了传统堆卡模式的局限。

CloudMatrix384的核心优势体现在高效性、准确性和灵活性三方面。预填充吞吐量达6688 token/s/NPU,解码阶段1943 token/s/NPU,计算效率超越NVIDIA H100/H800;DeepSeek-R1模型在昇腾NPU上INT8量化的基准测试精度与官方API一致;支持动态调整推理时延SLO,在15ms严格延迟约束下仍维持538 token/s解码吞吐量。这种性能突破源于其将384个NPU、192个CPU等硬件集成到超级节点中,通过统一总线(UB)网络实现全对等直接传输,避免了传统网络的数据阻塞问题。

全对等互联架构是CloudMatrix384的硬件创新关键。传统集群中CPU需中转NPU通信,而UB网络采用Clos架构设计,提供392GB/s单向带宽,使NPU间传输延迟从10微秒降至1微秒以内。结合内存池化技术,所有NPU/CPU可直接访问跨节点内存,数据访问延迟从毫秒级降至微秒级。在671B参数的DeepSeek-R1测试中,token分发延迟降低62.5%,预填充计算效率达4.45 token/秒/TFLOPS,验证了架构在严苛延迟场景下的稳定性。

云原生软件栈使复杂硬件部署变得”零门槛”。MatrixResource、MatrixLink、MatrixCompute和MatrixContainer四大模块分工协作:动态管理资源分配、优化网络通信、实现弹性扩展、简化容器部署。顶层的ModelArts平台提供从开发到部署的全流程服务,用户无需关注底层细节即可调用API。内存池化技术使首Token时延降低80%,NPU购买量减少50%;万卡集群故障恢复时间控制在10分钟内,光模块故障影响降低96%。

该架构打破了算力、延迟和成本的”不可能三角”。通过全对等架构和软硬协同,在EP320专家并行模式下将token分发延迟控制在100微秒内。CloudMatrix-Infer采用分离式内存池等设计,使企业能动态调整资源规模,模型迁移效率提升6倍。目前该方案已在华为云四大节点上线,10毫秒时延圈覆盖全国19个城市群。

这代表着AI基础设施范式的根本变革。未来发展方向包括扩大节点规模与深度解耦:CPU/NPU资源将物理分离为专用池,注意力计算与解码路径解耦。华为描绘的自适应异构架构,将使计算资源成为可动态编排的抽象能力。这种变革不仅提升技术指标,更降低了AI应用门槛,为中国企业提供了可行的落地路径,如DeepSeek-R1模型从迁移到上线仅用72小时。云端专业化运维和弹性扩展特性,使得企业无需自建昂贵基础设施即可享受高性能算力服务。

原文和模型

【原文链接】 阅读原文 [ 4021字 | 17分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★