华为诺亚频域LLM「帝江」:仅需1/50训练成本,7B模型媲美LLaMA,推理加速5倍

文章摘要

【关 键 词】 Transformer、大语言模型、帝江架构、频域自注意力、计算效率

机器之心专栏近期介绍了一种基于频域的大语言模型架构——帝江,这一架构旨在解决现有大型Transformer模型在推理成本和训练成本上的问题。帝江模型通过频域自注意力变换核实现了对原始自注意力的线性逼近,允许模型在使用少量数据微调后,近乎无损地转换为帝江模型,显著降低了计算成本。

研究背景部分指出,Transformer架构自推出以来,在NLP领域取得了巨大成功,但随着模型规模的扩大,计算需求也急剧增加。为了提高效率,研究者们提出了线性Transformer、Mamba、RetNet等方案,这些方案虽然能够降低计算成本,但更换架构后需要重新训练模型,这一过程耗费巨大。帝江模型的提出,旨在通过频域映射减少这一成本。

方法介绍部分详细阐述了帝江模型的核心技术。传统的自注意力计算复杂度较高,而帝江模型通过引入频域离散余弦变换(DCT)和加权拟蒙特卡洛采样,将注意力机制中的softmax操作去除,实现了线性的计算复杂度。这种映射不仅降低了计算成本,而且理论上与原始注意力机制近似等效,因此可以在不重新训练的情况下,通过微调从Transformer参数中继承。

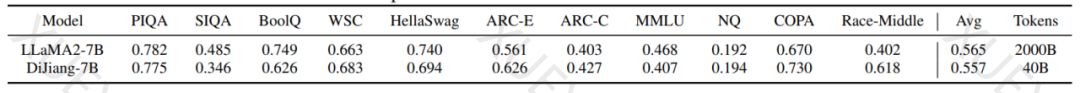

实验结果部分展示了帝江模型在不同规模上的性能,证明了其在保持精度的同时,推理速度和训练成本都有显著提升。帝江模型在1B模型量级上甚至超越了1.3B大小的Mamba模型。此外,帝江模型与其他Transformer改进方案相比,展现出更好的效果。

总结部分强调了帝江模型对未来大型语言模型高效部署的潜在影响。帝江架构在7B以下的模型量级上能够显著降低LLM的训练和计算成本,为未来LLM的发展提供了新的方向。同时,也期待帝江架构能在更大的模型和多模态VLM等其他领域中展现出色的性能。

原文和模型

【原文链接】 阅读原文 [ 2170字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-4

【摘要评分】 ★★★★★