文章摘要

【关 键 词】 图像生成、效率优化、模型改进、数据效率、零样本泛化

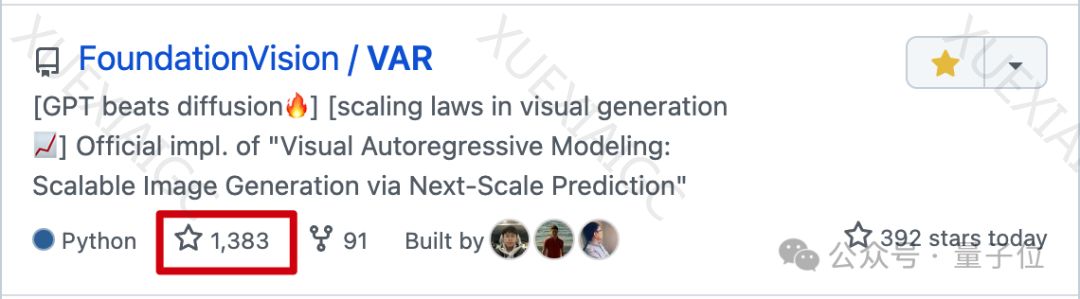

这篇文章介绍了北大和字节跳动合作开发的新方法——Visual Autoregressive Modeling(VAR),旨在改进图像生成的质量和效率。VAR采用了预测下一级分辨率的方式,取代了传统的预测下一个token的自回归方法。该方法分为两个阶段:首先使用VQ-VAE将图像编码为离散的token map,然后通过VAR Transformer预测更高分辨率的图像,以优化模型。VAR在图像生成质量、推理速度、数据效率和可扩展性等方面均超过了传统SOTA模型DiT。实验结果显示,VAR在ImageNet 256×256上将FID从18.65降至1.8,IS从80.4提高至356.4,同时提高了推理速度和数据效率。此外,VAR还展现出了与大语言模型相似的Scaling Laws和出色的零样本泛化能力。研究人员指出,采用这种方法,VAR更符合人类视觉感知的特点,能够保留图像的空间局部性。VAR的作者来自字节跳动AI Lab和北大王立威团队,包括田柯宇、袁泽寰和王立威等。他们的研究成果已经在GitHub上开源,引发了专业讨论。尽管有一些网友提出了一些问题,认为VAR在灵活性和分辨率上存在扩展问题,但该方法仍被认为是一种更便宜的通向Sora的潜在途径,可以降低计算成本。

原文和模型

【原文链接】 阅读原文 [ 1091字 | 5分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-3.5-turbo-0125

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...