作者信息

【原文作者】 AIGC开放社区

【作者简介】 专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

【微 信 号】 AIGCOPEN

文章摘要

【关 键 词】 AIGC、微软、苏黎世联邦理工学院、EgoGen、强化学习

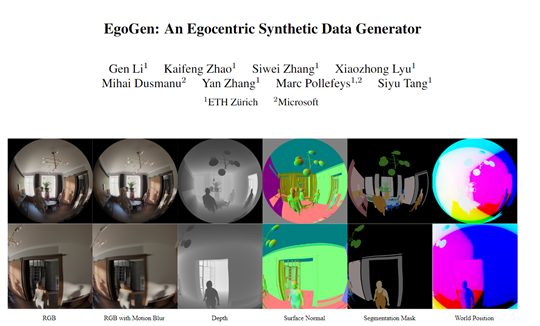

本文介绍了微软和苏黎世联邦理工学院研究人员共同开发的EgoGen模型,这是一个用于生成第一视角训练数据的工具,旨在解决AR/VR等设备在第一人称应用开发中遇到的挑战。

EgoGen通过创新的人体运动合成模型,利用虚拟人的自我中心视觉输入来感知3D环境,消除了对预定义全局路径的需求,适用于动态环境。

该模型结合了自我感知视觉代理的双阶段强化学习方案,通过“注意”奖励来激励自我感知行为,使虚拟人物的运动更加自然和逼真。

研究人员通过奖励函数引导虚拟人物的行为,使其在感知任务中更加专注和准确。

EgoGen在头戴式摄像头的建图和定位、摄像头跟踪以及从第一视角恢复人体网格等任务上进行了评估,显著提升了现有最先进算法的性能。

原文信息

【原文链接】 阅读原文

【原文字数】 1172

【阅读时长】 4分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...