刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

文章摘要

【关 键 词】 LLM推理、不确定性、浮点运算、批次不变、确定性推理

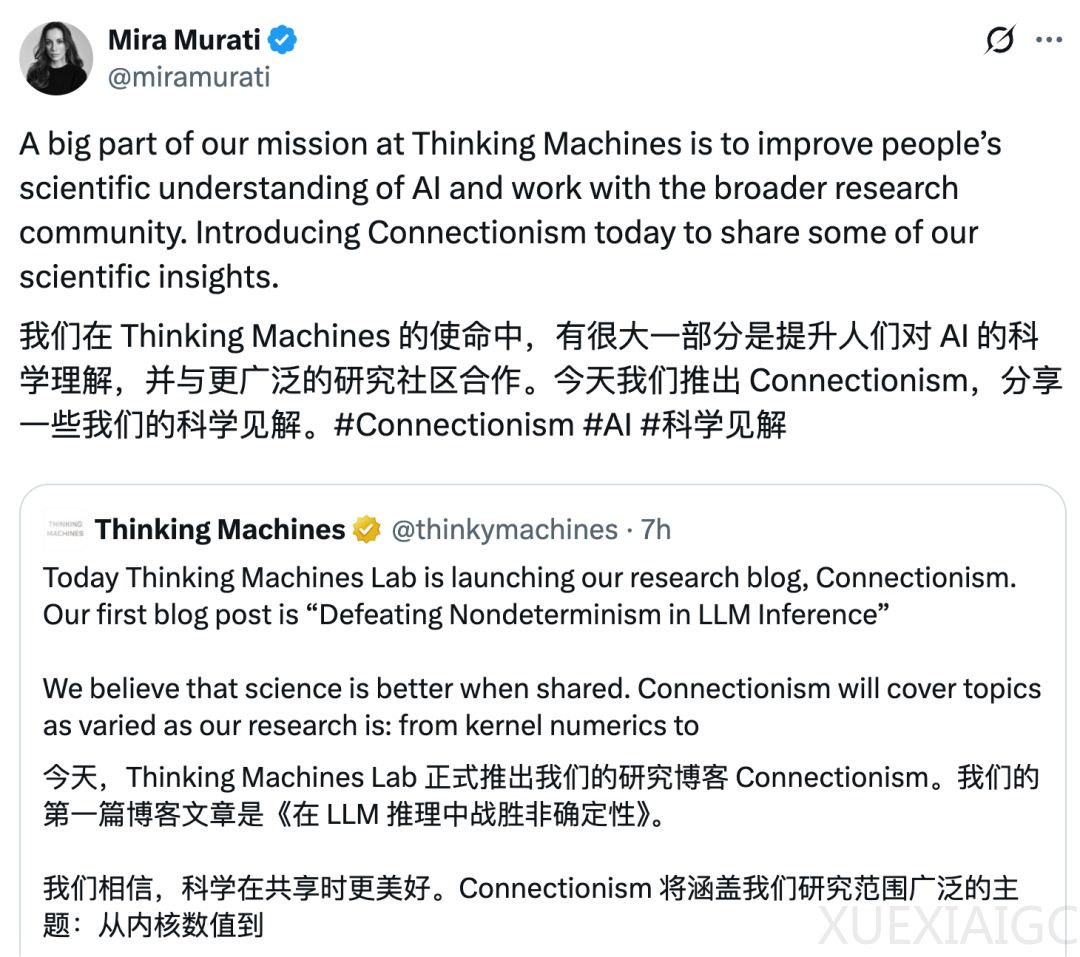

人工智能初创公司 Thinking Machines Lab 发布文章《克服 LLM 推理中的不确定性》,探讨大语言模型推理不确定性的原因及解决方法。

可复现性是科学进步的基石,但大语言模型推理很难获得可复现结果。即使将温度参数调为 0,或在自己硬件上用开源推理库运行,采样过程仍不确定。常见假设“LLM 推理不确定性的‘并发 + 浮点’假设”,认为浮点运算非结合性与并发执行组合导致不确定性,但这未揭示全貌。

浮点非结合性是数值差异的根源。浮点数因允许动态精度而有用,但不同阶位浮点数相加会导致信息丢失,每次以不同顺序相加结果可能不同,但这不能直接解释不确定性来源。现代 GPU 核函数多数情况无需原子加法,LLM 前向传播本质上是运行间确定的,但缺乏批次不变性会导致系统不确定。

批次不变性指矩阵乘法等操作的 batch size 变化时,batch 中元素计算结果应不变,但实际并非如此。服务器负载决定 batch size,影响请求最终结果,使大语言模型推理端点不确定。

为实现确定性,需确保核函数对 batch size 具有不变性。对于 RMSNorm,可忽略 batch size 小时的情况或使用在极小 batch size 下也能提供足够并行度的归约策略;矩阵乘法可编译固定核函数配置;注意力机制要更新 KV 缓存和页表,采用固定拆分大小策略。

实验表明,使用 Qwen3 – 235B – A22B – Instruct – 2507 模型,未启用批次不变性核函数时 1000 次采样有 80 个不同完成结果,启用后结果完全相同。性能方面,虽未优化批次不变性核函数,但性能未出现灾难性下降。此外,确定性推理能实现真正的在策略强化学习,在 Bigmath 实验中,实现采样器和训练器每一位结果相同可顺利训练。

原文和模型

【原文链接】 阅读原文 [ 7354字 | 30分钟 ]

【原文作者】 机器之心

【摘要模型】 doubao-1-5-pro-32k-250115

【摘要评分】 ★★★★★