刚刚,DeepSeek开源MoE训练、推理EP通信库DeepEP,真太Open了!

文章摘要

【关 键 词】 开源项目、MoE模型、高效通信、性能优化、FP8支持

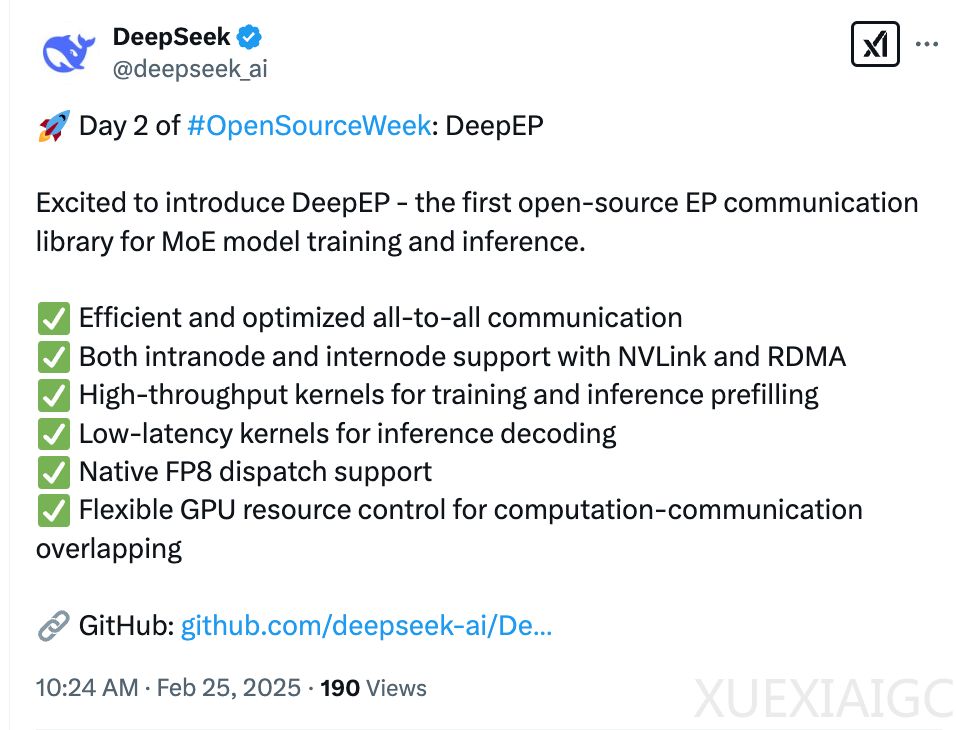

DeepSeek在开源周连续发布核心技术成果,继首日开源MLA解码核FlashMLA后,次日推出专为混合专家系统(MoE)设计的通信库DeepEP。该库针对分布式训练中专家并行的核心挑战,通过六项关键技术实现了突破:优化All-to-All通信效率、支持NVLink和RDMA跨节点通信、高吞吐量预填充计算核心、低延迟解码核心、原生FP8数据分发,以及创新的通信-计算重叠机制。这些改进有效解决了MoE模型在专家并行场景下的负载不均衡问题,显著提升了训练和推理效率。

技术测试数据显示,在H800 GPU集群环境下,常规内核通过NVLink实现约160GB/s带宽,配合CX7 InfiniBand网卡达到50GB/s跨节点传输能力。低延迟内核在典型生产配置中,针对128 token批处理量展现出优异性能。值得注意的是,开发团队通过逆向工程发现了未公开的PTX指令ld.global.nc.L1::no_allocate.L2::256B,该指令在Hopper架构上成功验证了安全性和性能增益,为通信效率带来意外提升。

开源社区对DeepEP反响热烈,项目上线即突破千星关注。业界专家评价其NVLink与RDMA的整合应用是”大规模MoE模型的革命性突破”,特别是FP8精度支持显著降低了通信开销。此前针对DeepSeek-R1模型的质疑,如训练效率来源和GPU资源使用透明度等问题,也通过本次技术开源获得了部分解答。

该库实现了与DeepSeek-V3论文中group-limited门控算法的深度适配,针对非对称域带宽场景开发了优化内核。其创新性的hook-based资源调度方法,在不占用流式多处理器资源的前提下,实现了通信与计算的高效并行。项目文档特别提醒用户需根据实际硬件环境进行自动调优,默认配置已针对DeepSeek内部集群优化。

作为DeepSeek继MLA技术后的又一核心创新,DeepEP的发布进一步验证了其在AI基础设施层的技术积累。开源社区将其评价为”真正OpenAI的诞生标志”,而关于团队将在后续三天开源哪些项目,已引发行业高度期待。

原文和模型

【原文链接】 阅读原文 [ 1359字 | 6分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-r1

【摘要评分】 ★★★☆☆