再战Transformer!原作者带队的Mamba 2来了,新架构训练效率大幅提升

文章摘要

【关 键 词】 Transformer、注意力机制、Mamba模型、SSD框架、序列模型

自2017年提出以来,Transformer架构在AI大模型领域占据了主导地位,尤其是在语言建模方面。然而,随着模型规模的扩大和序列长度的增加,其局限性也逐渐凸显,尤其是自注意力机制的计算量会随上下文长度的增加呈平方级增长。Mamba模型的提出改变了这一局面,实现了与上下文长度的线性扩展,并在中小型规模上与Transformers相媲美甚至超越。

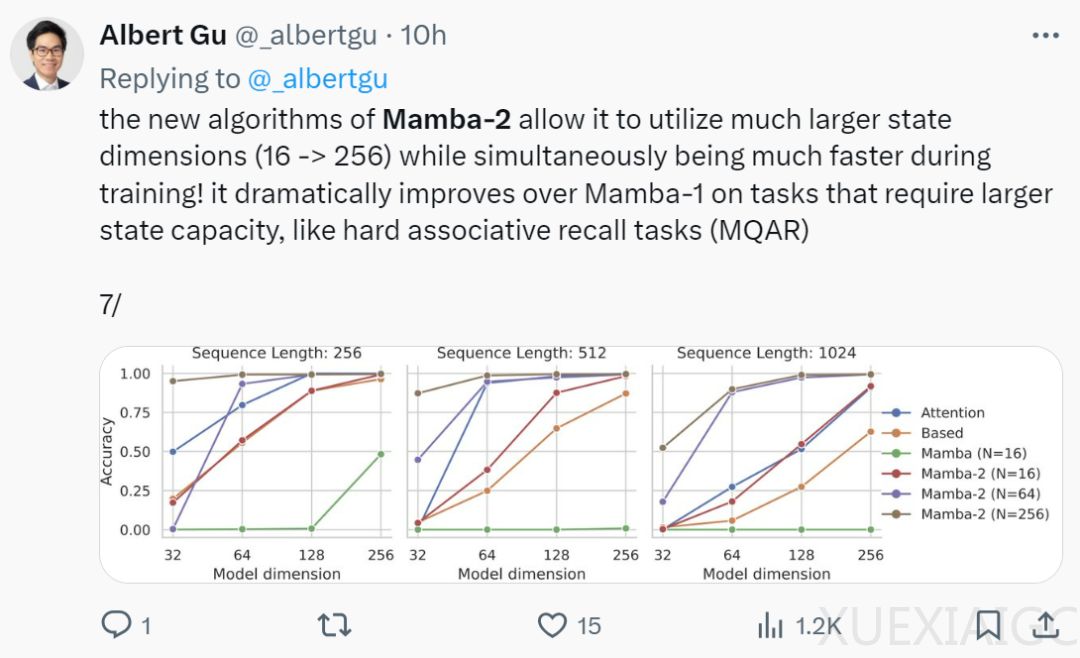

Mamba的两位作者推出了更强大的Mamba-2模型,该模型通过引入SSD(状态空间对偶性)框架,显著提高了线性注意力的理论,并推广到一种新的结构化掩码注意力家族。Mamba-2在核心层对Mamba进行了改进,速度提高了2-8倍,同时在语言建模方面继续保持与Transformers的竞争力。

研究团队构建了一个丰富的SSD理论框架,揭示了状态空间模型与结构化矩阵族之间的等价性。这一框架不仅为理解和改进序列模型提供了新的方向,还促进了计算SSM的高效算法的发展。通过将SSM与结构化注意力联系起来,研究者证明了任何具有快速循环形式的核注意方法都是SSM。

在架构设计上,Mamba-2通过改进,使得新架构能够利用张量并行等扩展方法,更适合现代加速器。研究者还发现,混合模型如Jamba、Zamba通过增加注意力层来提高模型质量,而结合注意力层与Mamba-2层,表现优于Transformer++和纯Mamba-2。

系统优化方面,SSD框架连接了SSM和Transformer,允许利用为Transformer开发的丰富的系统优化工作。在算法层面,SSD框架为计算SSM提供了新的高效且易于实现的算法,其在处理长序列时表现尤为出色。

总之,Mamba-2的推出标志着在序列模型领域的一个重要进展,其在理论创新和实际应用上的突破,为未来更高效、更强大的AI模型的发展奠定了基础。

原文和模型

【原文链接】 阅读原文 [ 4460字 | 18分钟 ]

【原文作者】 机器之心

【摘要模型】 glm-4

【摘要评分】 ★★★★★